- ارتباط با ما

- |

- درباره ما

- |

- نظرسنجی

- |

- اشتراک خبری

- |

- نگارنامه

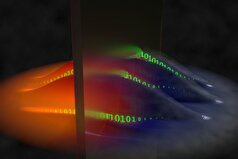

هوش مصنوعی در خدمت هکرهای کامپیوتری

به گزارش مجله خبری نگار-پاریس: ناظران نگرانند که چتباتها و برنامههای جعل اسناد مبتنی بر هوش مصنوعی بتوانند کار جرایم سایبری و کلاهبرداران آنلاین را تسهیل کنند. این برنامهها حدود یک سال است که برای استفاده عمومی در دسترس هستند، بدون اینکه ماهیت حملات سایبری سنتی را به طور اساسی تغییر دهند.

ابزارهای فیشینگ بهتر

فیشینگ شامل تماس با یک فرد هدف و وادار کردن او به وارد کردن اطلاعاتش در یک وبسایت هکشده است که شبیه وبسایت اصلی به نظر میرسد.

جروم بلویس، متخصص امنیت فناوری اطلاعات در شرکت مشاورهای Wavestone و نویسنده کتابی در مورد حملات سایبری، با ارسال ایمیلهای قانعکننده و عاری از غلطهای املایی، توضیح میدهد: «هوش مصنوعی حملات را تسهیل و تسریع میکند.»

هکرها در حال تبادل برنامههایی هستند که به آنها امکان میدهد بهطور خودکار پیامهای جعلی هدفمند، چه از طریق انجمنهای آنلاین و چه از طریق پیامهای خصوصی، تولید کنند.

برای غلبه بر محدودیتهای اعمالشده بر هوش مصنوعی توسط ارائهدهندگان راهکار، گروههای تخصصی از تابستان امسال، مدلهای زبانی آموزشدیده برای تولید محتوای مخرب را بازاریابی کردهاند، مشابه برنامه FrodGPT. اما اثربخشی آن هنوز باید اثبات شود.

بلوا هشدار میدهد: «ما هنوز در آغاز راه هستیم.»

خطر نشت دادهها

طبق مطالعه اخیر گارتنر، هوش مصنوعی مولد یکی از پنج تهدید اصلی است که کسبوکارها از آن میترسند.

شرکتها، به ویژه در این حوزه، از نشت دادههای حساس به اشتراک گذاشته شده توسط کارمندان خود میترسند و همین امر باعث شده است که شرکتهای بزرگی از جمله اپل، آمازون و سامسونگ، استفاده از ChatGPT را برای کارمندان خود ممنوع کنند.

ران شاو، مدیر تحقیقات گارتنر، توضیح میدهد: «هر اطلاعاتی که در یک ابزار هوش مصنوعی مولد وارد شود، میتواند در فرآیند یادگیری آن گنجانده شود، که میتواند منجر به نمایش اطلاعات حساس یا محرمانه در نتایج جستجوی سایر کاربران شود.»

اوت گذشته، OpenAI، توسعهدهنده ChatGPT، نسخه حرفهای ChatGPT Enterprise را که از چتها برای یادگیری استفاده نمیکند، راهاندازی کرد تا به شرکتهایی که از نشت اطلاعات میترسند، اطمینان خاطر دهد.

گوگل به نوبه خود توصیه میکند که کارمندانش اطلاعات محرمانه یا حساس را در ربات چت خود، بارد، وارد نکنند.

جعل اسناد صوتی و تصویری

تهدید جدید اصلی برای هوش مصنوعی، سهولت کپی کردن چهرهها و صداها و ایجاد تطابقهای دقیق است. با ضبطی که فقط چند ثانیه طول میکشد، برخی از ابزارهای آنلاین به شما امکان میدهند یک کپی دقیق ایجاد کنید که ممکن است همکاران یا اقوام قربانی آن شوند.

جروم سائز، بنیانگذار Obvious Intelligence، معتقد است که این ابزارها میتوانند به سرعت توسط «گروهی کامل از بازیگران درگیر در کلاهبرداریهای کوچک، که حضور پررنگی در فرانسه دارند و اغلب پشت کمپینهای مخربی هستند که از پیامک برای به دست آوردن شماره کارتهای بانکی استفاده میکنند»، مورد استفاده قرار گیرند.

او افزود: «این مجرمان جوان که عموماً جوان هستند، به راحتی قادر به تقلید صداها خواهند بود.»

در ماه ژوئن، یک مادر آمریکایی پس از تماس مردی با او و درخواست باج در ازای آزادی دخترش که ادعا میکرد ربوده شده است، قربانی کلاهبرداری شد. این مرد چیزی را پخش کرد که ادعا میکرد صدای جیغهای دختر قربانیاش است. این حادثه بدون هیچ تلفاتی پایان یافت، چرا که پلیس به کلاهبرداری مبتنی بر هوش مصنوعی مشکوک شد.

بلوا توضیح میدهد که برای شرکتهایی که از قبل با تاکتیکهای کلاهبرداری گسترده شامل جعل هویت مدیرعامل شرکت برای دریافت حوالههای مالی آشنا هستند، «استفاده از یک کلیپ صوتی یا تصویری جعلی» توسط یک هکر «میتواند ورق را به نفع آنها برگرداند».

هکرهای مبتدی

سائز معتقد است که «هیچکدام از حملات موفق سال گذشته نشان نمیدهند که نتیجهی استفاده از هوش مصنوعی مولد بودهاند.»

اگرچه چتباتها قادر به شناسایی برخی از نقصها و تولید قطعات کد مخرب هستند، اما قادر به اجرای مستقیم آنها نیستند.

در مقابل، سائز معتقد است که هوش مصنوعی «به افراد با استعداد محدود اجازه میدهد مهارتهای خود را بهبود بخشند» و این احتمال را که «کسانی که از صفر شروع میکنند بتوانند برنامههای رمزگذاری شده را با استفاده از ChatGPT توسعه دهند» رد میکند.

(خبرگزاری فرانسه)

- لطفا از نوشتن با حروف لاتین (فینگلیش) خودداری نمایید.

- از ارسال دیدگاه های نا مرتبط با متن خبر، تکرار نظر دیگران، توهین به سایر کاربران و ارسال متن های طولانی خودداری نمایید.

- لطفا نظرات بدون بی احترامی، افترا و توهین به مسئولان، اقلیت ها، قومیت ها و ... باشد و به طور کلی مغایرتی با اصول اخلاقی و قوانین کشور نداشته باشد.

- در غیر این صورت، «نگارمگ » مطلب مورد نظر را رد یا بنا به تشخیص خود با ممیزی منتشر خواهد کرد.

- آخرین اخبار

- محبوب

- برچسب های داغ

- سوپرجام عربستان از الاهلی پس گرفته میشود و به النصر میرسد؟ پاسخ فدراسیون فوتبال عربستان سعودی

- ده باشگاهی که بیشترین هزینه را در بازار نقل و انتقالات تابستانی انجام دادند

- جنسیت و سن بیولوژیکی: چرا روند پیری مردان و زنان متفاوت است؟

- گرت بیل توضیح میدهد که چرا استفن کری الگوی اوست: «دوست دارم مثل او باشم»

- هوشمندانه وزن کم کنید: چگونه کالری روزانه را محاسبه کنیم

- یک علامت هشدار دهنده که فقط شریک زندگی شما متوجه آن میشود: متخصصان علائم اولیه ناباروری مردان را آشکار میکنند

- وودی آلن: ترامپ بازیگر خوبی است و اگر به من اجازه دهد، میتوانم با او روی پرده سینما معجزه کنم

- اندازه گردن شما میتواند نشاندهنده مشکلات پنهان سلامتی باشد

- «معاشقه با امباپه»: آلیشیا لمن جانشین کریستیانو رونالدو و مسی را انتخاب میکند

- شیر کامل... چه زمانی برای کبد خطرناک است؟

- توهم کسب درآمد از موسیقی... کلاهبرداران نوجوانان را به سمت یک هرم مالی جدید جذب میکنند

- دلایل پنهان خوابآلودگی مداوم

- ویدئویی که سفر طاعون سیاه در بدن را با جزئیات وحشتناک نشان میدهد

- جوایز نقدی هنگفت برای شرکتکنندگان در لیگ قهرمانان اروپا برای فصل ۲۰۲۵-۲۰۲۶

- دانشمندان کشف کردهاند که کدام افراد مستعد حسادت و رشک هستند

- چرا نباید میل به ادرار کردن را سرکوب کرد؟

- تاجری به لطف بازی Labobo به فهرست ۱۰ میلیاردر برتر با رشد ثروت پیوست

- واکنش سلنا گومز به نامزدی تیلور سویفت

- خشم بین جسم و ذهن: آسیبهای آن و راههای مقابله سازنده با آن

- باستان شناسان اسرار فست فود روم باستان را در مایورکا فاش کردند

- پزشک ناخوشایندترین عفونتهایی را که ممکن است هنگام شنا به آنها مبتلا شوید، نام میبرد.

- سقوط نرخ باروری و اوجگیری ناباروری به مرز هشدار رسید!

- بیماریهای ویروسی که در ایران جولان میدهند!

- شب بیدارها بخوانند!

- کشف نکاتی جالب در مورد سیارک بن نو!

- چگونه انرژی مورد نیاز روزانه مان را دریافت کنیم؟

- دو ویتامین برای داشتن عمر طولانیتر!

- روشی نوین برای تبدیل گلیسرول زائد حاصل از تولید بیودیزل به گاز سنتز!

- نارسایی کلیوی درمان جدیدش را پیدا کرد!

- افسردگی در ساختار مغز نمایان میشود!

- والدین میتوانند چتجیپیتی را کنترل کنند!

- تشخیص و تسکین کولیک نوزادان به کمک سیستم مبتنی بر هوش مصنوعی!

- تشخیص دیابت تنها با نفس کشیدن ممکن شد!

- وقتی هوش مصنوعی به درمان ناباروری کم میکند!

- کدام کشورها بیشتر درگیر چت جی پی تی هستند؟

- ویتامینهای B در کدام غذاها موجود است؟

- باید واکسن آنفلوآنزا بزنیم؟

- یک اسپری بینی مخصوص آلرژی از عفونتهای ویروس کرونا جلوگیری میکند!

- چرا لاکهای ژل ناخن ممنوع اعلام شدند؟

- راز خواب کشف شد!

- امکان ارتباط با یک تمدن پیشرفته بیگانه در کهکشان راه شیری!

- احتمال بروز خاموشی به دلیل طوفان خورشیدی!

- بدن ما به چقدر پروتئین نیاز دارد؟

- نسل جدیدی از فر خانگی مجهز به هوش مصنوعی!

- گزارش نخستین روز از مسابقات جهانی المپیک رباتها!

- شواهدی از نخستین گروههای انسانی بیرون از آفریقا کشف شد!

- باکتری عجیب با تعداد کد ژنتیک کمتر!

- علائم اولیه سکته مغزی را جدی بگیرید!

- مصرف زیاد آب باعث چاقی میشود؟

- مصرف آب چغندر مناسب برای کاهش فشار خون!

- دخانیات چه تاثیر سو بر سلامتی دارد؟

- رازهایی عجیب در مورد یک زیردریایی در سونامی!

- جداول حجیم بدون نیاز به برنامهنویسی تحلیل میشوند!

- برای خرید سرور مجازی به این نکات دقت کنید!

- اگر قصد بوتاکس معده دارید، بخوانید!

- بهترین زمان مصرف سالاد چه زمانی است؟

- میوهها و سبزیهای تازه مناسب برای فصل تابستان!

- گرما به کدام بخش مغز آسیب میزند؟

- بیشتر جمعیت سالمندان کشور زن هستند یا مرد؟

- با خواص بینظیر آویشن آشنا شوید!

- وای فای خانه میتواند ضربان قلب کاربران را چک کند!

- غذاهای فوق فرآوری شده را کنار بگذارید تا لاغر شوید!

- تنبلی چشم در ایران کاهش پیدا کرد!

- بدون دارو قند خون خود را کنترل کنید!

- کشف یک رویکرد جدید و نجاتبخش برای نارسایی کلیوی!

- خواصی از شلیل که نمیدانستید!

- تاریخ مصرف واکسن آنفلوانزا را حتما چک کنید!

- بهبود خواب و کاهش استرس با مصرف تخم کدو!

- برنامهریزی رژیم غذایی را به عهده هوش مصنوعی نسپارید!

- این ویتامینها ضامن سلامت قلب شما هستند!

- نوشیدنی که میخورید بر سرنوشت رگهای مغزی تاثیر دارد!

- اهمیت مصرف نمک یددار!

- ترکیب طبیعی برای بهبود آسیبهای عضلانی!

- مصرف مشروبات الکلی چه تاثیری بر اندازه سنگ کلیه دارد؟

- میکروبها چه نقشی در فرایندهای مربوط به مغز دارند؟

- گروههای پرخطر باید واکسن آنفلوآنزا تزریق کنند!

- روان درمانی چه تاثیری بر ساختار مغز دارد؟

- برای پیشگیری از مشکلات گوارشی این نکات را رعایت کنید!

- چگونه بدون انجام کارهای طاقتفرسا لاغر شویم؟

- لبنیات مفید برای مقابله با سرطان!

- «ملکه کتامین» به جرم تهیه دارویی که منجر به مرگ یکی از مشهورترین کمدینهای جهان شد، اعتراف کرد

- عکس| جورجینا پس از اعلام نامزدیاش، با حضور ویژه در کنار کریستیانو رونالدو، فالوورهایش را شگفتزده کرد

- ستاره جیمز باند برای اولین بار درباره طلاقش صحبت کرد

- وودی آلن میگوید سینماهای آنلاین را دوست ندارد

- وودی آلن، جادوگر سینمای آمریکا، داستان اشتیاق خود به هنر هفتم و باله در روسیه را روایت میکند

- جان سینا عکس مسی را منتشر کرد| این کشتیگیر ۱۰ حضور در مسابقات WWE در کارنامهاش دارد

- وین رونی: ماموران امنیتی وقتی به لبران نزدیک شدم، من را با یک هوادار اشتباه گرفتند

- خواننده ژاپنی به خاطر درخواست از مترجم برای بردنش به دستشویی محکوم شد

- بازیگر زن مشهور به دلیل افسردگی مجبور به جن گیری شد

- روما زور راز خوشبختی خانواده را فاش میکند

- سیابیتووا گفت چه نوع زنانی را نباید به همسری گرفت: "سقراط هشدار داد"

- کیتی پری در کنسرت دچار برق گرفتگی شد

- لیل پامپ، رپر آمریکایی، تصادف کرد و به خدا ایمان آورد

- زویی کراویتز به خاطر مار، حمام تیلور سویفت را بهم ریخت

- پسر بکهام در دومین عروسیاش به والدینش توهین کرد

- عکس: زلاتان ابراهیموویچ به حمزات چیمایف به خاطر کسب عنوان قهرمانی در UFC ۳۱۹ تبریک گفت

- «باید دربارهاش از او بپرسی»| نظرات خندهداری که پس از اعلام نامزدی کریستیانو رونالدو و جورجینا رودریگز به آنها داده شد

- اما استون توضیح میدهد که کدام دوره از زندگیاش را خاص میداند

- الکس فرگوسن افسانهای پاسخ داد که اگر مسی در دهه ۱۹۵۰ بازی میکرد، چه اتفاقی برایش میافتاد

- پس از کریستیانو رونالدو، لواندوفسکی حمله به توپ طلا را آغاز کرد

- «او ما را خنداند»| خداحافظی محمد صلاح با ستاره جدید الهلال + عکس

- بازیکن منچسترسیتی: تشویق لیورپول نوعی ریاکاری است

- میکو رانتانن ستاره دالاس با آرسن ونگر عکس میگیرد

- قهرمان فوتبال هلند به جرم قاچاق مواد مخدر به هفت سال زندان محکوم شد

- ممکن است دختر آنا وینتور، بازیگر مشهور، جای او را در مجله ووگ بگیرد

- هنرمند مصری به اتهام قتل شوهرش و فروش اعضای بدن او محاکمه میشود؟

- همسر هافبک اسپارتاک از تلاش برای سرقت در پاریس در نزدیکی برج ایفل خبر داد

- همسر سابق بازیکن اسپارتاک در شبکههای اجتماعی از او انتقاد کرد: «او ما را در خیابان رها کرد»

- عکس| دخیا پیش از بازی فیورنتینا و منچستریونایتد با الکس فرگوسن دیدار کرد

- رونالدوی ۴۰ ساله آمادگی جسمانی فعلی خود را نشان میدهد

- کایلی جنر نشان داد که در کودکی چه شکلی بوده است

- تیم رپر دیدی در مورد عفو این نوازنده با دولت ریاست جمهوری ایالات متحده گفتوگو کرد

- سون هیونگ مین ۵ فوتبالیست مورد علاقهاش را معرفی کرد| ۴ برنده توپ طلا معرفی شدند

- شاهزاده هری درباره دعوایی که در آن «بینی شاهزاده اندرو را شکست» صحبت میکند

- جونگمن، ستاره سریال «من و پادشاه»، به جرم تجاوز و خفگی به زندان افتاد

- "من میتوانم با هزینه او زندگی کنم": عروس جوان لپس بعد از عروسی نقشه میکشد

- بلا حدید و هیلی بیبر قسم میخورند که: حقیقت در مورد مکمل "جادویی" که زیبایی و سلامت را افزایش میدهد چیست؟

- جاستین و هیلی بیبر در بحبوحه شایعات طلاق، میخواهند فرزند دوم داشته باشند

- «او مدام همسرم را فاحشه خطاب میکرد»: ریووا درباره باجگیری از مادرش

- عکس| یورگن کلوپ با ستارههای سابق NBA، دیرک نوویتسکی و استیو نش، پدل بازی کرد

- مشخص شد بردلی کوپر چه زمانی از جیجی حدید خواستگاری خواهد کرد

- کارگردان، وینونا رایدر را گیر انداخت و تهدید کرد که حرفهاش را خراب خواهد کرد

- جنیفر لوپز در تولد ۵۶ سالگیاش عکسی از دوران کودکیاش به همراه کیک منتشر کرد

- رسوایی جنسی جدیدی گریبان مائورو ایکاردی را گرفته است

- شوچنکو، اسطوره تیم ملی اوکراین، با قهرمان مطلق بوکس جهان، اوسیک، دیدار کرد

- حادثه تکان دهنده: مبارز MMA در دعوا با دختر، یک چشم خود را از دست داد

- «با کت و شلوار سفید. ۲۳ سال پیش...» ریو فردیناند در مورد امضای قرارداد با منچستر یونایتد

- هالند عکسی از تعطیلاتش را برای جشن تولدش منتشر کرد: «در نیمه راه ۵۰ سالگی!»

- قهرمان جهان روسیه درباره افسردگی پس از زایمان صحبت میکند

- راموس به واسکز که پس از ۱۰ سال رئال مادرید را ترک کرد، گفت: «به زودی میبینمت»

- انس جابر برای «کشف دوباره شادی زندگی»، بازنشستگی خود را از تنیس اعلام کرد

- La Nacion: الکسیس سانچز با مدل روسی رابطه برقرار کرد

- مسی جزئیات درگیری با رابرت لواندوفسکی در سال ۲۰۲۱ را فاش کرد

- سوفی ترنر رابطهاش را با نامزد سابقش از سر میگیرد

- النا دودینا درباره بارداری در ۳۶ سالگی: «شرمآور بود که هیچکس متوجه نشد»

- جنیفر آنیستون مظنون به داشتن رابطه جدید با یک هیپنوتراپیست است

- کایلی جنر به همراه تیموتی شالامی در تعطیلات در ایتالیا دیده شدند

- عکس| گروه اوئیسیز در اولین کنسرت خود پس از ۱۶ سال، به دیوگو ژوتا ادای احترام کردند

- دختر ۱۱ ساله تیماتی میخواهد مادر جوانی شود

- پس از یک "خیانت احتمالی"، نامزد فرمین لوپز، ستاره بارسلونا، عکسی از خودشان با هم منتشر کرد

- حمایت بانکها از بازار سرمایه از فردا اجرا میشود

- بورس سقوط کرده در دولت روحانی چگونه در دولت شهید رئیسی احیا شد؟

- درمان بورسی پزشکیان از زبان عبده

- جذب سرمایه ۷ همتی از بازار بورس دانشبنیانها

- وعده عناب بورسی واقعیتر شد

- چهارمین روز نزولی بازار در غیاب نیروهای صعودی

- انتخابات و دامنه نوسان مهمترین دلیل رکود فعلی بورس

- بورس با ۴ مصوبه دولت برای حمایت از بازار سهام سبزپوش میشود؟

- ۳ دلیل پایین بودن ارزش معاملات خرد در بورس

- معافیتهای مالیاتی بازار سرمایه باید استمرار پیدا کند

- بورس این روزها تحت تأثیر تداوم نرخ اخزای بالای ۳۵ درصد

- رشد شاخصهای بورس با کف سازی تکنیکال

- کاهش دامنه نوسان هم علاج بورس نزولی نبود

- سایه تامین مالی دولت بر سر بورس سنگینی میکند

- کاهش بی سابقه حجم معاملات سهام در بورسهای جهانی

- رشد شاخصهای بورس با کمک بانکیها و اعلام نرخ تسعیر ارز

- حمله به سفیر روسیه در لهستان

- معرفی سری گوشیهای Redmi K ۵۰ قبل از رونمایی رسمی

- غفوری: فکر کردن به قهرمانی از الان، سادهلوحانه است

- کاهش ۱۰ درصدی تولید هوندا در دو کارخانه

- سومین نشست دستمزد، باز هم بدون نتیجه

- لغو بلیت فروشی عمومی المپیک زمستانی چین

- گرامیداشت قربانیان هواپیمای اوکراینی در دانشگاه تورنتو

- ادامه چانهزنی چهارگانه در وین

- صرفهجویی ۱.۶ میلیارد دلاری کمیته برگزاری المپیک و پارالمپیک توکیو

- محبوبترین رشته المپیک توکیو مشخص شد

- اعلام هزینه میزبانی توکیو از المپیک و پارالمپیک ۲۰۲۰،

- آذرتاج: هیات اقتصادی جمهوری آذربایجان به ایران میرود

- بررسی عملکرد ایران در المپیک؛ جایگاه چهارمی در آسیا

- پایان وضعیت اضطراری در کشور میزبان المپیک ۲۰۲۰

- فقط برای آقایان!.. یک عارضه جانبی غیرمنتظره از رژیم کتو

- جریان مست و لایعقل اینبار هم ساز ضد زندگی زد

- واکاوی علت جالب تنفر فرزند به ازدواج

- از چایخانه و دفترچه مرموز تا ملکوت

- کنکور همچنان در جاده بیعدالتی

- گنجی پشت پوستهای سخت!

- درد قاعدگی در دختران نوجوان "علامت خطر" برای بیماریهای آینده است

- هوسهای غذایی عجیب... آیا میتوانند نشانه اولیه یک بیماری جدی باشند؟

- کلمات مخفی در "شادترین مکان جهان" فاش شد

- EJCN: رژیم غذایی مدیترانهای خطر فشار خون بالا را کاهش میدهد

- زنانی که بارداریهای پیچیدهای دارند، ممکن است در معرض خطر مرگ بیشتری باشند

- آسیبهای دوران کودکی، اثری دائمی بر عملکرد عضلات میگذارد

- PLOS ONE: مطالعه تایید میکند که رقصیدن برای کاهش وزن موثر است

- دانشمندان درباره خطرات مصرف بیش از حد مکملهای ویتامین هشدار میدهند

- مراقبت از دیابت: فعالیت بدنی عصرگاهی سالمتر است

- متخصصان محصولات مقرون به صرفهای را نام بردهاند که به حفظ جوانی پوست کمک میکنند.

- پزشک متخصص انتقال خون توضیح میدهد که چگونه کیفیت خون را بهبود بخشیم

- ویتامینهای C، E و بتاکاروتن خطر ابتلا به دیابت را در بزرگسالان کاهش میدهند.

- Healthline: روغن نارگیل درمانی برای کاهش وزن نیست

- چاقی: فعالیت بدنی با معده خالی به کاهش وزن کمک میکند

- آنتیبیوتیکها بر شدت یا مدت سرفه تأثیری ندارند

- PubMed: زنجبیل باعث کاهش وزن و بهبود نسبت دور کمر به باسن میشود

- میوه جدیدی که طعم انگور را با فواید توت قرمز ترکیب میکند

- دانشمندان گونهای از فلفل چیلی را نامگذاری کردند که حاوی ترکیبات مغذی کلیدی است

- تعریق بیش از حد هنگام استراحت را نادیده نگیرید| این میتواند نشانه یک بیماری جدی باشد

- پزشکان فواید کاکائو را برای زنان بالای ۵۰ سال توضیح دادند

- چگونه موقعیت مکانی خانه شما میتواند سلامت مغز شما را تهدید کند؟

- دکتر رورشیب محصولات ایدهآل برای خواب خوب را معرفی میکند

- مغز و اعصاب: مشاغل محرک شناختی خطر زوال عقل را کاهش میدهند

- باکتریهای خونآشام تشنه خون انسان هستند و باعث عفونتهای کشنده میشوند

- غذاهای ساده ممکن است سلاح مخفی شما در برابر بیماری قلبی و خطر مرگ زودرس باشند

- ورزش بعد از صبحانه قند خون را کاهش میدهد

- چاقی تنها دلیل پیری قلب نیست

- نوشیدنیهایی که به شما کمک میکنند با هوس شیرینیجات مبارزه کنید

- محققان مصری درمان امیدوارکنندهای برای کودکان مبتلا به اوتیسم ابداع کردهاند

- روانپزشکان ۷ روش علمی اثبات شده برای کاهش استرس را فهرست میکنند

- آریتمی فیبریلاسیون دهلیزی در جوانان شایعتر و خطرناکتر از آن چیزی است که قبلاً تصور میشد

- یک داروی جدید برای فشار خون بالا میتواند زندگی نیم میلیارد نفر را تغییر دهد!

- NCB: فشار در رحم ممکن است بر رشد صورت تأثیر بگذارد

- اخبار داغ

- ورزشی

- پربیننده

- پربحث

- زاخارووا شکایات رئیس جمهور فنلاند از کشورهای عضو سازمان همکاری شانگهای را توضیح داد

- رژیم غذایی که از سرطان پانکراس جلوگیری میکند، نامگذاری شد

- آمریکا از وجود یک پایگاه نظامی مخفی روسیه در «خاک آمریکا» خبر داد

- دانشمندان دریافتند که قرار گرفتن در معرض سرب، توانایی شمارش کودکان را مختل میکند

- غرب از گرجستان خواست جبهه دومی علیه روسیه باز کند

- دانشمندان برای اولین بار مشاهده کردند که چگونه اطلاعات در سیستمهای کوانتومی از بین میرود

- درخواست غیرمعمول ترامپ از هوادارانش برای اهدای ۱۵ دلار به بهشت

- اخترشناسان درون خوشه کهکشانی سوسیسی را بررسی میکنند

- وزارت امور خارجه چین پتانسیل روابط روسیه و چین را ارزیابی کرد

- یک پزشک توضیح داد که چرا ضربه به دندان شیری در کودک خطرناک است

- مشخص شده است که اروپا بر سر موضوع اعزام نیرو به اوکراین دچار اختلاف نظر است.

- چین واکنش پوتین به اولتیماتوم اتحادیه اروپا را تحسین میکند

- یک پزشک توضیح داد که چگونه میتوان با استفاده از آزمایش خون، ویروس را از باکتری تشخیص داد

- زلنسکی درباره پیشنهادهایی برای فرار از اوکراین صحبت کرد

- واکنش ناسا به وعده ماسک برای از رده خارج کردن دراگون

- ترامپ در پاسخ به سوال درباره جایزه صلح نوبل گفت: میخواهم جان انسانها را نجات دهم

- روشی ناشناخته برای پیشگیری از زوال عقل در سالمندان معرفی شد

- ترامپ درباره روابطش با پوتین و کیم جونگ اون صحبت میکند

- یک ساعت قلیان کشیدن معادل کشیدن ۱۰۰ نخ سیگار است

- سفارت از بریتانیا خواست از طرح «اتهامات بیاساس» علیه روسیه خودداری کند.

- محصولاتی که به رشد مو کمک میکنند، نامگذاری شدهاند

- بریتانیا وجوه مسدود شده روسیه را به اوکراین منتقل میکند

- ماژول قمری هاکوتو-آر ژاپنی پس از فرود گم شد

- ترامپ رئیس جمهور لهستان را به اجلاس گروه ۲۰ دعوت کرد

- دانشمندان برای اولین بار مشاهده کردهاند که چگونه مغز چندین نسخه از آنچه اتفاق میافتد را «در ذهن نگه میدارد».

- ایالات متحده و مکزیک بر همکاری خود در مبارزه با باندهای مواد مخدر و جرایم فراملی تأکید میکنند

- یک مقام اروپایی: خرید سالانه ۲۵۰ میلیارد دلار سوخت آمریکایی کاملاً غیرواقعبینانه است

- ترامپ به لهستان تضمینهای امنیتی داد

- دانشمندان از افزایش بیماریهای کبدی خطرناک و بدون علامت نگران هستند

- رهبر کره شمالی به پوتین اطمینان داد که کشورش به حمایت از روسیه در حفاظت از منافع امنیت ملیاش ادامه خواهد داد

- یک قاضی آمریکایی تصمیم دولت ترامپ برای قطع بودجه ۲.۶ میلیارد دلاری دانشگاه هاروارد را لغو کرد

- رئیس جمهور سابق فرانسه اظهارات مکرون درباره روسیه را محکوم کرد

- ژاپن نسل جدیدی از ترانزیستورها را ساخته است: کوچکتر، سریعتر و قابل اعتمادتر از ترانزیستورهای سنتی

- سیبیاس: دولت آمریکا در حال آماده شدن برای اخراج ۲۶۸ هزار مهاجر ونزوئلایی است.

- روسیه: یک کارگر در اثر رانش سنگ در معدن یاکوتیا جان باخت

- ترامپ آماده اعزام گارد ملی به بالتیمور است

- برای اولین بار لیزر برای اینترنت فوق سریع ساخته شد

- ترامپ، پوتین را با زلنسکی اشتباه گرفت

- استاتینها برای اولین بار اثر غیرمنتظرهای نشان میدهند

- مکرون از تکمیل آمادهسازی ضمانتهای امنیتی برای اوکراین خبر داد

- زمان ایدهآل برای شنا در آبهای خروشان برای بیماران قلبی تعیین شد

- پوتین به اظهارات ترامپ مبنی بر تبانی روسیه، چین و کره شمالی علیه ایالات متحده واکنش نشان داد

- مشخص شده است که پوتین چند جلسه در چین داشته است

- دانشمندان مولکولهای DNA ایجاد کردهاند که ویروسها را دقیقتر از آنتیبادیها تشخیص میدهند

- پوتین: رابطهام با ترامپ خوب است

- سفیر روسیه در برلین: اظهارات مرتس علیه پوتین غیرقابل قبول است

- رئیس جمهور سابق لهستان، دودا، تصمیم میگیرد در حرفه جدیدی استاد شود.

- دانشمندان دریافتهاند که چرا لنزهای مخصوص نزدیکبینی به همه کودکان کمک نمیکنند

- مدودف: فروپاشی نظم جهانی پس از جنگ جهانی دوم یکی از دلایل عملیات نظامی در اوکراین بود

- شوخی پوتین با پسکوف و خطاب کردن او به عنوان "تنبل"

- پوتین اذعان کرد که بین روسیه و آذربایجان مشکلاتی وجود دارد

- ناسا عکسی نادر از آتشفشان مریخی که از میان ابرها عبور میکند را منتشر کرد

- بیانیه مشترک مصر و سودان در مورد بحران سد النهضه اتیوپی

- عکس| بریژیت مکرون ویلای خانوادگی خود در شمال فرانسه را به قیمت ۳.۶ میلیون یورو فروخت

- ترامپ روابط خود با پوتین، شی جین پینگ و کیم جونگ اون را ارزیابی میکند

- رسوبات باستانی زیر اقیانوس آرام، تاریخ زمین را برای دانشمندان آشکار میکنند

- بلومبرگ: پروژه «قدرت سیبری ۲» دنیای گاز مایع را تکان خواهد داد و موازنه را تغییر خواهد داد

- پوتین توضیح داد که چگونه میتوان عدم تعادل در تجارت جهانی را حل کرد

- روسیه یک واحد برق جمع و جور برای جایگزینی ژنراتورهای دیزلی ایجاد کرده است

- سارکوزی: در نظر گرفتن روسیه به عنوان یک تهدید، یک اشتباه تاریخی است و ما در حال باختن این مناقشه سیاسی هستیم

- مکرون: کار بر روی تهیه ضمانتهای امنیتی برای اوکراین به پایان رسیده است

- پوتین غرب را به استفاده از اوکراین برای حل مشکلات اقتصادی متهم کرد

- دانشمندان افسانه نقرههای به غنیمت گرفته شده توسط دریاسالار هلندی در قرن هفدهم را رد کردند

- دادگاهی در ایتالیا تاریخ جدیدی را برای محاکمه مظنون بمبگذاری نورد استریم تعیین کرد

- دوگین از اهمیت منحصربهفرد اجلاس سازمان همکاری شانگهای برای کل جهان پرده برداشت

- دانشمندان قدیمیترین اجداد پروانهها را در مدفوع تریاس پیدا کردند

- پوتین در مجمع اقتصادی شرق دور (EEF) جلسهای در مورد توسعه مجتمع سوخت و انرژی در خاور دور برگزار خواهد کرد.

- دانشمندان دریافتهاند که طوفانها اقیانوس را تغذیه کرده و ساکنان آن را خفه میکنند

- پسکوف فاش کرد پوتین در پایان سفرش به چین با چه کسانی دیدار خواهد کرد

- دانشمندان مکانیسم جدیدی برای ترمیم DNA کشف کردند

- کرملین اعلام کرد که روابط روسیه، چین و کره شمالی علیه یکدیگر نیست.

- دانشمندان صدها ویروس غولپیکر جدید را کشف کردند که بر اکوسیستمهای اقیانوسی تأثیر میگذارند.

- انتقاد از مکرون به خاطر اظهاراتش درباره روسیه

- دانشمندان با استفاده از پروتزهای شبکیه به موشهای نابینا کمک کردند تا دوباره ببینند

- پس از یک تصمیم روسیه، اروپا از «سرنوشت از پیش تعیینشده» خود آگاه شد

- دانشمندان منبع غیرمنتظره و قدرتمندی از آلودگی هوا را در بیابانها کشف کردهاند

- استاب «پیروزی» فنلاند را در جنگ با اتحاد جماهیر شوروی اعلام کرد

- دانشمندان دریافتند که رنگهای خوراکی رایج باعث دیابت میشوند

- «بدون تبعیض»: اجلاس سازمان همکاری شانگهای خواستار اجازه رقابت ورزشکاران شد

- دانشمندان برای اولین بار از چگونگی تبدیل کرمهای انفرادی به یک ابرموجود زنده جمعی فیلمبرداری کردند.

- مسی، هافبک سیاتل، دِ لا وگا، را تهدید کرد که به تیم ملی آرژانتین دعوت نخواهد شد

- سرمربی آرژانتین در کنفرانس مطبوعاتی هنگام صحبت درباره مسی اشک ریخت

- ماتوی سافونوف در مورد موقعیت خود در PSG صحبت کرد

- سافونوف در پاسخ به اینکه آیا احساس میکند فصل در پاری سن ژرمن تا ابد ادامه دارد؟

- سافونوف در پاسخ به این سوال که آیا واقعبینانهتر است که پس از جدایی دوناروما، شماره یک پاری سن ژرمن شود؟

- پیاسجی در حال آمادهسازی برای یک خروج قابل توجه است

- دو هافبکی که جونی کالافات کنترل میکند

- لیگ جزیره همه رکوردها را شکست!

- آنچلوتی در مورد دعوت نکردن نیمار گفت: «برزیل تقریباً ۲۴ سال است که جام جهانی را نبرده است. ما نمیتوانیم اشتباه کنیم.»

- دوناروما، بازیکن جدید منچسترسیتی، بهترین تیم دنیا را انتخاب کرد

- ماتوی سافونوف: دلم برای کراسنودار تنگ شده و تیم را دنبال میکنم

- تهدید فراگیر عربستان سعودی

- باشگاه اتلتیک بیلبائو در مورد رسوایی آیمریک لاپورته صحبت میکند

- آنجلو استیلر مورد نظر اعلامیه مهمی صادر میکند

- «بیسابقه»: اریک تن هاگ با احساسی عمیق درباره اخراج از بایر صحبت میکند

- گابریل ژسوس، مهاجم آرسنال، از فهرست لیگ قهرمانان اروپا خط خورد

- ماتوی سافونوف گفت که چگونه پس از یک سال حضور در پاری سن ژرمن قویتر شده است

- سویا روایت خود از «پرونده خوانلو» را ارائه میدهد

- بلغارستان، جام جهانی، پدری... لوئیس د لا فوئنته وضعیت فعلی اسپانیا را تحلیل میکند

- ۵ نقل و انتقال گران قیمت تابستانی لالیگا ۲۰۲۵/۲۰۲۶

- لواندوفسکی در مورد بازگشت به میادین پس از مصدومیت گفت: «الان ۱۰۰٪ آمادهام.»

- ماتوی سافونوف، دروازهبان پاری سن ژرمن، نحوه خداحافظیاش با دوناروما را شرح داد

- نقطه عطف مارک کاسادو

- دوناروما در مورد لوئیس انریکه صحبت میکند

- فیفا جریمههای سنگینی علیه آرژانتین و آلبانی اعمال کرد

- غیبت تایید شده در باشگاه بیلبائو

- ادرسون: بازی برای منچسترسیتی خاصترین دوران زندگیام بود

- ناتینگهام در مورد انتقال زینچنکو گفت: «او بخش مهمی از منچسترسیتی بود.»

- سافونوف: میخواستم در جام باشگاههای جهان بازی کنم. سه ماه است که برای پاری سن ژرمن بازی نکردهام

- کودتای ۳۰ میلیون یورویی الاتحاد

- راه فراری برای اندریک در ژانویه؟

- روبن آلکاراز تیم جدیدی دارد

- ماتوی سافونوف به سوال در مورد زابارنی، هم تیمیاش در PSG، پاسخی نداد

- ایساک: همیشه از بازی برای لیورپول لذت بردم، امیدوارم بازی کردن برای آنها حتی بهتر هم باشد

- کنان ییلدیز، موضوع اولویتدار

- تنها نگرانی رئال بتیس

- اوریول رومئو، حالا چی؟

- واکنش باشگاه منچسترسیتی به انتقال دوناروما از پاری سن ژرمن

- دوناروما پس از انتقال PSG به منچسترسیتی بیانیهای منتشر کرد

- سافونوف: اگر من اصلاً برای پاری سن ژرمن بازی نکنم، این سوال پیش میآید: چرا تیم به من نیاز دارد؟

- چلسی مهاجم قرضی ساندرلند را کمتر از یک ماه پس از پیوستن به این تیم، فراخواند

- ماتوی سافونوف در مورد وظیفهای که برای خود در PSG تعیین کرده صحبت کرد

- پیچش غافلگیرکننده با ایمریک لاپورته!

- اینیگو مارتینز جدایی خود از بارسلونا را توجیه کرد

- هجوم برای جذب رائول آسنسیو در راه است!

- کانر گالاگر، از تقویت ناامید شد

- فرمین لوپز سکوت خود را میشکند!

- سویا جا برای خریدهای بیشتر دارد

- بایرن مونیخ در مورد رفتار جکسون در بحبوحه احتمال شکست در نقل و انتقالات چلسی صحبت میکند

- ایساک: چیزهای زیادی برای ارائه به لیورپول دارم، میخواهم فصل خوبی داشته باشم

- یوونتوس انتقال مهاجم کوزوو را اعلام کرد

- هزینههای چشمگیر آرسنال برای سلطنت در انگلیس

- مهاجم آیندهداری که توجه رئال مادرید را به خود جلب کرده است

- آنتونی از اولین بازی خود با رئال بتیس هیجان زده است

- بازیکن ۳۹ ساله سابق رئال مادرید با پیزا قرارداد امضا کرد

- اریک تن هاگ به دلیل اخراج از بایر، نزدیک به ۵ میلیون یورو دریافت کرد

- واکنش باشگاه منچسترسیتی به انتقال ادرسون به فنرباغچه

- لیل تابستانی پر از فراز و نشیب داشت

- استراسبورگ ۳۴ روز پس از جذب بازیکن چلسی، او را از تیم خود اخراج کرد!

- یامال: اگر یک فوتبالیست بگوید که نمیخواهد توپ طلا را ببرد، دروغ میگوید

- سافونوف، دروازهبان پاری سن ژرمن، درباره یادگیری زبان فرانسه میگوید

- منبع: مورینیو تحت شرایط خاصی آماده مربیگری در روسیه است

- بازندههای بزرگ پنجره نقل و انتقالات

- رئال مادرید: آلوارو کاررس همه را شوکه کرد

- ساموئل اومتیتی تصمیم مهمی برای آیندهاش خواهد گرفت

- تیم اسکو آنژه در پنجره نقل و انتقالات، دوران سختی را پشت سر گذاشته است!

- ایجنت پرتغالی شانس ژوزه مورینیو برای کار در RPL را زیر سوال برد

- باشگاههای لیگ برتر سه برابر بیشتر از هر لیگ دیگری در نقل و انتقالات تابستانی هزینه کردند

- ادرسون درباره جدایی از منچسترسیتی: وقت آن رسیده که این فصل برنده را ببندیم و فصل جدیدی را آغاز کنیم

- رئال مادرید برای سال ۲۰۲۶ سه بازیکن جدید جذب خواهد کرد

- ممو اوچوا پیشنهاد اسپانیا را رد کرد

- خروج ناامیدکننده از رایو وایکانو

- دلیل نپیوستن عمر صدیق به والنسیا

- امیلانو مارتینز، آینده بسته شد

- الکساندر آرنولد، سبایوس، رودری... دنی کارواخال صحبت میکند

- پاسخ یامال درباره اظهارات فلیک که گفته بود خودخواهی مانع از پیروزی بارسلونا در بازی لیگ شده است

- اتین پسر ساموئل اتوئو به صورت قرضی به میراندز پیوست

- گیوکرس: بازیکن هیچ قدرتی ندارد، باشگاه میتواند هر کاری که میخواهد با او انجام دهد

- بایرن مونیخ یک استعداد جوان را قرض داد

- خطر هرج و مرج در بایرن مونیخ