- ارتباط با ما

- |

- درباره ما

- |

- نظرسنجی

- |

- اشتراک خبری

- |

- نگارنامه

مغرور و متعصب مانند انسانها| کشف شباهتهای شگفت انگیز بین الگوهای تفکر انسان و هوش مصنوعی

به گزارش مجله خبری نگار، علیرغم تفاوتهای قابل توجه بین فرآیندهای فکری انسان و هوش مصنوعی، دانشمندان کشف کردهاند که حتی پیچیدهترین مدلهای هوش مصنوعی نیز گاهی اوقات رفتار غیرمنطقی دارند.

بر اساس نتایج مطالعهای که توسط متخصصان دانشگاههای کانادا و استرالیا انجام شده است، چت بات ChatGPT در ۴۷ درصد موارد تلههای روانشناختی معمولی مشخصه انسان را نشان میدهد.

آزمایشهای مدلهای GPT-۳.۵ و GPT-۴ توسعه یافته توسط OpenAI نشان داد که این سیستمها از الگوهای مشابه رفتار انسان مصون نیستند، اگرچه در نتیجه گیری از سازگاری بالایی برخوردار هستند. محققان خاطرنشان میکنند که این سازگاری هم جنبه مثبت و هم جنبه منفی دارد.

مطالعه شبکه عصبی بر روی سوگیریهای شناختی شناخته شده انسان، مانند ریسک گریزی، اعتماد به نفس بیش از حد و تأثیر موفقیت و موفقیت آزمایش شد. این سؤالات هم روانشناسی سنتی و هم به زمینههای تجاری واقعی مربوط میشد.

GPT-۴ نتایج بهتری را در وظایف با راه حلهای ریاضی واضح نشان داد، جایی که خطاهای کمتری در سناریوهای مبتنی بر استدلال و احتمال رخ داد. اما در تقلید از خود، مانند یافتن یک انتخاب خطرناک برای سود، پاسخهای ربات چت اغلب همان عقلانیت غیرمنطقی ذاتی انسان را منعکس میکند.

با این حال، محققان خاطرنشان میکنند که "GPT-۴ تمایل بیشتری به پیش بینی و ایمنی نسبت به انسان نشان داد. "

پروفسور یانگ چن، استادیار گروه مدیریت عملیاتی در دانشکده بازرگانی آیوی در کانادا، توصیه کرد: «برای کمک دقیق و عینی در تصمیم گیری، از هوش مصنوعی در موقعیتهایی که به رایانه اعتماد دارید استفاده کنید. اما زمانی که تصمیمی به دادههای استراتژیک یا ذهنی نیاز دارد، نظارت انسانی ضروری میشود. هوش مصنوعی را نباید کارمندی دانست که تصمیمات سرنوشت ساز میگیرد، بلکه نیاز به نظارت و راهنمایی اخلاقی دارد. در غیر این صورت به جای بهبود آن، خطر خودکارسازی تفکر اشتباه را داریم.»

منبع: Naukatv

- لطفا از نوشتن با حروف لاتین (فینگلیش) خودداری نمایید.

- از ارسال دیدگاه های نا مرتبط با متن خبر، تکرار نظر دیگران، توهین به سایر کاربران و ارسال متن های طولانی خودداری نمایید.

- لطفا نظرات بدون بی احترامی، افترا و توهین به مسئولان، اقلیت ها، قومیت ها و ... باشد و به طور کلی مغایرتی با اصول اخلاقی و قوانین کشور نداشته باشد.

- در غیر این صورت، «نگارمگ » مطلب مورد نظر را رد یا بنا به تشخیص خود با ممیزی منتشر خواهد کرد.

- آخرین اخبار

- محبوب

- برچسب های داغ

- عکس| در مراسم یادبود او، یک بغل کردن بین ستاره الهلال عربستان و همسر ژوتا جنجال به پا کرد

- کادناسر: مسی ممکن است برای ریاست بارسلونا نامزد شود

- سه اثر «شگفتانگیز» غذاهای فوق فرآوریشده بر سلامت مردان

- بایرن مونیخ میتوانست لامینه یامال را با ۵ میلیون یورو به خدمت بگیرد!

- ویدئو| فیلم تکان دهنده از سرقت مسلحانه در روز روشن در ایالات متحده

- آلرژی به آب: یک بیماری نادر که علائم آزاردهندهای ایجاد میکند

- رئال مادرید از صحنه حذف شد... آیا سناریوی توپ طلای سال گذشته تکرار خواهد شد؟

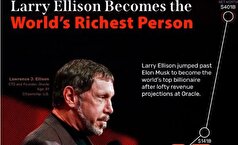

- فوربس: ایلان برای چهارمین سال متوالی در صدر فهرست ثروتمندترین افراد آمریکا قرار گرفت

- خوردن ۲ تخم مرغ در روز با اسکلتهای قویتر مرتبط است

- دروگبا برای اولین بار در چند سال اخیر، مجری مراسم توپ طلا نخواهد بود

- «ایالات متحده» از کجا آمده است؟ و «آمریکا» چگونه پدیدار شد؟

- اسناد جدید، یک معامله مالی بین اپستین و ترامپ را فاش میکند| رسوایی سوءاستفاده دوباره به صدر اخبار آمد

- پزشک دو عادت ساده برای افزایش انرژی را نام میبرد

- اسفناج کلید جوانی و سلامتی است

- یک شهر آمریکایی با سرعت ۷ متر در سال در حال فرو رفتن در آب است

- داروی ریزش مو، بازیکن اسپانیایی را درگیر کرد

- سرآشپز مشهور: «۵ وعده در روز» سبزیجات و میوه جات دروغ است!

- «جراحی موهس» که جو بایدن تحت آن قرار گرفت چیست؟

- سوپرجام عربستان از الاهلی پس گرفته میشود و به النصر میرسد؟ پاسخ فدراسیون فوتبال عربستان سعودی

- ده باشگاهی که بیشترین هزینه را در بازار نقل و انتقالات تابستانی انجام دادند

- توسعه مراکز داده هوش مصنوعی در سوئد استارت میخورد!

- کاهش سطح کلسترول LDL چگونه اتفاق میافتد؟

- مصرف این شش خوراکی را کاهش دهید تا روند پیری را به تعویق بیاندازید!

- نگاهی به فرایند استفاده از هوش مصنوعی در جوامع!

- آلزایمر را به دست رزماری بسپارید!

- عادتهای روزانه والدین بر کودکان تاثیر دارد!

- نکاتی که بعد از عمل ماموپلاستی باید بدانید!

- برای انتخاب رشته به هوش مصنوعی اکتفا نکنید!

- داشتن یک سبک زندگی سالم به این نکات نیاز دارد!

- آمادگی پیش از بارداری را جدی بگیرید!

- پتوهای سنگین میتوانند بیخوابی و اضطراب را درمان کنند؟

- تجربه شنیداری کاربران آمازون موزیک با این هوش مصنوعی شخصیسازی میشود!

- اختلال استرسی پس از حادثه چیست؟ نشانههای آن چیست؟

- سردرد و کاهش استقامت از نشانههای اولیه بیماری چربی قلب!

- به جای مولتی ویتامینها این مواد خوراکی را مصرف کنید!

- کمخوابی بر بینایی افراد هم تاثیر دارد؟

- هر فرد به چه میزان خواب نیاز دارد؟

- قرار گرفتن در معرض نور خورشید برای جذب ویتامین D مفید است یا مضر؟

- قبل از خوردن دانه چیا به این نکات دقت کنید!

- خوردن یک سیب در روز چه فوایدی دارد؟

- راههای حفظ سلامت قلب با توصیههای طب ایرانی!

- کاهش کلسترول تنها با یک مشت گردو!

- مصرف زیاد ویتامینها هم میتواند مضر باشد!

- معجزه با حنا! با موارد کاربرد آن آشنا شوید!

- بیماریهای مزمن باعث افسردگی هم میشوند!

- شرایط استرس زا سیستم ایمنی شما را ضعیف میکند!

- میوهها دشمن وزن شما نیستند!

- چگونه در خانه ضربان قلب را اندازهگیری کنیم؟

- رژیم غذایی مدیترانهای برای چه کسانی مفید است؟

- لبوبوهایی که سلامت روان افراد را از بین بردند!

- درمان و تشخیص هپاتیت در کشور رایگان شد!

- بیماریهای التهابی در نتیجه بالانس نبودن این دو اسید چرب رخ میدهد!

- چگونه از وقوع خودکشی پیشگیری کنیم؟

- کولهپشتی نامناسب عامل کمر درد!

- تقویت قلب و عروق با کمک تمر هندی!

- تغذیه و سبک زندگی سالم پارکینسون را از شما دور میکند!

- ورزش انرژی میدهد یا انرژی میگیرد؟

- ویتامینها در تقویت سیستم ایمنی تاثیر دارند؟

- آرتروز شدید با اولین محصول سلولی مشتق از بافت بندناف درمان میشود!

- یک جنبه منفی برای مصرف زیاد کافئین!

- تغییر مدار یک سیارک توسط فضاپیما، ماموریت جدید چین!

- کشف رازهای باستانی با استفاده از فناوریهای پیشرفته!

- زنگ خطر خاموش این بیماریها به صدا در آمد!

- پیشگیری از دیابت به کمک ماست!

- چربیهای پنهان اطراف اندامهای داخلی بر قلب هم تاثیر دارند!

- پنج روش عملی و اثباتشده برای افزایش سرعت تایپ!

- این غذاها عضلات شما را نابود میکنند!

- مصرف داروهای گروه SSRIها در بارداری مجاز است؟

- ۴۰ سال نوری آنطرفتر سیارهای مشابه زمین کشف شد!

- کلید داشتن مغزی سالم در سنین بالا اینجاست!

- درمان سرطان ریه ممکن شد!

- هورمونتراپی چگونه انجام میشود؟ عوارض ندارد؟

- چرا تشخیص سریع سکته مغزی اهمیت دارد؟

- مصرفگرایی چه تاثیری بر سلامت روان دارد؟

- پروتئین کافی یک راه حل برای کنترل عوارض پیری!

- گیاهان آپارتمانی مناسب فصل پاییز کدامند؟

- رژیم غذایی مدیترانهای مناسب برای افراد مبتلا به دیابت نوع ۲!

- سلولهای سرطانی چه مواد غذایی جذب میکنند؟

- سقف مشخصی برای استفاده رایگان از هوش مصنوعی جمینای مشخص شد!

- رشد یک دندان زنده در آزمایشگاه خبری عجیب!

- تیری آنری در مورد رقیب سابقش گفت: «از کاری که میتوانست بکند میترسیدم، میتوانست تو را دفن کند.»

- هافبک سمپدوریا دختری را که بیش از ۱۰ ضربه چاقو خورده بود، نجات داد

- بازیکن النصر فاش کرد که کریستیانو رونالدو چه کلماتی را به زبان عربی میداند

- «ملکه کتامین» به جرم تهیه دارویی که منجر به مرگ یکی از مشهورترین کمدینهای جهان شد، اعتراف کرد

- عکس| جورجینا پس از اعلام نامزدیاش، با حضور ویژه در کنار کریستیانو رونالدو، فالوورهایش را شگفتزده کرد

- ستاره جیمز باند برای اولین بار درباره طلاقش صحبت کرد

- وودی آلن میگوید سینماهای آنلاین را دوست ندارد

- وودی آلن، جادوگر سینمای آمریکا، داستان اشتیاق خود به هنر هفتم و باله در روسیه را روایت میکند

- جان سینا عکس مسی را منتشر کرد| این کشتیگیر ۱۰ حضور در مسابقات WWE در کارنامهاش دارد

- وین رونی: ماموران امنیتی وقتی به لبران نزدیک شدم، من را با یک هوادار اشتباه گرفتند

- خواننده ژاپنی به خاطر درخواست از مترجم برای بردنش به دستشویی محکوم شد

- بازیگر زن مشهور به دلیل افسردگی مجبور به جن گیری شد

- روما زور راز خوشبختی خانواده را فاش میکند

- سیابیتووا گفت چه نوع زنانی را نباید به همسری گرفت: "سقراط هشدار داد"

- کیتی پری در کنسرت دچار برق گرفتگی شد

- لیل پامپ، رپر آمریکایی، تصادف کرد و به خدا ایمان آورد

- زویی کراویتز به خاطر مار، حمام تیلور سویفت را بهم ریخت

- پسر بکهام در دومین عروسیاش به والدینش توهین کرد

- عکس: زلاتان ابراهیموویچ به حمزات چیمایف به خاطر کسب عنوان قهرمانی در UFC ۳۱۹ تبریک گفت

- «باید دربارهاش از او بپرسی»| نظرات خندهداری که پس از اعلام نامزدی کریستیانو رونالدو و جورجینا رودریگز به آنها داده شد

- اما استون توضیح میدهد که کدام دوره از زندگیاش را خاص میداند

- الکس فرگوسن افسانهای پاسخ داد که اگر مسی در دهه ۱۹۵۰ بازی میکرد، چه اتفاقی برایش میافتاد

- پس از کریستیانو رونالدو، لواندوفسکی حمله به توپ طلا را آغاز کرد

- «او ما را خنداند»| خداحافظی محمد صلاح با ستاره جدید الهلال + عکس

- بازیکن منچسترسیتی: تشویق لیورپول نوعی ریاکاری است

- میکو رانتانن ستاره دالاس با آرسن ونگر عکس میگیرد

- قهرمان فوتبال هلند به جرم قاچاق مواد مخدر به هفت سال زندان محکوم شد

- ممکن است دختر آنا وینتور، بازیگر مشهور، جای او را در مجله ووگ بگیرد

- هنرمند مصری به اتهام قتل شوهرش و فروش اعضای بدن او محاکمه میشود؟

- همسر هافبک اسپارتاک از تلاش برای سرقت در پاریس در نزدیکی برج ایفل خبر داد

- همسر سابق بازیکن اسپارتاک در شبکههای اجتماعی از او انتقاد کرد: «او ما را در خیابان رها کرد»

- عکس| دخیا پیش از بازی فیورنتینا و منچستریونایتد با الکس فرگوسن دیدار کرد

- رونالدوی ۴۰ ساله آمادگی جسمانی فعلی خود را نشان میدهد

- کایلی جنر نشان داد که در کودکی چه شکلی بوده است

- تیم رپر دیدی در مورد عفو این نوازنده با دولت ریاست جمهوری ایالات متحده گفتوگو کرد

- سون هیونگ مین ۵ فوتبالیست مورد علاقهاش را معرفی کرد| ۴ برنده توپ طلا معرفی شدند

- شاهزاده هری درباره دعوایی که در آن «بینی شاهزاده اندرو را شکست» صحبت میکند

- جونگمن، ستاره سریال «من و پادشاه»، به جرم تجاوز و خفگی به زندان افتاد

- "من میتوانم با هزینه او زندگی کنم": عروس جوان لپس بعد از عروسی نقشه میکشد

- بلا حدید و هیلی بیبر قسم میخورند که: حقیقت در مورد مکمل "جادویی" که زیبایی و سلامت را افزایش میدهد چیست؟

- جاستین و هیلی بیبر در بحبوحه شایعات طلاق، میخواهند فرزند دوم داشته باشند

- «او مدام همسرم را فاحشه خطاب میکرد»: ریووا درباره باجگیری از مادرش

- عکس| یورگن کلوپ با ستارههای سابق NBA، دیرک نوویتسکی و استیو نش، پدل بازی کرد

- مشخص شد بردلی کوپر چه زمانی از جیجی حدید خواستگاری خواهد کرد

- کارگردان، وینونا رایدر را گیر انداخت و تهدید کرد که حرفهاش را خراب خواهد کرد

- جنیفر لوپز در تولد ۵۶ سالگیاش عکسی از دوران کودکیاش به همراه کیک منتشر کرد

- رسوایی جنسی جدیدی گریبان مائورو ایکاردی را گرفته است

- شوچنکو، اسطوره تیم ملی اوکراین، با قهرمان مطلق بوکس جهان، اوسیک، دیدار کرد

- حادثه تکان دهنده: مبارز MMA در دعوا با دختر، یک چشم خود را از دست داد

- «با کت و شلوار سفید. ۲۳ سال پیش...» ریو فردیناند در مورد امضای قرارداد با منچستر یونایتد

- هالند عکسی از تعطیلاتش را برای جشن تولدش منتشر کرد: «در نیمه راه ۵۰ سالگی!»

- قهرمان جهان روسیه درباره افسردگی پس از زایمان صحبت میکند

- راموس به واسکز که پس از ۱۰ سال رئال مادرید را ترک کرد، گفت: «به زودی میبینمت»

- انس جابر برای «کشف دوباره شادی زندگی»، بازنشستگی خود را از تنیس اعلام کرد

- La Nacion: الکسیس سانچز با مدل روسی رابطه برقرار کرد

- مسی جزئیات درگیری با رابرت لواندوفسکی در سال ۲۰۲۱ را فاش کرد

- سوفی ترنر رابطهاش را با نامزد سابقش از سر میگیرد

- النا دودینا درباره بارداری در ۳۶ سالگی: «شرمآور بود که هیچکس متوجه نشد»

- جنیفر آنیستون مظنون به داشتن رابطه جدید با یک هیپنوتراپیست است

- کایلی جنر به همراه تیموتی شالامی در تعطیلات در ایتالیا دیده شدند

- حمایت بانکها از بازار سرمایه از فردا اجرا میشود

- بورس سقوط کرده در دولت روحانی چگونه در دولت شهید رئیسی احیا شد؟

- درمان بورسی پزشکیان از زبان عبده

- جذب سرمایه ۷ همتی از بازار بورس دانشبنیانها

- وعده عناب بورسی واقعیتر شد

- چهارمین روز نزولی بازار در غیاب نیروهای صعودی

- انتخابات و دامنه نوسان مهمترین دلیل رکود فعلی بورس

- بورس با ۴ مصوبه دولت برای حمایت از بازار سهام سبزپوش میشود؟

- ۳ دلیل پایین بودن ارزش معاملات خرد در بورس

- معافیتهای مالیاتی بازار سرمایه باید استمرار پیدا کند

- بورس این روزها تحت تأثیر تداوم نرخ اخزای بالای ۳۵ درصد

- رشد شاخصهای بورس با کف سازی تکنیکال

- کاهش دامنه نوسان هم علاج بورس نزولی نبود

- سایه تامین مالی دولت بر سر بورس سنگینی میکند

- کاهش بی سابقه حجم معاملات سهام در بورسهای جهانی

- رشد شاخصهای بورس با کمک بانکیها و اعلام نرخ تسعیر ارز

- حمله به سفیر روسیه در لهستان

- معرفی سری گوشیهای Redmi K ۵۰ قبل از رونمایی رسمی

- غفوری: فکر کردن به قهرمانی از الان، سادهلوحانه است

- کاهش ۱۰ درصدی تولید هوندا در دو کارخانه

- سومین نشست دستمزد، باز هم بدون نتیجه

- لغو بلیت فروشی عمومی المپیک زمستانی چین

- گرامیداشت قربانیان هواپیمای اوکراینی در دانشگاه تورنتو

- ادامه چانهزنی چهارگانه در وین

- صرفهجویی ۱.۶ میلیارد دلاری کمیته برگزاری المپیک و پارالمپیک توکیو

- محبوبترین رشته المپیک توکیو مشخص شد

- اعلام هزینه میزبانی توکیو از المپیک و پارالمپیک ۲۰۲۰،

- آذرتاج: هیات اقتصادی جمهوری آذربایجان به ایران میرود

- بررسی عملکرد ایران در المپیک؛ جایگاه چهارمی در آسیا

- پایان وضعیت اضطراری در کشور میزبان المپیک ۲۰۲۰

- مطالعه: شفقت به خود میتواند بهترین مسکن برای دردهای مزمن باشد

- یک پزشک روسی حقیقت را در مورد تأثیر دوچرخهسواری بر سلامت جنسی مردان توضیح میدهد

- سولاریوم ویتامین D را جبران نمیکند و باعث سرطان پوست میشود

- پس از همهگیری، «ماسکهای کرونا» به یک فاجعه زیستمحیطی تبدیل شدهاند که سلامت انسان را تهدید میکند

- آیا بعد از ترک قهوه، خوابها واضحتر میشوند یا برعکس؟

- محصولی که بدن را برای سرمای زمستان آماده میکند

- غذا دارو است! چگونه رژیم غذایی شما میتواند یک مسکن طبیعی باشد؟

- «دکتر سبز» روی میز شما: نکات مهم برای خوردن گشنیز

- خطرات مصرف بیش از حد پروتئین

- ترک ناگهانی قند: در هفتههای اول چه اتفاقی میافتد و چگونه بر مشکلات غلبه کنیم؟

- دانشمندان مخمر جدیدی کشف کردند که میتواند عفونتهای قارچی تهاجمی را متوقف کند

- سردرد میتواند نشانهی بیماریهای جدی باشد. در مورد علل مختلف آن اطلاعات کسب کنید

- The Conversation: افسانه بلغور جو دوسر باطل شد: باعث افزایش خطرناک قند خون نمیشود

- آیا زانوهایتان صداهای عجیب و غریبی میدهند؟ چه زمانی این یک علامت هشدار دهنده است و چه زمانی طبیعی است؟

- Addiction: سیگار کشیدن با افزایش چربی احشایی شکم مرتبط است

- آفتکشها: تهدیدی برای زندگی کودکان مبتلا به سرطان خون

- کارشناسان در مورد خطرات سلامتی فلزیابها صحبت میکنند

- محققان افسانه فواید مصرف کم الکل برای سلامتی را رد کردند

- میکروپلاستیکها میتوانند در سلولهای سرطانی تجمع یافته و به گسترش آنها کمک کنند

- سلامت عضلات ممکن است به سطح فعالیت بستگی داشته باشد، نه به روند پیری

- روشی موثر برای جلوگیری از ناتوانی جنسی

- MSystems: پروبیوتیکهای موجود در محصولات لبنی تخمیر شده، فشار خون را تثبیت میکنند

- یک نوشیدنی طبیعی که خواب را بهبود میبخشد و ایمنی را تقویت میکند

- جو دوسر تأثیر مفیدی بر سلامت معده و روده دارد

- بهترین حالت خوابیدن برای جلوگیری از آلزایمر و از دست دادن حافظه

- تریگونلین، یک مولکول طبیعی در قهوه، سلامت عضلات را بهبود میبخشد

- چسب جدید الهام گرفته از حلزونها میتواند به چسباندن مجدد مغزها پس از جراحی کمک کند

- یک داروی جدید کاهش وزن موثرتر از اوزمپیک است و عوارض جانبی کمتری دارد

- دانشمندان آمریکایی علت اثر ملین قهوه را شناسایی کردند

- تأثیر غیرمنتظره تنهایی بر سلامت!

- SFA: توتهای سنجد دریایی منبع غنی از آنتیاکسیدانهای طبیعی هستند

- دلیل اصلی خطرناک بودن آنفولانزا برای سالمندان

- PR: تمرینات قدرتی اثر ضد افسردگی متوسطی دارد

- مطالعه: رژیم غذایی گیاهی از سرطان جلوگیری میکند

- ۱۱ پروتئین خون میتوانند زوال عقل را یک دهه زودتر پیشبینی کنند

- یک درمان انقلابی برای دیابت ممکن است نیاز به تزریق انسولین را از بین ببرد

- افزودنیهای غذایی که میتوانند باعث سرطان شوند، شناسایی شدند

- واکسن جدید سرطان روسیه چگونه کار خواهد کرد و چه کسی از آن سود خواهد برد؟

- انجام بازیهای ویدیویی برای مدت طولانی با علائم جسمی منفی مرتبط است

- اخبار داغ

- ورزشی

- پربیننده

- پربحث

- دانشمندان محاسبه کردهاند که ۵۰ درصد از قلمرو یاکوتیا در معرض سیل قرار دارد، نه ۱ درصد، همانطور که قبلاً تصور میشد

- قدیروف: پدرم پایه و اساس روابط قوی بین ما و جهان عرب را بنا نهاد

- فرانسه فاش کرد که چگونه اتحادیه اروپا از حادثه پهپاد در آسمان لهستان سوءاستفاده میکند

- پپتید جدیدی که زخمها را بهبود میبخشد در روسیه ساخته شده است

- پاکستان: سیل ویرانگر هزاران نفر را مجبور به فرار کرد و سدها را تهدید میکند

- افسر ترک: واشنگتن پشت نقش میانجی پنهان شده و به تل آویو اجازه میدهد به رهبری حماس حمله کند

- رئیس دیپلماسی اروپا ادامه درگیری در اوکراین را مجاز دانست

- پزشک علائم غیر واضح مشکلات تیروئید را نام برد

- کییف از کشورهای غربی خواسته است تا موشکها و پهپادهای متجاوز به حریم هوایی اوکراین را سرنگون کنند

- کارشناس آمریکایی: خشونت سیاسی در ایالات متحده به هنجار جدید تبدیل شده است

- ایالات متحده پس از سوء قصد به جان کرک محافظهکار، خط تلفن ویژه راهاندازی کرد

- راهی برای کاهش ۲۵ درصدی خطر ابتلا به زوال عقل در میانسالی کشف شد

- ایالات متحده: قاضی فدرال محدودیتهای دولت ترامپ بر خدماترسانی به مهاجران بدون مدرک را در ۲۰ ایالت متوقف کرد

- جمهوری چک به درخواست کمک لهستان پس از «حادثه پهپاد» پاسخ داد

- مشکلات سلامتی که باعث تغییر رنگ مدفوع میشوند، نامگذاری شدهاند

- بایدن درباره ترور فعال کرک اظهار نظر میکند

- مشاور سابق ترامپ: استارمر و مکرون در حالی که کشورهایشان در شرایط سختی قرار دارند، مانند چهرههای برجسته رفتار میکنند

- کشف میدان نفتی در مجارستان

- دانشمندان ریشه بیماریهای همهگیر آینده را در فقر یافتهاند

- واشنگتن پست: یک کمربند امنیتی بزرگ در اطراف کاخ سفید برقرار شده است

- پس از قتل فعال حقوق بشر کرک، نیروهای آمریکایی اطراف کاخ سفید را محاصره کردند

- وزیر امور خارجه چین از آمریکا خواست در مورد مسائل تایوان محتاط باشد

- دانشمندان «منبع» خوشبینی را در مغز نوزادان یافتند

- ترامپ در واکنش به وضعیت پهپادها در لهستان، یک سوال بیپاسخ مطرح کرد

- لهستان ممکن است برای محافظت از آسمان خود، جنگندههای تایفون دریافت کند

- گازی که به درمان سرطان کمک میکند، نامگذاری شد

- نخست وزیر روسیه: اقتصاد این کشور با وجود چالشها، روند مثبتی را حفظ کرده است

- وزارت امور خارجه روسیه «افسانههای ورشو» در مورد هدف قرار دادن خاک لهستان توسط مسکو را رد میکند

- دانشمندان دریافتند که جذام قبل از ورود اروپاییها در آمریکا ظاهر شده است

- مرتز پس از ورود پهپاد به حریم هوایی لهستان: ناتو آماده دفاع از خود است

- ترامپ قصد دارد درباره «حادثه» پهپاد با رئیس جمهور لهستان گفتوگو کند

- اتحادیه اروپا به درخواست ترامپ برای اعمال تعرفه بر هند و چین واکنش نشان داد

- آکادمیسین چوچالین: هنوز بیماران زیادی با سندرم پس از کووید وجود دارند

- ونس: ترامپ دلیلی برای منزوی کردن اقتصادی روسیه نمیبیند

- پاکستان: ۱.۶ میلیون نفر با خطر سیل مواجه هستند

- گرجستان سفیر آلمان را به عبور از خطوط قرمز متهم کرد

- آکادمیسین چوچالین توضیح داد که چگونه گازهای پزشکی در درمان COPD کمک میکنند

- او پس از سفارش یک فنجان قهوه ناپدید شد! انتقال اوچوا، دروازه بان مکزیکی، به لیگ اسپانیا به طرز عجیبی شکست خورد

- پنتاگون اطمینان داد که خواهان درگیری با چین نیست

- دانشمندان دریافتهاند که چه تعداد شوک الکتریکی به خلاص شدن از افسردگی شدید کمک میکند

- کاردار روسیه در ورشو منبع ورود پهپادها به حریم هوایی لهستان را فاش کرد

- مسی به دستاوردی بیسابقه در دوران حرفهای خود دست یافت

- ارتش لهستان انتقال واحدهای خود به مرز را آغاز کرده است

- پزشک غذاهایی را که برای کلیهها خطرناک هستند نام میبرد

- سهام اپل با وجود عرضه طیف جدیدی از محصولات، سقوط کرد

- مودی نزدیکی به یک توافق تجاری با ایالات متحده را تأیید کرد و چشماندازهای همکاری دوجانبه را ستود

- اروپا از احتمال «جنگ» با روسیه میگوید

- خروپف با صدای بلند با افزایش خطر ابتلا به سرطان ریه مرتبط است

- فایننشال تایمز: غولهای نفتی به دلیل پیشبینی کاهش طولانیمدت قیمت نفت، سرمایهگذاریهای خود را کاهش دادند

- شرکت آرامکوی عربستان سعودی انتشار صکوک بینالمللی را آغاز کرد

- اتحادیه اروپا قصد دارد اصل اجماع در سیاست خارجی را کنار بگذارد

- انبه دو خاصیت درمانی برای قلب دارد

- پس از مصدومیت او در تیم ملی، حضور مرموش در مقابل یونایتد "به حالت تعلیق" درآمده است

- اروپا: ۶.۶ میلیارد یورو برای خرید سلاحهای آمریکایی و ۶ میلیارد یوروی دیگر برای توسعه پهپادها برای کییف

- مجارستان با ادامه درگیریها در اوکراین مخالف است

- دانشمندان منبع شیوع تب خوکی آفریقایی را کشف کردند

- معترضان جاده کمربندی پاریس را مسدود کردند، پلیس با خشونت اعتراضات را سرکوب کرد

- رئیس جمهور لهستان خواستار تشکیل جلسه شورای امنیت در مورد «حادثه پهپاد» شد

- دانشمندان کشف کردهاند که دهها هزار سال پیش، حیوانات غولپیکر در استرالیا زندگی میکردند

- قیمت طلا با افزایش انتظارات برای کاهش نرخ بهره آمریکا روبهرو شد

- نیروهای اوکراینی ساختمان دولتی بلگورود در روسیه را گلوله باران کردند

- کالاس شک داشت که پهپادها «تصادفی» در آسمان لهستان ظاهر شده باشند

- روشی ساده برای تسکین کمردرد بدون دارو معرفی شد

- برزیل تهدید آمریکا به استفاده از زور علیه خود را محکوم کرد

- ترامپ و کوک: دادگاه حکم اخراج را تا زمان تصمیمگیری در مورد پرونده به حالت تعلیق درآورد

- توسک رسماً روسیه را به نقض حریم هوایی لهستان متهم کرد

- دانشمندان میگویند موزهها به مبارزه با بیماریهای همهگیر آینده کمک خواهند کرد

- افزایش فشار بر روسیه: ترامپ از بروکسل خواست تعرفهها بر هند و چین را به ۱۰۰٪ افزایش دهد

- کشورهای غربی مکانهای خطرناکی برای پناهندگان اوکراینی اعلام کردند

- دانشمندان محصول ارزان قیمتی را معرفی کردهاند که از قلب در برابر بیماری محافظت میکند

- جنبش «همه چیز را تعطیل کنید» قصد دارد روز چهارشنبه تظاهرات گستردهای را در فرانسه برگزار کند

- مرتز: حمله اسرائیل به قطر «غیرقابل قبول» است و تهدیدی برای تشدید جنگ محسوب میشود

- برلین بدترین قطعی برق چند سال اخیر را تجربه کرد

- نوه دوگل: پوتین رهبر جهان چندقطبی است و فرانسه باید به بریکس بپیوندد

- توکیو تمام «مراکز ژاپنی» در روسیه را تعطیل میکند

- دانشمندان کشف کردند که هسته مریخ چه بویی دارد

- سفیر روسیه و وزیر امور خارجه ونزوئلا درباره اقدامات آمریکا در حوزه کارائیب گفتوگو کردند

- آلمان وضعیت بحرانی را برای نیروهای مسلح اوکراین اعلام کرد

- دانشمندان دو درمان طبیعی برای طاسی پیدا کردهاند

- گوترش هشدار داد: هزینههای نظامی بیسابقه، سلامت، آموزش و توسعه را تضعیف میکند و صلح جهانی را تضمین نمیکند

- «زمین بازی تصمیم خواهد گرفت.» آنچلوتی در فهرست برزیل برای جام جهانی ۲۰۲۶

- استیو مانداندا، اسطوره فوتبال، بازنشستگی خود را اعلام کرد

- هاکان چالهان اوغلو، خرید ۱۰ میلیون یورویی

- کریستین اریکسن مقصد جدیدی دارد

- مارکا: رئال مادرید آماده نیست پس از توپ طلای ۲۰۲۴ با فرانس فوتبال روابطش را بهبود بخشد

- لیام دلاپ مهاجم چلسی به تمرینات باز میگردد

- الکساندر گریشین: قیمت مناسب برای ماتوی کیسلیاک ۸ تا ۱۰ میلیون یورو ا

- تصمیم مهم رئال مادرید در مورد ادواردو کاماوینگا

- رائول از همین حالا درباره بازگشت به رئال مادرید صحبت میکند

- ترن هوایی که آندره اونانا در آن زندگی میکند

- بارسلونا در ورزشگاه ۶۰۰۰ نفری میزبان والنسیا خواهد بود

- بازیکن تیم ملی روسیه از نظر ارزش انتقال با رونالدو برابری میکند

- واکنش بلینگهام به بازگشت به تمرینات پس از جراحی شانه

- رودریگو مندوزا به دنبال افشاگری است

- چهره دوگانه ایوان رومرو

- متئو رتگی پدال گاز را رها نمیکند

- مارکا: تیبو کورتوا در یک کلوپ شبانه بلژیکی سرمایهگذاری میکند

- مارکا: آرسن زاخاریان به تمرینات عمومی رئال سوسیداد بازگشت

- طبق گزارش CIES، شانس قهرمانی رئال مادرید در لالیگا ۴۰.۶ درصد و شانس قهرمانی بارسلونا ۲۹.۶ درصد است

- امضای قرارداد با کوبی ماینو امکانپذیر است

- واقعیت جدید آلخاندرو گارناچو

- بیثباتی در ذهن آنتونی گوردون

- TEAMtalk: لیورپول میتواند برای جذب بازیکن ملیپوش آلمانی با آرسنال رقابت کند

- دلیل شکست انتقال مایگنان از میلان به چلسی فاش شد

- دیلی میل: اونانا از تصمیم مالک مشترک منچستریونایتد برای حمایت از جداییاش شگفتزده شد

- اندرلخت فروش ۲۰ میلیون یورویی را نهایی کرد

- بازگشت شماره ۹ ایتالیا

- میلان اشکرینیار به علاقه میلان واکنش نشان داد

- یامال: رویای بردن یک توپ طلا را ندارم، رویای بردن چندین توپ طلا را دارم

- ژاوی عکسی با نادال منتشر کرد و او را بزرگترین ورزشکار تاریخ اسپانیا خواند

- لامین یامال از حرکتی شبیه به لبران جیمز استفاده میکند

- آمار دیوانهکنندهای که ارلینگ هالند را دیوانه میکند

- آلمریا فروش ۵ میلیون یورویی خود را نهایی کرد

- تغییر اساسی منچستریونایتد با کاسمیرو

- هالند در هشت بازی متوالی برای تیم ملی نروژ گلزنی کرده است، این مهاجم در ۴۵ بازی ۴۶ گل به ثمر رسانده است

- فلوریان ویرتز: نمیتوانم تصور کنم چه زمانی برای اولین بار برای لیورپول گلزنی خواهم کرد، لیگ برتر بازی متفاوتی اس

- اتلتیکو مادرید در حال حاضر روی یک خرید بدون هزینه کار میکند

- خورخه والدانو اختلاف نظرش با مورینیو را فاش کرد

- افقی جدید برای آدمولا لوکمن

- اسکای اسپورتس: مالک ناتینگهام از اظهارات سرمربی سابقش عصبانی است

- CIES: لیورپول مدعی اصلی قهرمانی در لیگ برتر، آرسنال دوم و چلسی سوم است

- باشگاه منچسترسیتی در بیانیهای رسمی جزئیات مصدومیت عمر مرموش در بازی مقابل بورکینافاسو را فاش کرد

- ESPN: یوسایک قصد دارد در یک بازی خیریه در پرتغال با ستارههای فوتبال بازی کند

- اطلاعیه مهم یرای آلوارز برای باشگاه ورزشی

- اولین گام در جذب ابراهیما کوناته

- وستهام با یک آشنای قدیمی قرارداد امضا کرد

- فابیو کاپلو: مسی و رونالدو در سطوح متفاوتی هستند

- روزنامه اکیپ اطلاعات محرمانهای درباره برنامههای زینالدین زیدان و محل کار آیندهاش منتشر کرد

- طبق گزارش Sofascore، زینچنکو و زابارنی جزو بدترین بازیکنان بازی مقابل آذربایجان بودند

- لیگ برتر هنوز از انزو بویومو ناامید نشده است

- فرصتی جالب برای کریستین اریکسن

- سه نفر در لیگ برتر سنی مایولو را تحسین میکنند

- ارلینگ هالند رکورد فوتبال جهان در قرن بیست و یکم را شکست

- «این شکایات فراموش نشدهاند.» الکساندر موستووی درباره بدهی حقوق سلتا

- الکساندر موستووی توضیح داد که چرا به لیورپول و بارسلونا نقل مکان نکرد

- یک جایگزین برای پست دروازهبانی اینتر میلان دوباره فعال شده است

- «مسی به اتلتیکو؟ نمیدانم چطور توانستی چنین فکری بکنی.»

- ماتوی سافونوف به شایعات جدایی احتمالیاش از پاری سن ژرمن واکنش نشان داد

- ما علیه داوران بازی کردیم.» برزیل پس از شکست مقابل بولیوی ابراز نارضایتی کرد

- برزیل پس از شکست مقابل بولیوی، به کونمبول شکایت خواهد کرد

- رقابت برای آدام وارتون داغتر میشود

- آنتونی، یک خرید سودآور

- بندی که آینده نیکو گونزالس را تعیین خواهد کرد

- باشگاه روسی پیشنهاد خرید میلیک مهاجم لهستانی یوونتوس را داده است

- لوئیس د لا فوئنته در مورد جدایی احتمالی از تیم ملی اسپانیا صحبت میکند

- وضعیت "غیرعادی" دیگو سیمئونه

- وظیفه پیچیدهای که بایرن به وینسنت کمپانی سپرده است

- تمجید درخشان استوائو ویلیان از کارلو آنچلوتی

- «او عاشقش بود» مادر کیلیان امباپه درباره علاقه دوران کودکی پسرش به کریستیانو رونالدو میگوید

- توماس توخل به دستاوردی تاریخی برای مربیان انگلیس دست یافت

- کیلیان امباپه میگوید امسال توپ طلا را نخواهد برد

- وقتی زمانش برسد، به رئال مادرید برمیگردم

- اعترافات صمیمانه کیلیان امباپه

- بنفیکا پیشنهاد بزرگ برای ونجلیس پاولیدیس را رد کرد

- نانی، ستاره منچستریونایتد و تیم ملی پرتغال، برای اولین بار در لیگ رسانهای برای تیم آلفا-بانک بازی خواهد کرد

- باشگاه فنرباغچه در مورد انتصاب دومنیکو تدسکو به عنوان سرمربی صحبت کرد

- زسکا خواهان جذب استاسین، مهاجم سنت اتین، بود

- اشاره جوئل روبلز به یک باشگاه لالیگا

- هافبکی که منچستریونایتد آرزویش را دارد

- توصیه قاطع خسه رودریگز به کیلیان امباپه