- ارتباط با ما

- |

- درباره ما

- |

- نظرسنجی

- |

- اشتراک خبری

- |

- نگارنامه

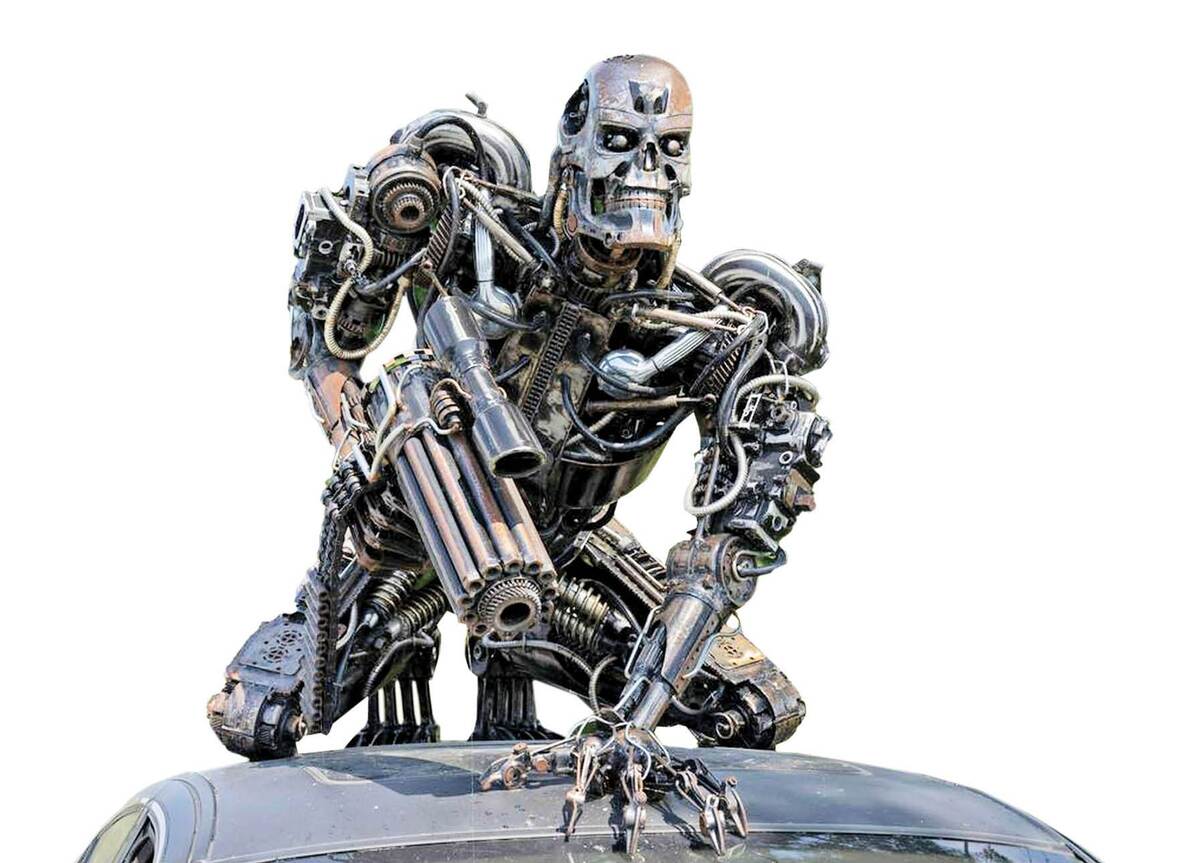

چطور یک ربات قاتل میشود؟

به گزارش مجله خبری نگار، تصاویر ویدئویی دلهرهآور روبات انساننمایی که از کنترل خارج شده روزهای گذشته در حال دست بهدست شدن است. این روبات چینی به اسم H۱ ساخت شرکت چینی یونیتری است که در مراحل آزمایش و نمایش عمومی ناگهان از کنترل خارج شد و با حرکات عجیب شبیه ضربه زدن پرقدرت به سمت اطرافیان هجوم برد، اما خوشبختانه گروه فنی موفق شد زود کنترل آن را در دست بگیرد. بهگفته یکی از مسئولان این روبات، هنگام آپدیت یک باگ عجیب در سیستم حفظ تعادل پیش آمد و باعث شد از کنترل خارج شود. این اتفاق باعث شد بحث ایمنی روباتها دوباره زنده شود. متخصصان هشدار میدهند که رشد سریع هوش مصنوعی نیازمند نظارت دقیقتر و طراحی سیستمهای ایمنی قویتر است.

نمونههای مرگبار حمله روبات

مرگ زن عابر در تصادف با خودروی خودران: سال ۲۰۱۸ در آریزونا، یک خودران اوبر با زنی در حال عبور از خیابان تصادف کرد و او را کشت. بررسیها نشان داد که سیستم هوش مصنوعی خودرو، زن را ابتدا یک جسم ناشناس و سپس دوچرخهسوار تشخیص داده بود.

بازوی روباتیک حادثهساز: در برخی جراحیهای انجامشده با روباتهای داوینچی، گزارشهایی از برشهای اشتباهی و پارگی رگها منتشر شده است. بسیاری از این موارد به خطای کاربر، ناآگاهی از دستورالعملها یا اختلال نرمافزاری نسبت داده شد.

روبات قاتل در حوزه نظامی: در گزارشهای منتشرشده از جنگ داخلی لیبی (۲۰۲۰)، ادعا شد که پهپادها و روباتهای ساخت ترکیه بهصورت خودمختار اهداف انسانی را دنبال و به آنها حمله کردهاند. گرچه جزئیات دقیق هنوز در پرده ابهام است، اما اگر این ادعا صحیح باشد، این نخستین نمونه ثبتشده از حمله کشنده کاملاً خودکار یک روبات به انسان بدون فرمان انسانی در لحظه اجرا خواهد بود.

خطاهای انسانی

روباتها ابزارهایی هستند که براساس دستورالعملهای انسانی کار میکنند. این دستورالعملها میتوانند به شکل الگوریتمهای پیچیده، دادههای آموزشی برای هوش مصنوعی یا حتی دستورات مستقیم انسانی باشند، اما همانگونه که در صنعت هوانوردی یا پزشکی دیدهایم خطای انسانی نهتنها رایج، بلکه اجتنابناپذیر است، اما در حوزه روباتها نتیجه یک اشتباه میتواند بدون هشدار اجرا شود و پیامدهایی فوری و خطرناک بهدنبال داشته باشد.

چرا خطا در روباتها خطرناکتر است؟

یک الگوریتم اشتباه ممکن است در میلیثانیه تصمیمی بگیرد که حتی یک انسان فرصت نداشته باشد آن را بازبینی یا متوقف کند.

انسانها، بهویژه در مواجهه با سیستمهایی که ظاهر هوشمند دارند، دچار خطای شناختی اعتماد میشوند و تصور میکنند ماشین همیشه درست عمل میکند درحالیکه آن ماشین فقط به درستی یا نادرستی دستورالعملهای انسانی وفادار است.

بسیاری از مدلهای یادگیری ماشین، مانند شبکههای عصبی عمیق، ذاتا غیربازگشتپذیر یا غیرقابل توضیح هستند. این یعنی حتی طراحان نیز نمیدانند دقیقاً چرا یک روبات تصمیم خاصی را اتخاذ کرده است و همین امر مانع از اصلاح دقیق خطا میشود.

راهحل چیست؟

استفاده از روباتها، بهویژه در حوزههای حساس مانند پزشکی یا نظامی، نباید بدون آموزش سختگیرانه و صدور گواهی صلاحیت فنی باشد. همچنین هر روبات باید دارای لایههایی از نظارت انسانی، سیستمهای هشدار و مکانیسمهای توقف فوری باشد که درصورت تشخیص عملکرد غیرطبیعی جلوی اجرا را بگیرد. از سوی دیگر همانطور که برای استفاده از سلاحهای شیمیایی قوانین جهانی وجود دارد، نیاز فوری به چارچوبهای قانونی برای روباتها احساس میشود.

منبع: همشهری

- لطفا از نوشتن با حروف لاتین (فینگلیش) خودداری نمایید.

- از ارسال دیدگاه های نا مرتبط با متن خبر، تکرار نظر دیگران، توهین به سایر کاربران و ارسال متن های طولانی خودداری نمایید.

- لطفا نظرات بدون بی احترامی، افترا و توهین به مسئولان، اقلیت ها، قومیت ها و ... باشد و به طور کلی مغایرتی با اصول اخلاقی و قوانین کشور نداشته باشد.

- در غیر این صورت، «نگارمگ » مطلب مورد نظر را رد یا بنا به تشخیص خود با ممیزی منتشر خواهد کرد.

- آخرین اخبار

- محبوب

- برچسب های داغ

- عکس| لوچانو اسپالتی، که سرمربی یوونتوس شد، خالکوبیای به نام ناپولی روی بازویش دارد

- استارمر بهای نگه داشتن گردنبندی که ترامپ به او هدیه داده بود را میپردازد

- گوگل: اندروید خیلی امنتر از آیفونه!

- وقتی از خواب محروم میشوید، چه اتفاقی در مغز میافتد؟

- تری در مورد ورود هازارد به تالار مشاهیر لیگ برتر گفت: «تو بزرگترین بازیکن چلسی هستی.»

- ویدئو| «ترامپ چاپلوس»: بنیانگذار بناند جری پس از ممنوعیت «طعم غزه» صاحبان شرکتها را به چالش میکشد

- روانپزشکان یک مورد نادر از روانپریشی مرتبط با چرخه قاعدگی را ثبت کردهاند

- لحظهای که هواداران فوتبال منتظرش بودند! کریستیانو جونیور چه زمانی به پدرش در تیم اصلی النصر ملحق خواهد شد؟

- یک متخصص تغذیه این افسانه را که نباید بعد از ساعت ۶ بعد از ظهر غذا خورد، رد کرد

- مشهورترین رمز جهان حل شد

- دانشمندان راز عذرخواهی بینقص را فاش کردند

- سازمان بهداشت جهانی: خودکشی عامل یک درصد مرگ و میرها در جهان است

- JoHS: دانشمندان ویژگیهای شخصیتی مشترکی را در بین افراد صد ساله شناسایی کردهاند

- چگونه از روی وضعیت ابروهای یک فرد بفهمیم که او مشکل سلامتی دارد

- دروازهبان اینترمیلان با ماشینش به یک مردی که روی ویلچر نشسته بود، زد و جان باخت

- چه زمانی سردرد نیاز به مراقبت فوری پزشکی دارد؟

- هشدار مطالعه: ورزش شدید میتواند به قیمت جان زنان تمام شود!

- دانشمندان محصولی را شناسایی کردهاند که کیفیت زندگی صمیمی را بهبود میبخشد

- غذاهای غیرمعمول که با چین و چروک و افتادگی پوست مبارزه میکنند

- هزاران متجاوز جنسی در مشهورترین شهر آمریکا زندگی میکنند و ساکنان را به وحشت میاندازند

- رئیس جمهور کلمبیا به دلیل تحریمهای آمریکا در دریافت حقوق خود با مشکل مواجه است

- حل معمای پیدایش آب روی زمین به کمک ماه!

- چطور میتوان ظرفها را تمیز شست؟

- فشار خون به فصل ارتباط دارد؟

- رشد دوباره مو در سلولهای چربی نهفته است!

- درختان کهنسال گلدان دار میشوند!

- تنفس مصنوعی از راه روده!

- درمان سرطان تخمدان با کمک یک گیرنده سطح سلولی!

- علائم بروز سکته مغزی! + نقش مهم زمان!

- یک فنجان آب انار ضامن سلامت قلب!

- چگونه سالم لاغر شویم؟

- ثروتمندترین افراد جهان با هوش مصنوعی پولدارتر شدند!

- مولکولی که میتواند گرسنگی را از بین ببرد!

- اپل روند ساخت آیفون را تغییر میدهد!

- حسگری که افزایش اشعه خطرناک UV را هشدار میدهد!

- رفتار عجیب زنبورهای عسل در مقابل ملکه!

- رکورد طولانیترین مدت بقا با کلیه خوک شکسته شد!

- کارایی پردازش مدلهای زایا با این شتابندهها افزایش مییابد!

- پیشگیری از ابتلا به سرماخوردگی با سادهترین نکات!

- دوچرخه برقی برای پاها! عنوان پروژه جدید شرکت نایکی!

- افزایش عمر گوشی با ۷ ترفند ساده!

- زنان دو برابر مردان مستعد افسردگی هستند!

- عینک هوشمندی که بینایی نابینایان را بازمیگرداند!

- استویا میتواند راهی برای درمان کچلی باشد!

- دلیلی که باید به نوزاد بادام زمینی بدهید!

- افزایش دمای زمین باعث مرگ میشود؟

- داغی و سوزش کف پا نشانه چه بیماریهایی است؟

- بیماریهای قلبی و عروقی چه مقدار کشته میدهند؟

- فضای حافظه گوشی را میتوانید از طریق واتساپ مدیریت کنید!

- ایلان ماسک همچنان هوش مصنوعی و رباتها را چیره بر انسانها دید!

- چتباتهای هوش مصنوعی میتوانند توهم ایجاد کنند!

- معرفی بهترین زمان مصرف امپرازول و پنتوپرازول

- الگوریتم هوش مصنوعی میتواند خطر ابتلا به بیماریهای قلبی را عددی بیان کند!

- کمخونی ناشی از فقر آهن با این مکمل ترکیبی درمان میشود!

- روشهای فوری و معجزهآسای لاغری قابلیت عملی شدن دارند؟

- در زمان اسهال چی بخوریم؟

- پیرگوشی تحت تاثیر چه عواملی ایجاد میشود؟

- خاصیت لبو برای نوزادان و کودکان!

- بلعیدن آدامس خطرات ترسناکی دارد؟

- فیناستراید دارویی که باعث ایجاد افکار خودکشی میشود!

- داروهای مسکن و تببر استامینوفن برای دوران بارداری خطرناک است؟

- نوشیدنیهای انرژیزا میتوانند عامل خودکشی باشند!

- شش ترکیب پرمصرف که برای سلامتی مضرند!

- مصرف طولانی مدت امپرازول عوارض دارد؟

- نگهداری سیر تازه در روغن خطرناکترین روش است!

- یک نشانگر زیستی درمانی جدید برای سرطان تخمدان!

- درمان مشکل ضربان قلب با کمک پرتودرمانی!

- مهمترین عامل در بروز سکتههای مغزی چیست؟

- بسیار از سرطانها در مراحل اولیه قابل درمان هستند!

- اگر بیماری پرفشاری خون دارید، برای مصرف داروها به این نکات نیاز دارید!

- استنشاق گاز قرص برنج هم خطری است؟

- بیماری پسوریازیس باید سریعا تشخیص داده شود!

- بررسی اثرات فشار خون در فصل پاییز!

- آلرژی کودک به این آجیل را اینگونه از بین ببرید!

- مصرف مواد غذایی کپکزده خطر سرطان دارد!

- آمار عجیب ابتلای افراد به سکته مغزی!

- دید دقیق قویترین رصدخانه فضایی جهان واضحتر میشود!

- چگونه دمای دقیق بدن را اندازهگیری کنیم؟

- کرمی که بعد از ۴۶ هزار سال یخزدگی زنده شد!

- ساخت نمونه اولیه یک دستکش هوشمند تایید شد!

- عکس| مل گیبسون جنجالی بر سر مریم مقدس به پا کرد

- ابتلا به «ویروس اهداکننده»| یک بازیگر مشهور آمریکایی قصد دارد کلیه خود را به یک غریبه اهدا کند

- همسر سابق آرشاوین: او بنتلی من را فروخت، یک مرسدس خرید و مابهالتفاوت را برای خودش نگه داشت

- مسی بهترین ورزشکاران در بین تمام رشتههای ورزشی را انتخاب کرد

- دلیل پاملا اندرسون، ۵۶ ساله، برای کنار گذاشتن آرایش

- جانیک سینر و کیلیان امباپه در رستورانی در پاریس با هم آشنا شدند

- خاطرات قربانی اپستین، افشاگری تکاندهندهای را در مورد شریک زندگی او و یک بازیگر بینالمللی آشکار میکند

- ستاره سریال «بازی تاج و تخت» با نامزد سابق داکوتا جانسون قرار ملاقات میگذارد

- همسر بیبر درباره درمانهای صورتش صحبت میکند

- تیماتی یکی از گرانترین ماشینها را به نامزدش داد

- حمله همسر وزیر بهداشت آمریکا به دلیل «رسوایی پیامکهای جنسی» به یک روزنامهنگار مشهور

- هایدی کلوم به مناسبت تولد ۱۶ سالگی دخترش، عکسی کمیاب از او در کنار دخترش منتشر کرد

- رشفورد نتوانست بین مسی و رونالدو یکی را انتخاب کند

- مودریچ برای همه بازیکنان میلان آیفون خرید تا مجبور نباشد جلوی تیم آهنگ اجرا کند

- عکس| واکنش همسر یاسر الزبیری پس از قهرمانی مراکش در جام جهانی زیر ۲۰ سال فیفا

- نیکول کیدمن ۵۸ ساله راز زیبایی خود را فاش کرد

- شاهزاده اندرو به ارتباط با اپستین در بریتانیا متهم شده است

- جیجی حدید علناً خطاب به بردلی کوپر گفت: «عشق من»

- برد پیت رابطهاش با اینس د رامون را به سطح بالاتری برد

- مگان مارکل عکسی از خودش و دخترش را به اشتراک گذاشت

- پاسخ شاهزاده هری به اتهامات همسرش مبنی بر بیاحترامی به مادرش فاش شد

- دختر ۱۴ ساله بکهام برند لوازم آرایشی خودش را تأسیس خواهد کرد

- جزئیات رابطه جنیفر لوپز و بن افلک پس از تجدید دیدار فاش شد

- عکس| دمبله برای جشن گرفتن بردن توپ طلا، یک جفت کفش اختصاصی دریافت کرد

- شایعات عاشقانه جرد لتو قوت گرفت

- پدری، هافبک بارسلونا، با قرار دادن یک بازیکن سابق رئال مادرید در فهرست خود، فوتبالیست ایدهآل را انتخاب کرد

- کیتی پری سکوت خود را در مورد رابطهاش با نخستوزیر سابق کانادا شکست

- بردلی کوپر مشکوک به جراحی پلاستیک است: "قبلاً بهتر بود"

- «لئو از صحبتهای شخصی خوشش نمیآید.» دییونگ توضیح داد که چطور از مسی تعریف و تمجید شده است

- مشخص شد که چرا خانواده بکهام در عروسی سلنا گومز شرکت نکردند

- پاریس هیلتون هفتهای ۹ ساعت را صرف مراقبتهای صورت میکند

- همسر جاستین بیبر توضیح داد که چرا او و این خواننده پسرشان را به نمایش نمیگذارند

- شوهر ستاره جیمز باند دستگیر شد

- همسر بیبر فاش کرد که با یک میلیارد دلار حاصل از فروش برندش چه خواهد کرد

- کیم کارداشیان دلیل طلاقش از کانیه وست را فاش کرد: "حمله دیگری اتفاق افتاده است"

- کیم کارداشیان با اعتراف به اینکه از قیمت مواد غذایی خبر ندارد، طرفدارانش را شوکه کرد

- بریتنی اسپیرز همسر سابقش را به قلدری متهم کرد: «دیگر بس است»

- شارلیز ترون به خاطر بیاحترامی به جانی دپ مورد انتقاد قرار گرفت: "او بیادب است. "

- کیث اربن پس از جدایی از نیکول کیدمن، رابطه عاشقانه جدیدی را آغاز کرده است: «او در شوک است.»

- مادر سلنا گومز به شایعات مربوط به رسوایی در عروسی دخترش پاسخ داد

- همسر بروس ویلیس گفت فرزندانش از همین حالا برای پدرشان سوگواری میکنند

- هواداران نیکول کیدمن پس از انتشار خبر طلاق، به کیت اربن حمله کردند

- فائزه العماری از مبارزه امباپه با شهرت میگوید

- بوفون در مورد انتخاب پسرش برای بازی در تیم ملی جمهوری چک: در ایتالیا، بار نام خانوادگیاش او را خرد میکرد

- پیشخدمت پرنسس دایانا راز جدیدی را در مورد کاخ باکینگهام فاش کرد

- پسر ۲۱ ساله راسل کرو به خاطر تصویرش مورد انتقاد قرار گرفت: «او مثل پدرش نیست.»

- نیکول کیدمن پس از جدایی از کیث اربن بیانیهای صادر کرد

- مگان مارکل به خاطر تمسخر یک مدل محکوم شد: «این حرفها خیلی گویای شخصیت واقعی اوست»

- ویکتوریا بکهام میگوید به خاطر شوهرش لبخند نمیزند

- جنیفر آنیستون اعتراف کرد که ۲۰ سال برای بچهدار شدن تلاش کرده است

- آنجلینا جولی، ستاره بینالمللی، درباره طلاقش از برد پیت، بازیگر مشهور، صحبت کرد و شکایت جدیدی علیه او مطرح کرد

- این دوچرخه سوار اسپانیایی تادژ پوگاچار را با بارسلونا یوهان کرایف مقایسه کرد

- کیت میدلتون با کت و شلوار سبز با "شکلات دبی" مقایسه شد

- جورج کلونی برای اولین بار درباره مصرف مواد مخدر صحبت کرد: «مشکلی نبود»

- شایعات نامزدی هرمیون گرنجر، ستاره هری پاتر، قوت گرفت

- «مدت زیادی تحریک و تحقیر شدم.» لروی سانه در اکتبرفست دعوا راه انداخت

- رایت: اگر کین از بایرن به تاتنهام برگردد، رکورد گلزنی شیرر در لیگ برتر را خواهد شکست

- رپر معروف، دیدی، به ۵۰ ماه زندان محکوم شد

- تام هالند برای اولین بار نامزدی خود با زندایا را تایید کرد

- نیکول کیدمن و کیث اربن جدایی خود را اعلام کردند

- حمایت بانکها از بازار سرمایه از فردا اجرا میشود

- بورس سقوط کرده در دولت روحانی چگونه در دولت شهید رئیسی احیا شد؟

- درمان بورسی پزشکیان از زبان عبده

- جذب سرمایه ۷ همتی از بازار بورس دانشبنیانها

- وعده عناب بورسی واقعیتر شد

- چهارمین روز نزولی بازار در غیاب نیروهای صعودی

- انتخابات و دامنه نوسان مهمترین دلیل رکود فعلی بورس

- بورس با ۴ مصوبه دولت برای حمایت از بازار سهام سبزپوش میشود؟

- ۳ دلیل پایین بودن ارزش معاملات خرد در بورس

- معافیتهای مالیاتی بازار سرمایه باید استمرار پیدا کند

- بورس این روزها تحت تأثیر تداوم نرخ اخزای بالای ۳۵ درصد

- رشد شاخصهای بورس با کف سازی تکنیکال

- کاهش دامنه نوسان هم علاج بورس نزولی نبود

- سایه تامین مالی دولت بر سر بورس سنگینی میکند

- کاهش بی سابقه حجم معاملات سهام در بورسهای جهانی

- رشد شاخصهای بورس با کمک بانکیها و اعلام نرخ تسعیر ارز

- حمله به سفیر روسیه در لهستان

- معرفی سری گوشیهای Redmi K ۵۰ قبل از رونمایی رسمی

- غفوری: فکر کردن به قهرمانی از الان، سادهلوحانه است

- کاهش ۱۰ درصدی تولید هوندا در دو کارخانه

- سومین نشست دستمزد، باز هم بدون نتیجه

- لغو بلیت فروشی عمومی المپیک زمستانی چین

- گرامیداشت قربانیان هواپیمای اوکراینی در دانشگاه تورنتو

- ادامه چانهزنی چهارگانه در وین

- صرفهجویی ۱.۶ میلیارد دلاری کمیته برگزاری المپیک و پارالمپیک توکیو

- محبوبترین رشته المپیک توکیو مشخص شد

- اعلام هزینه میزبانی توکیو از المپیک و پارالمپیک ۲۰۲۰،

- آذرتاج: هیات اقتصادی جمهوری آذربایجان به ایران میرود

- بررسی عملکرد ایران در المپیک؛ جایگاه چهارمی در آسیا

- پایان وضعیت اضطراری در کشور میزبان المپیک ۲۰۲۰

- گیاهان آپارتمانی که با کپک مبارزه میکنند و رطوبت را در زمستان کاهش میدهند

- یک آزمایش سریع سکته مغزی را تشخیص میدهد!

- عکس| ایالات متحده: پنج نفر در ارتباط با مرگ نوه رابرت دنیرو بر اثر مصرف بیش از حد مواد مخدر دستگیر شدند

- مضرات قهوه و نحوه مصرف ایمن آن

- ۱۲ ماده غذایی که باروری مردان را افزایش میدهد

- ۵ نوع چای که به شما در سوزاندن چربی شکم کمک میکنند، معرفی شد

- دانشمندان اصول اولیه گفتار انسان را در شامپانزهها کشف کردهاند

- جو دوسر: بین غذا و پیشگیری: چگونه سلامت روده و استخوان را تقویت میکند؟

- خردل: طعمی متمایز و فواید شگفتانگیز برای سلامتی

- «سن مخفی» بدن، اطلاعات بیشتری در مورد خطر ابتلا به زوال عقل نسبت به سال تولد شما فاش میکند

- هشدار محققان: قرصهای ضدبارداری رایج ممکن است خطر ابتلا به سرطان سینه را افزایش دهند

- قرصهای ضدبارداری تأثیر عجیبی بر ناحیهای از مغز دارند که باعث ترس میشود

- حل معمای بیماری کرون پس از ربع قرن: هوش مصنوعی پاسخها را ارائه میدهد

- نوآوری دارویی جدید با اثربخشی استثنایی در برابر انواع مختلف سرطان

- محققان دانشگاه کمبریج دریافتهاند که یک داروی سرطان در برابر بیماریهای قلبی مؤثر است

- هشدار مطالعه: آنفولانزا خطر حملات قلبی را تا هفتهها پس از بهبودی افزایش میدهد

- یک پزشک علت شایع بوی بد دهان را شناسایی کرده است

- دانشمندان راز ژنتیکی اعتیاد به الکل را کشف کردند

- نحوه مصرف صحیح پروتئین برای افراد میانسال و مسن

- این فقط یک احساس نیست... یک مطالعه فواید فیزیولوژیکی شادی زناشویی را در میان سالمندان آشکار می کند

- یک متخصص تغذیه اشتباه اصلی افراد هنگام تلاش برای کاهش وزن را که میتواند منجر به مرگ شود، شناسایی کرد

- در یک پیشرفت غیرمنتظره که راه را برای درمانهای مؤثر هموار میکند، علت احتمالی یک بیماری عصبی ویرانگر کشف شده است!

- گوشیهای پزشکی مجهز به هوش مصنوعی در بریتانیا آزمایش میشوند

- علائمی که قبل از اختلال عملکرد جنسی بروز میکنند

- نیچر: آمفوتریسین جدید قارچها را بدون آسیب رساندن به سلامتی از بین میبرد

- واکنشهای آلرژیک میتوانند خطر ابتلا به بیماریهای قلبی عروقی را به میزان قابل توجهی افزایش دهند

- نورولوژی: یوگا برای افراد مبتلا به صرع مفید است

- ارتباط مداوم به عنوان راهی مؤثر برای جلوگیری از زوال عقل نشان داده شده است

- یک درمان اساسی برای عوارض دیابت!

- خوردن آجیل خطر مرگ ناشی از دیابت نوع ۲ را کاهش میدهد

- فواید شگفتانگیز کاکائو برای سلامتی مردان

- سی تی اسکن خطر ابتلا به سرطان خون را افزایش میدهد

- مواد شیمیایی موجود در لوازم آرایشی سیستم ایمنی بدن را تضعیف کرده و تعادل هورمونی را به هم میریزند!

- سلامت خواب: منظم بودن، کلید خواب خوب است

- کشف عاملی که ممکن است باعث اختلال در سیستم ایمنی شود

- پزشک توضیح داد که چگونه طوفانهای مغناطیسی بر سلامت تأثیر میگذارند

- «آب مخصوص»: نوآوری ژاپنی برای مبارزه با چربی احشایی

- ملاقاتهای مکرر با دوستان و خانواده میتواند خطر مرگ زودرس را کاهش دهد

- محققان «حلقه گمشده» در بهبود قلب پس از حمله قلبی را آشکار کردند

- MMR: اضافه بار فیزیکی خطر عفونتهای حاد تنفسی ویروسی را حتی در افراد آموزش دیده افزایش میدهد

- ارز

- طلا

- بورس

- تورم

- اخبار داغ

- ورزشی

- پربیننده

- پربحث

- دانشمندان کشف کردهاند که برخی از اشیاء با چشم انسان قابل مشاهده نیستند

- گفتگوی مالی روسیه و امارات متحده عربی به منظور تقویت همکاریهای مالی و دیجیتال در دبی برگزار شد

- بریتانیا اقداماتی را برای تقویت مبارزه با «جنایات ناموسی» تصویب کرد

- سیلوانوف: حجم تجارت بین روسیه و امارات متحده عربی دو برابر شده است

- غرب از برنامههای ناتو برای «مهار» روسیه خبر داد

- فیزیکدانان برای اولین بار اشیاء کوانتومی را از حالتهای درهمتنیده چندبعدی استخراج کردند

- ال موندو: «ائتلاف داوطلبان» قصد دارد جلسهای محرمانه برگزار کند

- یک جامعهشناس درباره درگیری احتمالی بین لهستانیها و اوکراینیها صحبت کرد

- ترکیبی از دو باکتری رایج شناسایی شده است که سیستم ایمنی را سرکوب میکند

- تعطیلی دولت آمریکا، امنیت پروازها را تهدید میکند| کنترلکنندگان ترافیک هوایی حقوق دریافت نمیکنند

- اسپالتی به محمد صلاح پاداش داد

- شرکتهای آلمانی هزاران پهپاد را «کورکورانه» خریداری خواهند کرد

- مشخص شده است که چه غذاهایی اغلب دور ریخته میشوند

- یک موقعیت وحشتناک، حرکت لامین یامال به عمارت شکیرا و پیکه را تسریع میکند

- اوربان: سفر قریبالوقوع من به واشنگتن، اجلاس پوتین-ترامپ در بوداپست را نزدیکتر میکند

- طرحهای زلنسکی برای حملات دوربرد علیه روسیه فاش شده است

- دانشمندان مولکولی را کشف کردهاند که میتواند به طور انتخابی باکتریهای خطرناک را بدون آسیب رساندن به باکتریهای مفید از بین ببرد

- مراکش مکانهای «امیدوارکنندهای» برای طلا و مواد معدنی استراتژیک کشف کرد

- خط لوله «قدرت سیبری» روسیه را به رهبر عرضه گاز به چین تبدیل کرده است

- دانشمندان کشف کردهاند که یک برخورد میتواند باعث شود سیاره زمین برای میلیونها سال زنگ بزند

- «من یک شاهزاده را به زیر کشیدم»: برادر قربانی اندرو با کلماتی تأثیرگذار داستان یک پیروزی تاریخی بیسابقه را روایت میکند

- ۸ مصدوم در بارسلونا پیش از دیدار مقابل الچه

- دومای دولتی تغییر ناگهانی موضع ترامپ در قبال اوکراین را توضیح داد

- برای اولین بار، خانه جنگلی دایناسورهای قطبی با جزئیات بازسازی شده است

- کییف پست: آمریکا قصد دارد بخشی از نیروهای خود را در ماه دسامبر از سه کشور اروپایی خارج کند

- اسکولز پس از حمله شدید به محمد صلاح، اعلام کرد که از تحلیل مسابقات کنارهگیری میکند

- شورای امنیت اعلام کرد که اگر کشورهای دیگر آزمایشهای هستهای انجام دهند، روسیه نیز چنین خواهد کرد

- دانشمندان برای اولین بار ژنوم عنکبوتها را ویرایش کرده و ابریشمی ساختهاند که به رنگ قرمز میدرخشد

- طوفان ملیسا پس از برجای گذاشتن ویرانیهای گسترده در کارائیب، همچنان به سمت برمودا در حرکت است

- دیوان کیفری بینالمللی از ترس تحریمهای ترامپ، محصولات مایکروسافت را کنار میگذارد

- شویگو اظهار داشت که آزمایشهای هستهای روزانه در سراسر جهان ادامه دارد

- راهی برای کاهش عوارض جانبی شیمی درمانی پیدا شد

- پوتین: روسیه مشتاق تقویت روابط حسن همجواری و اعتماد متقابل با سایر کشورها است

- آمریکا از موضع ترامپ در قبال روسیه ابراز نگرانی میکند

- لیورپول پس از شکستهای متوالی تحقیرآمیز، تصمیم نهایی خود را برای اخراج آرنی اسلات گرفت

- یک آتشفشان زیر آب در سواحل ایالات متحده در حال آماده شدن برای فوران است

- «دیوانه» ... جمله تحریکآمیز ستاره منچسترسیتی درباره گواردیولا

- زاخارووا: نیروهای اوکراینی با منفجر کردن سدها سعی در جلوگیری از پیشروی ارتش روسیه دارند

- وزارت دفاع چین ابراز امیدواری کرد که همکاری مثبتی با ایالات متحده داشته باشد

- پزشکان آسیبپذیری زنان در برابر بیماری انسدادی مزمن ریه (COPD) را آشکار کردهاند

- ایالت نیویورک آمریکا به دلیلی عجیب و غافلگیرکننده وضعیت اضطراری اعلام کرد!

- «پس از یک رسوایی بزرگ»، فرانسه قانون جدیدی در مورد تجاوز و آزار جنسی تصویب کرد

- دانشمندان دانشگاه ایالتی مسکو روشی برای پاکسازی مؤثر بستر دریا از نفت کوره ابداع کردهاند

- یک مقام آمریکایی جزئیات آزمایشهای هستهای اعلامشده را فاش کرد

- ونس دلیل اصلی تصمیم ترامپ برای شروع آزمایشهای هستهای را عنوان کرد

- دانشمندان روسی فایده غیرمنتظرهای در پروتزهای استخوانی آسیبدیده یافتهاند

- انتقاد پولیانسکی از رأی «مختل» مقامات کییف در سازمان ملل

- کارشناسان توضیح دادهاند که هنگام پرواز باید مراقب چه چیزهایی باشید

- اوکراین از تصمیم ترامپ و شی جین پینگ در مورد زلنسکی نگران است

- گونه جدیدی از کرم آکاردئونی دریایی در سواحل اسپانیا کشف شد

- دانشمندان با بازنویسی کل تکامل نرمتنان، معمای یک فسیل باستانی را حل کردند

- کارشناس بریتانیایی: «گنبد طلایی» آمریکا قادر به رهگیری موشک «بوروستنیک» نخواهد بود

- ترامپ در گفتوگو با شی جین پینگ، تشدید تحریمها علیه روسیه را زیر سوال برد

- ستارهشناسان یک سیاهچاله سرکش را کشف کردهاند که در حال متلاشی کردن یک ستاره است

- مردی که به اتهام تلاش برای ترور ترامپ محکوم شده است، به دلیلی عجیب درخواست انتقال به زندان دیگری را دارد

- دانشمندان اسرار «صخرههای فضایی» - یکی از زیباترین اجرام فضایی - را کشف کردهاند

- هیگسِت به ارتش دستور میدهد دهها وکیل در اختیار وزارت دادگستری ایالات متحده قرار دهد

- اروگوئه مرز خود با برزیل را تقویت کرده است

- ادن هازارد: از اینکه در تالار مشاهیر لیگ برتر قرار گرفتهام بسیار مفتخرم، این برایم خیلی معنی دارد

- برای اولین بار یک «یخچال دریایی» در قطب جنوب کشف شده است که یخ همسایه خود را میدزدد

- رسانههای بریتانیایی خلاصهای از حکومت رژیم کییف برای ادامه درگیری علیه روسیه نیاز دارد را ارائه میدهند

- رسانهها: دیپلمات ارشد اتحادیه اروپا در نبرد قدرت در اتحادیه اروپا شکست خورد

- فیزیکدانان نوع جدیدی از ابرروانکننده را کشف کردهاند: نانومسیرهایی برای اتمها

- شزنی راز مهار پنالتی امباپه در ال کلاسیکو را فاش کرد

- یک سناتور آمریکایی درباره مقیاس آزمایشهای هستهای در آمریکا صحبت کرد

- اسرار جدید سیاره زهره دانشمندان علوم سیارهای را گیج کرده است

- پادشاه بریتانیا پس از افشای رسواییهای جنسی شاهزاده اندرو، اقدامات لازم برای سلب عناوین و عناوینش را آغاز کرد

- مقامات عالی رتبه آمریکایی نقل مکان به پایگاههای نظامی را آغاز کردهاند

- مشخص شد که چرا گربهها معمولاً بیشتر از سگها عمر میکنند

- «کاملاً بسته»: الجزایر هرگونه تلاش برای از سرگیری صادرات گاز به اسپانیا از طریق مراکش را قاطعانه رد میکند

- زاخارووا اظهار داشت که اوکراین میخواهد یک فاجعه انسانی ایجاد کند

- «ترامپ اشتباه نمیکند» ... مسکو ماهیت آزمایشهای بوروستنیک و پوزیدون را روشن میکند: این یک آزمایش هستهای نیست

- لیورپول با بدترین رکورد جام حذفی این باشگاه در ۹۲ سال گذشته برابری کرد

- آنها کاملاً "بدون انتشار" نیستند... حقایق تکان دهنده در مورد اتومبیلهای برقی

- دانشمندان راز سلاحهای باستانی نزدیکترین خویشاوندان انسان را کشف کردند

- وزیر خزانهداری آمریکا نسبت به تشدید پیامدهای اقتصادی ناشی از تعطیلی دولت هشدار داد

- با پیشتازی عربستان سعودی، عرضه اولیه سهام خاورمیانه ۷۰۰ میلیون دلار جمعآوری کرد

- در چین، وبلاگنویسانی که مدرک دانشگاهی ندارند، از صحبت کردن در مورد موضوعات «جدی» منع شدهاند

- دانشمندان راز یک باکتری دریایی که نفت را تجزیه میکند، کشف کردند

- فیلیپوت: وزیر دفاع بلژیک که مسکو را تهدید کرد، «خطری برای جامعه» محسوب میشود

- رائول آلبیول انتقادات را بین لمینه یامال و وینیسیوس توزیع میکند

- لوئیس آلبرتو دروازه اسپانیا را باز میکند

- رایان چرکی، یک انتخاب خوب

- سرمربی رئال مادرید تلاش میکند آلونسو و وینیسیوس را که با هم صحبت نمیکنند، آشتی دهد

- هواداری که به راشفورد توهین نژادپرستانه کرد، با جریمه ۴۰۰۰ یورویی روبروست

- آنگولا ۱۲ میلیون یورو برای بازی مقابل آرژانتین هزینه خواهد کرد، در حالی که روسیه پیش از این به دلیل هزینهها از این کار خودداری کرده بود

- تغییر در آینده کلودیو اچوری

- چلسی برای تمدید قرارداد تلاش میکند

- لیورپول در آستانه بازی حساس مقابل استون ویلا، دو ضربه دردناک را متحمل شد

- بایرن مونیخ برای ویزدم مایک بااستعداد برنامهای دارد

- چیوو، سرمربی اینتر، درباره پیروزی مقابل فیورنتینا اظهار نظر کرد

- TBR: عربستان سعودی به صلاح ۱۵۰ میلیون پوند در سال و به رونالدو ۱۷۵ میلیون پوند پیشنهاد داده است

- گواردیولا، سرمربی منچسترسیتی: سوانسی خوب بازی کرد، اما ما بازی را به دست خودمان گرفتیم

- بورنموث آماده جذب بازیکن است

- خروج گسترده بازیکنان از اتلتیکو مادرید در ژانویه

- بمب در مورد آینده ارلینگ هالند

- فوتبال ایتالیا: پاتریک ویرا ممکن است از سرمربیگری جنوا برکنار شود

- لیورپول میتواند برای جذب این ملیپوش انگلیسی با منچسترسیتی رقابت کند

- گزینهای برای جناح چپ لاتزیو

- کریل گلبوف شور و شوق را در اروپا بر میانگیزد

- پدرو رودریگز برنامههای آیندهاش را اعلام کرد

- وراتی توضیح میدهد که چرا پاری سن ژرمن با مسی، امباپه و نیمار نتوانست قهرمان لیگ قهرمانان اروپا شود

- نیکلاس سوله ممکن است تابستان آینده بوروسیا دورتموند را ترک کند

- تورلو: رئال مادرید میتواند هدف نقل و انتقالاتی بارسلونا در لالیگا را از چنگش دربیاورد

- دو گزینه محبوب برای خط میانی منچستر یونایتد

- باشگاه فوتبال بارسلونا تمدید قرارداد را نهایی کرد

- مارک گوئهی رئال مادرید را انتخاب کرد

- پلتنبرگ: کلوپ شخصاً با مدیر ورزشی که میخواهد به سالزبورگ دعوت کند تماس گرفت

- اتحادیه ملی بسکتبال آمریکا (NBA) فروش سهام کنترلی لیکرز به یکی از مالکان چلسی را تأیید کرد

- مورتو: بورنموث میخواهد الخاندرو خیمنز را از میلان بخرد

- اسپورتینگ لیسبون نونو مندس بعدی خود را کشف کرد: یک جواهر ۱۰۰ میلیون یورویی

- هدف شماره یک سویا تغییر میکند

- رقابت رئال مادرید و بارسلونا برای کسب جایگاه نهم!

- شزنی: رونالدو مشهورترین فرد در مخاطبین من است، اما با او تماس نمیگیرم!

- آلبا درباره مسی: هرگز فکر نمیکردم در کنار بهترین فوتبالیست تاریخ بازی کنم

- ماتوی سافونوف در کنسرت کمدین ایوان اوسوویچ در پاریس شرکت کرد

- درخواست کلیدی دایوت اوپامکانو از بایرن مونیخ

- یوونتوس تورین از یک هافبک جاسوسی میکند

- آدام وارتون، اولویت خرید

- روزنامه سان: دی بروین ۳۴ ساله به دلیل مصدومیت در خطر از دست دادن جام جهانی ۲۰۲۶ است

- پلاتنبرگ: مدافع جوان نانت توجه باشگاههای برتر اروپا را به خود جلب کرده است

- اسپارتاک برای جذب مدافع ۲۰ ساله برزیلی با دینامو کیف رقابت خواهد کرد

- ژابی آلونسو: «مشکل با وینیسیوس حل شد»

- کارلوس کوربران آرام میماند

- سانتیاگو مورینو جدایی خود از اتلتیکو مادرید را توجیه کرد

- اسکای: قرارداد هشت ماهه اسپالتی با یوونتوس شامل گزینه تمدید اجباری نمیشود

- اسپالتی در سری آ ۹۹۶ امتیاز کسب کرده است که دومین رکورد برتر در بین مربیان فعال است

- تریولا: ایجنتهای آلوز، بازیکن زسکا مسکو، کار روی انتقال او به لیگهای برتر اروپا را آغاز کردهاند

- چشمک لوکا ووشکوویچ به رئال مادرید

- خریدی که بایرن مونیخ میتواند از بارسلونا بدزدد

- الساندرو دل پیرو واقعیت تلخ یوونتوس در تورین را بازگو میکند

- وینیسیوس پس از رسوایی در بازی با بارسلونا با آلونسو صحبت کرد

- در اسپانیا، آنها با اشاره به د لا فوئنته، به مشاجره بین کارواخال و یامال در ال کلاسیکو واکنش نشان دادند

- باشگاه الاهلی قاهره در مورد شایعات مربوط به انتقال احتمالی صلاح بیانیهای صادر کرد

- وینیسیوس جونیور-ژابی آلونسو: داستان جدایی اعلام شده

- باشگاه اتلتیک بیلبائو در حال بررسی آیندهای بدون ارنستو والورده است

- منچستر یونایتد فروش ۴۴ میلیون یورویی را تکمیل کرد!

- کانیزارس در مورد رفتار وینیسیوس گفت: «او از آلونسو رفتار خاصی دریافت نخواهد کرد.»

- پدرو، قهرمان جهان و اروپا، اعلام کرد که در پایان فصل از لاتزیو جدا خواهد شد

- گابی در مورد رفتار وینیسیوس، مهاجم رئال مادرید، گفت: «چه اتفاقی دارد میافتد؟»

- سرجیو فرانسیسکو هنوز در لبه پرتگاه است

- بارسلونا، اتلتیکو، تاتنهام... رقابت برای جذب میسون گرینوود در حال افزایش است

- تونی کروس به وینیسیوس کمک میکند

- سرمربی موناکو در مورد بازگشت احتمالی پل پوگبا اظهار نظر کرد

- دیاریو اسپورت: لامین یامال، مهاجم بارسلونا، ممکن است نیاز به عمل جراحی داشته باشد

- پالمیراس پس از شکست ۳-۰ در بازی رفت، به فینال کوپا لیبرتادورس رسید

- سون هیونگ مین آخرین نقشهاش را برای تاتنهام دارد

- کاملاً؛ «دنی کارواخال تمام شده است»

- وحشت از سرهو گیراسی!

- بولیکین: مهمترین چیز برای زاخاریان این است که خودش را در لالیگا ثابت کند و احساس اعتماد به نفس داشته باشد

- روزنامه سان: قیمتی که وستهام یونایتد حاضر است برای پاکتا بپردازد، مشخص شد

- دادگاه فرجامخواهی یوفا علیه سوپرلیگ را رد کرد

- وینسنت کمپانی خبر خوب برای بایرن مونیخ را تایید کرد

- آیندهای غیرمنتظره برای اسکات مکتامینی

- منچستریونایتد در حال مذاکره برای جذب بازیکنی با مبلغ ۳ میلیون یورو برای ژانویه است

- خولیان آلوارز: من بیشتر به پیروزی مقابل اتلتیکو علاقه دارم تا گلزنی

- سمین: رئال سوسیداد در بازی کوپا دل ری به زاخاریان فرصت داد و او هم به وظیفه خود عمل کرد

- کوین دی بروین حداقل تا فوریه برای ناپولی بازی نخواهد کرد

- آندونی ایرائولا برای آینده برنامهای دارد

- قراردادی که آینده لنارت کارل را شکل خواهد داد