- ارتباط با ما

- |

- درباره ما

- |

- نظرسنجی

- |

- اشتراک خبری

- |

- نگارنامه

کارایی پردازش مدلهای زایا با این شتابندهها افزایش مییابد!

به گزارش مجله خبری نگار/برنا،تراشههای جدید کوالکام با ۱۰ برابر پهنای باند و ۷۶۸ گیگابایت حافظه، آینده پردازش هوش مصنوعی در مراکز داده را متحول میکنند.

به گزارش نیواطلس، کوالکام با معرفی شتابدهندههای جدید هوش مصنوعی خود با نامهای AI ۲۰۰ و AI ۲۵۰، گامی بزرگ در جهت افزایش سرعت، بهرهوری و مقیاسپذیری پردازش مدلهای زایا (Generative AI) در مراکز داده برداشته است.

این تراشهها که بر پایه فناوری واحد پردازش عصبی (NPU) کوالکام طراحی شدهاند، عملکردی در مقیاس رک (Rack-scale) با ظرفیت حافظه بسیار بالا ارائه میدهند. هدف اصلی کوالکام از این محصول، فراهم کردن امکان اجرای سریع و کمهزینه مدلهای هوش مصنوعی زایا با حداکثر بهرهوری انرژی و هزینه است معیاری کلیدی در زیرساختهای مدرن هوش مصنوعی.

قدرت در مقیاس انبوه

مدل AI ۲۰۰ بهطور ویژه برای پردازش مدلهای زبانی بزرگ و چندوجهی طراحی شده و هر کارت آن از ۷۶۸ گیگابایت حافظه LPDDR پشتیبانی میکند که امکان مقیاسپذیری بالا و انعطاف در پردازش حجم عظیمی از دادهها را فراهم میسازد.

در مقابل، مدل AI ۲۵۰ با معماری جدید «محاسبه نزدیک به حافظه» (Near-Memory Computing) عرضه میشود که به گفته کوالکام، بیش از ۱۰ برابر پهنای باند مؤثر حافظه بیشتر و مصرف انرژی کمتر دارد. این نوآوری باعث میشود سختافزارها بهصورت بهینهتر و با هزینه کمتر مورد استفاده قرار گیرند.

هر دو سیستم از خنککننده مایع مستقیم برای کارایی حرارتی بالا و رابطهای PCIe و Ethernet برای مقیاسپذیری بیشتر بهره میبرند. توان مصرفی در سطح رک حدود ۱۶۰ کیلووات است، که نشاندهنده عملکردی در سطح زیرساختهای ابرمقیاس با تمرکز بر پایداری و بهینهسازی عملیاتی است.

یکپارچگی نرمافزاری و سازگاری گسترده

«در کوالکام با سری AI ۲۰۰ و AI ۲۵۰، تعریف تازهای از توان پردازش هوش مصنوعی در مقیاس رک ارائه کردهایم»،

«دورگا مالادی»، معاون ارشد کوالکام در حوزه فناوری لبه و مراکز داده گفت. او افزود این زیرساخت جدید، اجرای مدلهای هوش مصنوعی زایا را با هزینه کل مالکیت (TCO) بیسابقهای ممکن میسازد.

این پلتفرم با پشتیبانی از اکوسیستم باز نرمافزاری کوالکام، امکان ادغام آسان مدلهای از پیش آموزشدیده، مدیریت مقیاسپذیر و استقرار یککلیکی را فراهم میکند. همچنین از کتابخانه «Efficient Transformers» و مجموعه ابزار «AI Inference Suite» پشتیبانی میکند تا توسعهدهندگان بتوانند مدلهای خود را مستقیماً از پلتفرمهایی مانند Hugging Face بارگذاری کنند.

نقشه راه آینده

کوالکام اعلام کرد مدل AI ۲۰۰ در سال ۲۰۲۶ و مدل پیشرفتهتر AI ۲۵۰ در ۲۰۲۷ به بازار عرضه خواهند شد. این شرکت قصد دارد هر سال نسل جدیدی از محصولات مرکز داده خود را معرفی کند که بر افزایش کارایی، بهرهوری انرژی و بهبود مستمر در استنتاج هوش مصنوعی (AI Inference) تمرکز دارند.

- لطفا از نوشتن با حروف لاتین (فینگلیش) خودداری نمایید.

- از ارسال دیدگاه های نا مرتبط با متن خبر، تکرار نظر دیگران، توهین به سایر کاربران و ارسال متن های طولانی خودداری نمایید.

- لطفا نظرات بدون بی احترامی، افترا و توهین به مسئولان، اقلیت ها، قومیت ها و ... باشد و به طور کلی مغایرتی با اصول اخلاقی و قوانین کشور نداشته باشد.

- در غیر این صورت، «نگارمگ » مطلب مورد نظر را رد یا بنا به تشخیص خود با ممیزی منتشر خواهد کرد.

- آخرین اخبار

- محبوب

- برچسب های داغ

- دانشمندان راز عذرخواهی بینقص را فاش کردند

- سازمان بهداشت جهانی: خودکشی عامل یک درصد مرگ و میرها در جهان است

- JoHS: دانشمندان ویژگیهای شخصیتی مشترکی را در بین افراد صد ساله شناسایی کردهاند

- چگونه از روی وضعیت ابروهای یک فرد بفهمیم که او مشکل سلامتی دارد

- دروازهبان اینترمیلان با ماشینش به یک مردی که روی ویلچر نشسته بود، زد و جان باخت

- چه زمانی سردرد نیاز به مراقبت فوری پزشکی دارد؟

- هشدار مطالعه: ورزش شدید میتواند به قیمت جان زنان تمام شود!

- دانشمندان محصولی را شناسایی کردهاند که کیفیت زندگی صمیمی را بهبود میبخشد

- غذاهای غیرمعمول که با چین و چروک و افتادگی پوست مبارزه میکنند

- هزاران متجاوز جنسی در مشهورترین شهر آمریکا زندگی میکنند و ساکنان را به وحشت میاندازند

- سازمان بهداشت جهانی: تا ۳۰ سال آینده از هر چهار نفر، یک نفر دچار مشکلات شنوایی خواهد شد

- ویدئو| مسی نامزد جایزه معتبر MLS شد

- دانشمندان فاش کردهاند که چرا نباید دوستان را با شریک عاطفی جایگزین کنید

- مطالعه: پیادهروی فقط دو بار در هفته میتواند عمر زنان را طولانیتر کند

- قهرمان UFC ابراز تمایل کرد که با ارلینگ هالند، فوتبالیست، تمرین کند

- مستره: مسی و خانوادهاش از رئیس بارسلونا، لاپورتا، بسیار عصبانی هستند

- آنتیاکسیدانی که با سفیدی مو مبارزه میکند

- ستاره شدن در ورزشگاه به یک دارایی تجاری تبدیل میشود... رونالدو در میان برترین ورزشکاران جهان قرار دارد

- موهای خاکستری و رابطه شگفت انگیز آن با پیشگیری از سرطان!

- یک استاد دانشگاه دو محصول را نام برد که امید به زندگی را ۱۰ سال کاهش میدهند

- حل معمای پیدایش آب روی زمین به کمک ماه!

- چطور میتوان ظرفها را تمیز شست؟

- فشار خون به فصل ارتباط دارد؟

- رشد دوباره مو در سلولهای چربی نهفته است!

- درختان کهنسال گلدان دار میشوند!

- تنفس مصنوعی از راه روده!

- درمان سرطان تخمدان با کمک یک گیرنده سطح سلولی!

- علائم بروز سکته مغزی! + نقش مهم زمان!

- یک فنجان آب انار ضامن سلامت قلب!

- چگونه سالم لاغر شویم؟

- ثروتمندترین افراد جهان با هوش مصنوعی پولدارتر شدند!

- مولکولی که میتواند گرسنگی را از بین ببرد!

- اپل روند ساخت آیفون را تغییر میدهد!

- حسگری که افزایش اشعه خطرناک UV را هشدار میدهد!

- رفتار عجیب زنبورهای عسل در مقابل ملکه!

- رکورد طولانیترین مدت بقا با کلیه خوک شکسته شد!

- کارایی پردازش مدلهای زایا با این شتابندهها افزایش مییابد!

- پیشگیری از ابتلا به سرماخوردگی با سادهترین نکات!

- دوچرخه برقی برای پاها! عنوان پروژه جدید شرکت نایکی!

- افزایش عمر گوشی با ۷ ترفند ساده!

- زنان دو برابر مردان مستعد افسردگی هستند!

- عینک هوشمندی که بینایی نابینایان را بازمیگرداند!

- استویا میتواند راهی برای درمان کچلی باشد!

- دلیلی که باید به نوزاد بادام زمینی بدهید!

- افزایش دمای زمین باعث مرگ میشود؟

- داغی و سوزش کف پا نشانه چه بیماریهایی است؟

- بیماریهای قلبی و عروقی چه مقدار کشته میدهند؟

- فضای حافظه گوشی را میتوانید از طریق واتساپ مدیریت کنید!

- ایلان ماسک همچنان هوش مصنوعی و رباتها را چیره بر انسانها دید!

- چتباتهای هوش مصنوعی میتوانند توهم ایجاد کنند!

- معرفی بهترین زمان مصرف امپرازول و پنتوپرازول

- الگوریتم هوش مصنوعی میتواند خطر ابتلا به بیماریهای قلبی را عددی بیان کند!

- کمخونی ناشی از فقر آهن با این مکمل ترکیبی درمان میشود!

- روشهای فوری و معجزهآسای لاغری قابلیت عملی شدن دارند؟

- در زمان اسهال چی بخوریم؟

- پیرگوشی تحت تاثیر چه عواملی ایجاد میشود؟

- خاصیت لبو برای نوزادان و کودکان!

- بلعیدن آدامس خطرات ترسناکی دارد؟

- فیناستراید دارویی که باعث ایجاد افکار خودکشی میشود!

- داروهای مسکن و تببر استامینوفن برای دوران بارداری خطرناک است؟

- نوشیدنیهای انرژیزا میتوانند عامل خودکشی باشند!

- شش ترکیب پرمصرف که برای سلامتی مضرند!

- مصرف طولانی مدت امپرازول عوارض دارد؟

- نگهداری سیر تازه در روغن خطرناکترین روش است!

- یک نشانگر زیستی درمانی جدید برای سرطان تخمدان!

- درمان مشکل ضربان قلب با کمک پرتودرمانی!

- مهمترین عامل در بروز سکتههای مغزی چیست؟

- بسیار از سرطانها در مراحل اولیه قابل درمان هستند!

- اگر بیماری پرفشاری خون دارید، برای مصرف داروها به این نکات نیاز دارید!

- استنشاق گاز قرص برنج هم خطری است؟

- بیماری پسوریازیس باید سریعا تشخیص داده شود!

- بررسی اثرات فشار خون در فصل پاییز!

- آلرژی کودک به این آجیل را اینگونه از بین ببرید!

- مصرف مواد غذایی کپکزده خطر سرطان دارد!

- آمار عجیب ابتلای افراد به سکته مغزی!

- دید دقیق قویترین رصدخانه فضایی جهان واضحتر میشود!

- چگونه دمای دقیق بدن را اندازهگیری کنیم؟

- کرمی که بعد از ۴۶ هزار سال یخزدگی زنده شد!

- ساخت نمونه اولیه یک دستکش هوشمند تایید شد!

- فضای باز اعتماد به نفس کودک را زیاد میکند!

- مسی بهترین ورزشکاران در بین تمام رشتههای ورزشی را انتخاب کرد

- دلیل پاملا اندرسون، ۵۶ ساله، برای کنار گذاشتن آرایش

- جانیک سینر و کیلیان امباپه در رستورانی در پاریس با هم آشنا شدند

- خاطرات قربانی اپستین، افشاگری تکاندهندهای را در مورد شریک زندگی او و یک بازیگر بینالمللی آشکار میکند

- ستاره سریال «بازی تاج و تخت» با نامزد سابق داکوتا جانسون قرار ملاقات میگذارد

- همسر بیبر درباره درمانهای صورتش صحبت میکند

- تیماتی یکی از گرانترین ماشینها را به نامزدش داد

- حمله همسر وزیر بهداشت آمریکا به دلیل «رسوایی پیامکهای جنسی» به یک روزنامهنگار مشهور

- هایدی کلوم به مناسبت تولد ۱۶ سالگی دخترش، عکسی کمیاب از او در کنار دخترش منتشر کرد

- رشفورد نتوانست بین مسی و رونالدو یکی را انتخاب کند

- مودریچ برای همه بازیکنان میلان آیفون خرید تا مجبور نباشد جلوی تیم آهنگ اجرا کند

- عکس| واکنش همسر یاسر الزبیری پس از قهرمانی مراکش در جام جهانی زیر ۲۰ سال فیفا

- نیکول کیدمن ۵۸ ساله راز زیبایی خود را فاش کرد

- شاهزاده اندرو به ارتباط با اپستین در بریتانیا متهم شده است

- جیجی حدید علناً خطاب به بردلی کوپر گفت: «عشق من»

- برد پیت رابطهاش با اینس د رامون را به سطح بالاتری برد

- مگان مارکل عکسی از خودش و دخترش را به اشتراک گذاشت

- پاسخ شاهزاده هری به اتهامات همسرش مبنی بر بیاحترامی به مادرش فاش شد

- دختر ۱۴ ساله بکهام برند لوازم آرایشی خودش را تأسیس خواهد کرد

- جزئیات رابطه جنیفر لوپز و بن افلک پس از تجدید دیدار فاش شد

- عکس| دمبله برای جشن گرفتن بردن توپ طلا، یک جفت کفش اختصاصی دریافت کرد

- شایعات عاشقانه جرد لتو قوت گرفت

- پدری، هافبک بارسلونا، با قرار دادن یک بازیکن سابق رئال مادرید در فهرست خود، فوتبالیست ایدهآل را انتخاب کرد

- کیتی پری سکوت خود را در مورد رابطهاش با نخستوزیر سابق کانادا شکست

- بردلی کوپر مشکوک به جراحی پلاستیک است: "قبلاً بهتر بود"

- «لئو از صحبتهای شخصی خوشش نمیآید.» دییونگ توضیح داد که چطور از مسی تعریف و تمجید شده است

- مشخص شد که چرا خانواده بکهام در عروسی سلنا گومز شرکت نکردند

- پاریس هیلتون هفتهای ۹ ساعت را صرف مراقبتهای صورت میکند

- همسر جاستین بیبر توضیح داد که چرا او و این خواننده پسرشان را به نمایش نمیگذارند

- شوهر ستاره جیمز باند دستگیر شد

- همسر بیبر فاش کرد که با یک میلیارد دلار حاصل از فروش برندش چه خواهد کرد

- کیم کارداشیان دلیل طلاقش از کانیه وست را فاش کرد: "حمله دیگری اتفاق افتاده است"

- کیم کارداشیان با اعتراف به اینکه از قیمت مواد غذایی خبر ندارد، طرفدارانش را شوکه کرد

- بریتنی اسپیرز همسر سابقش را به قلدری متهم کرد: «دیگر بس است»

- شارلیز ترون به خاطر بیاحترامی به جانی دپ مورد انتقاد قرار گرفت: "او بیادب است. "

- کیث اربن پس از جدایی از نیکول کیدمن، رابطه عاشقانه جدیدی را آغاز کرده است: «او در شوک است.»

- مادر سلنا گومز به شایعات مربوط به رسوایی در عروسی دخترش پاسخ داد

- همسر بروس ویلیس گفت فرزندانش از همین حالا برای پدرشان سوگواری میکنند

- هواداران نیکول کیدمن پس از انتشار خبر طلاق، به کیت اربن حمله کردند

- فائزه العماری از مبارزه امباپه با شهرت میگوید

- بوفون در مورد انتخاب پسرش برای بازی در تیم ملی جمهوری چک: در ایتالیا، بار نام خانوادگیاش او را خرد میکرد

- پیشخدمت پرنسس دایانا راز جدیدی را در مورد کاخ باکینگهام فاش کرد

- پسر ۲۱ ساله راسل کرو به خاطر تصویرش مورد انتقاد قرار گرفت: «او مثل پدرش نیست.»

- نیکول کیدمن پس از جدایی از کیث اربن بیانیهای صادر کرد

- مگان مارکل به خاطر تمسخر یک مدل محکوم شد: «این حرفها خیلی گویای شخصیت واقعی اوست»

- ویکتوریا بکهام میگوید به خاطر شوهرش لبخند نمیزند

- جنیفر آنیستون اعتراف کرد که ۲۰ سال برای بچهدار شدن تلاش کرده است

- آنجلینا جولی، ستاره بینالمللی، درباره طلاقش از برد پیت، بازیگر مشهور، صحبت کرد و شکایت جدیدی علیه او مطرح کرد

- این دوچرخه سوار اسپانیایی تادژ پوگاچار را با بارسلونا یوهان کرایف مقایسه کرد

- کیت میدلتون با کت و شلوار سبز با "شکلات دبی" مقایسه شد

- جورج کلونی برای اولین بار درباره مصرف مواد مخدر صحبت کرد: «مشکلی نبود»

- شایعات نامزدی هرمیون گرنجر، ستاره هری پاتر، قوت گرفت

- «مدت زیادی تحریک و تحقیر شدم.» لروی سانه در اکتبرفست دعوا راه انداخت

- رایت: اگر کین از بایرن به تاتنهام برگردد، رکورد گلزنی شیرر در لیگ برتر را خواهد شکست

- رپر معروف، دیدی، به ۵۰ ماه زندان محکوم شد

- تام هالند برای اولین بار نامزدی خود با زندایا را تایید کرد

- نیکول کیدمن و کیث اربن جدایی خود را اعلام کردند

- حبیب پدرش را با سر الکس فرگوسن افسانهای مقایسه کرد

- مادر حدید، مدل معروف، مزرعه خانوادگیشان در پنسیلوانیا را برای فروش گذاشته است

- پسر بکهام در مورد شایعات اختلاف با والدینش: «مردم حرفهای منفی میزنند»

- حمایت بانکها از بازار سرمایه از فردا اجرا میشود

- بورس سقوط کرده در دولت روحانی چگونه در دولت شهید رئیسی احیا شد؟

- درمان بورسی پزشکیان از زبان عبده

- جذب سرمایه ۷ همتی از بازار بورس دانشبنیانها

- وعده عناب بورسی واقعیتر شد

- چهارمین روز نزولی بازار در غیاب نیروهای صعودی

- انتخابات و دامنه نوسان مهمترین دلیل رکود فعلی بورس

- بورس با ۴ مصوبه دولت برای حمایت از بازار سهام سبزپوش میشود؟

- ۳ دلیل پایین بودن ارزش معاملات خرد در بورس

- معافیتهای مالیاتی بازار سرمایه باید استمرار پیدا کند

- بورس این روزها تحت تأثیر تداوم نرخ اخزای بالای ۳۵ درصد

- رشد شاخصهای بورس با کف سازی تکنیکال

- کاهش دامنه نوسان هم علاج بورس نزولی نبود

- سایه تامین مالی دولت بر سر بورس سنگینی میکند

- کاهش بی سابقه حجم معاملات سهام در بورسهای جهانی

- رشد شاخصهای بورس با کمک بانکیها و اعلام نرخ تسعیر ارز

- حمله به سفیر روسیه در لهستان

- معرفی سری گوشیهای Redmi K ۵۰ قبل از رونمایی رسمی

- غفوری: فکر کردن به قهرمانی از الان، سادهلوحانه است

- کاهش ۱۰ درصدی تولید هوندا در دو کارخانه

- سومین نشست دستمزد، باز هم بدون نتیجه

- لغو بلیت فروشی عمومی المپیک زمستانی چین

- گرامیداشت قربانیان هواپیمای اوکراینی در دانشگاه تورنتو

- ادامه چانهزنی چهارگانه در وین

- صرفهجویی ۱.۶ میلیارد دلاری کمیته برگزاری المپیک و پارالمپیک توکیو

- محبوبترین رشته المپیک توکیو مشخص شد

- اعلام هزینه میزبانی توکیو از المپیک و پارالمپیک ۲۰۲۰،

- آذرتاج: هیات اقتصادی جمهوری آذربایجان به ایران میرود

- بررسی عملکرد ایران در المپیک؛ جایگاه چهارمی در آسیا

- پایان وضعیت اضطراری در کشور میزبان المپیک ۲۰۲۰

- خردل: طعمی متمایز و فواید شگفتانگیز برای سلامتی

- «استعداد درخشان» دختر جوان، وحشتناک شد

- زوجها برای به دنیا آوردن فرزند اول زیاد صبر میکنند؟!

- از تهران تا سئول نامتوازن بود؟!

- لذت و دلهره| پسانداز در شرایط بیثباتی اقتصای کشور معنایی دارد؟

- در و دیواری که گالری نقاش را رقم زدند

- شما خوشبختی رو چی معنی میکنید؟!

- راز داشتن حال خوب از بشقاب شما شروع میشود! در اینجا بهترین غذاها را معرفی میکنیم

- چرا کودکان هم وارد بازی عملهای زیبایی شدند؟

- کشف پروتئینی که به تشخیص یک سرطان جدی در زنان کمک میکند

- JAMA: سطح تحصیلات بر خطر ابتلا به بیماریهای قلبی عروقی تأثیر میگذارد

- کلینیک مایو: لنف ادم خطر ابتلا به سرطان را دو برابر میکند

- یک متخصص تغذیه بهترین منابع آهن و نحوه جذب آن را توضیح میدهد

- یک متخصص، مفیدترین تمرینات ورزشی برای مردان بالای ۴۰ سال را معرفی کرد

- eCM: وضعیت نادرست بیمار نتایج اندازهگیری فشار خون را تحریف میکند

- یک ماده شیمیایی در زیتون راز پیشگیری از بیماریهای مغزی و حافظه را در خود دارد

- سرطان پوست غیرملانومی کشندهتر از ملانوما است

- روسیه یک ماده زیست تخریب پذیر برای بهبود بازسازی استخوان تولید میکند

- کارشناسان آلمانی خواستار افزایش دورهای مالیات بر دخانیات برای جلوگیری از سرطان شدند

- دانشمندان ثابت کردهاند که جایگزینی کوتاهمدتِ نشستن با خواب برای قلب مفید است

- اردن: تصمیم برای جمعآوری لاک ناخن ژلهای از بازار، خشم رسانههای اجتماعی را برانگیخت

- Live Science: خندهی شدید میتواند باعث غش کردن شود

- JAMA: متخصصان قلب دوز مشخصی از نمک را شناسایی کردهاند که فشار خون را تا ۷ درصد کاهش میدهد

- خشونت جنسی یکی از نگرانیهای عمده زنان در اردوگاههای پناهندگان روهینگیا در بنگلادش است

- مصرف مکمل ویتامین D در دوران بارداری خطر ابتلا به آسم در کودکان را کاهش میدهد

- باکتریهای خفته در رسوبات چربی روی دیوارههای شریانی ممکن است باعث حملات قلبی شوند

- سه میوه و یک توت شناسایی شدهاند که به کاهش کلسترول "بد" کمک میکنند

- دیلی میل: متخصص تغذیه معایب گوشت گیاهی را فهرست میکند

- واکسن آزمایشی علیه تمام گونههای شناخته شده و آینده آنفولانزای مرغی

- کشف «مولکول» مسئول حافظه بلندمدت در مغز

- BMJ: اختلالات روانی خطر ابتلا به بیماریهای جسمی را دو برابر میکند

- قوانین مهم برای پیشگیری از فشار خون بالا

- یک مطالعه راز واقعی فواید رژیم غذایی گیاهی برای سلامت قلب را آشکار میکند

- دیلی میل: پسوریازیس ممکن است خطر حمله قلبی و سکته مغزی را افزایش دهد

- لنست: دیابت ۱۴ سال از عمر انسان کم میکند

- دانشمندان کشف کردهاند که ضربان قلب میتواند اطلاعاتی در مورد سلامت مغز فاش کند

- ایالات متحده: دستمالهای مرطوب پاککننده آرایش محبوب پس از کشف باکتریهای خطرناک، فراخوان شدند

- سرفه مداوم میتواند نشانه ابتلا به سرطان تیروئید باشد

- مطالعه: تغذیه با شیر مادر، ایمنی طولانی مدت در برابر سرطان سینه را افزایش میدهد

- دانشمندان استرالیایی ارتباطی بین کمبود پروتئین و چاقی کشف کردهاند

- ارز

- طلا

- بورس

- تورم

- اخبار داغ

- ورزشی

- پربیننده

- پربحث

- بانک مرکزی اروپا نرخ بهره را در سطح فعلی خود نگه میدارد

- کانادا قطعات سیستم موشکی به اوکراین اهدا میکند

- «زمین، مریخ و هزاران ماهواره را لرزاند»: پیامدهای یک طوفان خورشیدی قدرتمند آشکار شد

- رویترز: تعطیلی دولت آمریکا، فعالیتهای افبیآی را مختل کرده است

- چین قصد دارد تا سال ۲۰۳۰ فضانورد به ماه بفرستد

- آمریکا علت درگیری ناتو و روسیه را شناسایی کرده است

- اپل از شرکت چینی اوپو به اتهام جاسوسی شکایت کرد

- دانشمندان آخرین مانع تبدیل سلولز به سوخت زیستی را شکستند

- پدر ایلان ماسک درباره سفرهای مخفیانه پسرش به مسکو صحبت میکند

- روسیه، آمریکا را به تلاش برای ایجاد اختلال در روابط روسیه و ونزوئلا متهم کرد

- ترامپ درباره بحران اوکراین: گاهی اوقات باید به طرفین یک درگیری اجازه جنگیدن داده شود

- اوربان احتمال حمله به پالایشگاه نفت روسیه را رد نکرد

- افبیآی به دلیل تعطیلی دولت، تحقیقات خود را به حالت تعلیق درآورده است

- دانشمندان طرحی را برای شکار سیارات سرگردان در کهکشان راه شیری کشف کردهاند

- سرویسهای امنیتی روسیه از افزایش موارد اخذ تابعیت روسیه برای اهداف مجرمانه خبر میدهند

- فرناندو آلونسو، راننده فرمول یک، نام بازیکن رئال مادریدی که به او شباهت دارد را اعلام کرد

- از العلا تا دریای سرخ... عربستان سعودی آغوش خود را به روی ۵۰ میلیون گردشگر باز میکند!

- هند اعلام کرد که در حال بررسی پیامدهای تحریمهای آمریکا علیه روسیه است

- دانشمندان بهترین محصولات کشاورزی را برای زنده ماندن از گرسنگی در طول زمستان هستهای شناسایی کردهاند

- «آناناس نقطه اوج شب بود!» ... عکسهای صلاح از تماشای شکست «افتضاح» لیورپول جنجال گستردهای به پا کرد

- اروپا در حال تجربه یک وضعیت روانپریشی نظامی است| پس از آنکه بلژیک تهدید کرد مسکو را از نقشه جهان محو خواهد کرد، روسیه هشدار داد

- به لطف زومرها مفهوم «شادی مردان» را تغییر کرده است

- دانشمندان هشدار میدهند که نانوپلاستیکها به «اسب تروا» برای فلزات سمی تبدیل شدهاند

- مدودف: اژدر پوسایدون به معنای واقعی کلمه یک سلاح آخرالزمانی است

- رسوایی جنسی اپستین، همسر سابق شاهزاده اندرو را از یک کانال تلویزیونی محبوب کنار گذاشت

- پسکوف: برخی از جمهوریهای شوروی سابق در تلاشند تا ریشههای تاریخی مردم خود را برای اهداف کوتاهمدت پاک کنند.

- رسانهها: مجارستان به رسمیت شناختن حادثه بالن به عنوان یک اقدام جنگ ترکیبی را رد میکند

- مطالعه: پناهندگان در آلمان به طور فزایندهای احساس ناخوشایندی میکنند

- سرقت از موزه لوور: اعترافات ناقص و سرنوشت نامعلوم جواهرات به ارزش ۸۸ میلیون یورو

- امواج غولپیکر زیر آب، راز پیدایش اقیانوس اطلس را برای دانشمندان آشکار کردهاند

- خبرگزاری آکی: شرکت ملونی در مراسم افتتاحیه موزه بزرگ مصر لغو شد

- برزیل قانونی را با هدف تقویت حمایت آنلاین از خردسالان تصویب کرد

- هافپست: دانشمندان BCM راهی برای بهبود نعوظ بدون ویاگرا کشف کردهاند

- دموکراتها ترامپ را به تلاش برای کسب سود شخصی از پروژه تالار رقص کاخ سفید متهم میکنند

- مشخص شد که چین چگونه میتواند ناوهای هواپیمابر آمریکایی را از کار بیندازد

- «او قهرمان جهان نیست، اما من هستم.» مارکو ماتراتزی در مورد مقایسه با ابراهیموویچ

- دانشمندان اعتراف کردهاند که تقریباً هیچ چیز در مورد اعماق اقیانوسهای زمین نمیدانند

- کارشناس: قیمت بیت کوین تا پایان سال میتواند به ۱۳۰ هزار دلار برسد

- آیا شاهزاده اندرو و سارا فرگوسن، شاهزاده بریتانیا، به دلیل رسوایی جنسی اپستین به زندان فرستاده خواهند شد؟

- روسیه از نظر تعداد میلیاردرهای دلاری به چهارمین کشور بزرگ جهان تبدیل شده است

- ایمونوتراپی برای مبارزه با سرطان در مراحل پایانی توسعه یافت

- اوکراین از تعطیلی سفارت خود در کوبا خبر داد

- جروم پاول: تعرفههای جدید آمریکا منجر به افزایش تورم در این کشور میشود

- ترامپ به کره جنوبی اجازه داده است که یک زیردریایی هستهای مدرن در آمریکا بسازد

- دانشمندان راز دیرینهای را در مورد قدرت تخمهای در حال سقوط کشف کردهاند

- «ما غیرممکن نمیخواهیم... ما فقط میخواهیم که فرزندانمان زنده بمانند» اسرائیل در عرض ۱۲ ساعت ۴۶ کودک را در نوار غزه شهید کرد

- یک هیئت نمایندگی کنگره آمریکا عازم مسکو است؛ لونا اعلام کرد که سرپرستی هیئتی را برای دیدار با نمایندگان دومای روسیه بر عهده خواهد داشت

- کره جنوبی ۳۵۰ میلیارد دلار برای کاهش تعرفهها به آمریکا پرداخت میکند

- ماهیگیران یک «شبح درخشان» جدید را در گودال ماریانا کشف کردهاند

- حمله تند هنرمند مشهور آمریکایی به ترامپ

- آلمان وضعیت زیرساختهای انرژی اوکراین را فاجعهبار خوانده است

- میزان مصرف ششلیک در روز اعلام شده است

- سفارت روسیه در مالی توصیه به ترک کشور برای مردم را تکذیب میکند

- آمریکا: معاون رئیس پلیس ایلینوی به جرم قتل یک زن سیاهپوست محکوم شد

- مدودف در مورد سرنوشت بلژیک در جریان آزمایش پوزیدون علیه آن صحبت کرد

- پیشنهاد استفاده از کورکومین را برای مقابله با بوی بد دهان

- فراخوان نزدیک به ۲ میلیون خودرو در آمریکا به دلیل مشکلات ایمنی

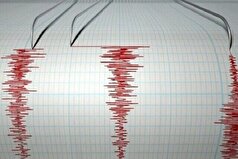

- دو زلزله سواحل آمریکا را لرزاند

- سنی که التهاب در بدن افزایش مییابد، شناسایی شده است

- پس از جنجالهای مربوط به اظهارات لامین جمال، "نگریرا" جرقه رویارویی جدیدی بین بارسلونا و رئال مادرید را میزند!

- پوتین: روسیه ذخایر بینظیری از ماهی و منابع حیوانی دارد

- رسانهها: آمریکا در حال برنامهریزی «پیچیده» برای تغییر قدرت در ونزوئلا است

- یک مصدومیت «دشوار برای درمان» توانایی لامین یامال در زمین را تا ۵۰ درصد محدود کرده است

- ونس: درگیری لفظی با زلنسکی در ماه فوریه «معروفترین» کاری است که انجام دادهام

- پوتین درباره مهمترین وظیفهای که روسیه درگیر آن است صحبت کرد

- افسانه در مورد فواید حمام آب گرم بعد از ورزش از بین رفته است

- وزیر اقتصاد عربستان سعودی انتظارات خود را از اقتصاد این کشور فاش کرد

- آیا ونزوئلا تراژدی عراق را تکرار خواهد کرد؟ کارشناسان نسبت به مداخله فاجعهبار آمریکا هشدار میدهند

- دومای دولتی معتقد است که ترامپ سعی خواهد کرد حمایت شی جین پینگ را در مورد اوکراین جلب کند

- دانشمندان منشأ سویه طاعون سیاه را کشف کردند

- فایننشال تایمز: آلمان قراردادی ۹۰۰ میلیون یورویی برای خرید پهپادهای انتحاری امضا کرد

- لیتوانی تصمیم گرفته است که مرز اتومبیل خود با بلاروس را موقتاً ببندد

- یک پزشک توضیح داد که چگونه میتوان افزایش ناگهانی قند خون را "کنترل" کرد

- مصر: هزینه اولین قطار بدون راننده آفریقا چقدر است؟

- دیدار مدیرعامل اپل با دونالد ترامپ در توکیو

- دو وزیر سابق الجزایر به اتهام فساد مالی بازداشت شدند

- ورونتسوف: ایالات متحده با کارشکنی اروپاییها در حل و فصل مناقشه اوکراین مواجه است

- کرملین: اطلاعات مربوط به قصد فرانسه برای اعزام نیرو به اوکراین نگران کننده است

- یک ویروس باستانی در یخهای گرینلند زنده شده است

- «بروید به جهنم!» ... وینیسیوس جونیور و ژابی آلونسو به نقطه بیبازگشت میرسند

- تصمیم بزرگ رئال مادرید در مورد وینیسیوس جونیور

- موضع رئال مادرید در مورد آینده وینیسیوس مشخص شد

- آرن اسلات دلایل شکستهای اخیر لیورپول را نام برده است

- رادیموف در مورد احتمال پیوستن اسپالتی به یوونتوس گفت: «به همه کسانی که زیر نظر او بازی کردهاند حسادت میکنم.»

- ایلیمان ندای یک پیشنهاد ۵۵ میلیون یورویی را برانگیخت

- یه سطل آب سرد برای پدری!

- یک جایگزین غافلگیرکننده برای جناح چپ بارسلونا

- سرمربی کریستال پالاس درباره سومین پیروزی تیمش مقابل لیورپول در این فصل اظهار نظر کرد

- مسی توضیح داد که اینتر میامی برای قهرمانی در جام MLS چه کاری باید انجام دهد

- آرن اسلات: لیورپول حتی با بازیکنان اصلیاش هم بردهای زیادی مقابل کریستال پالاس نداشته است

- میلان گل دیگری را برای خط حمله خود به ثمر رساند

- لئو مسی اذعان کرد که بازنشستگیاش «به زودی فرا خواهد رسید»

- دوشان ولاهوویچ آیندهاش را در هالهای از ابهام قرار داده است

- میکل آرتتا در مورد پیروزی آرسنال مقابل برایتون اظهار نظر کرد

- هری کین در مورد پیروزی بایرن مقابل کلن: ما باید این روحیه را حفظ کنیم

- کاماوینگا، هافبک رئال مادرید، در مورد نقش خود در ال کلاسیکو مقابل بارسلونا کنایهای زد

- لوچانو اسپالتی اجازه میدهد خودش را دوست داشته باشند

- اتا ایونگ میخواهد در ژانویه تیم جدیدی انتخاب کند

- رویای ممنوعه بارسلونا برای جذب یک مهاجم ۱۰۰ میلیون یورویی

- دییونگ: اگر کارواخال میخواست با یامال صحبت کند، میتوانست این کار را خصوصی انجام دهد

- رافینیا در مورد صحبتهای یامال پیش از ال کلاسیکو: حرفهای او به رئال مادرید انگیزه داد

- میلان تمایلی به پیوستن پولیسیچ به تیم ملی آمریکا برای مسابقات ماه نوامبر ندارد

- سویا به دنبال ستاره جام جهانی زیر ۲۰ سال است!

- جانشین مارک گوئهی در منچسترسیتی است

- رئال مادرید از یوفا شکایت کرد و خواستار ۴.۵ میلیارد یورو غرامت شد!

- نویل درباره خط دفاعی لیورپول: آنها به وضوح مشکلات دفاعی دارند

- کارواخال و یامال یکدیگر را در شبکههای اجتماعی آنفالو کردند

- بروسیا دورتموند به دنبال یک استعداد آرژانتینی است

- رقابت شدید برای جذب بازیکن احتمالی منچسترسیتی

- آندرهآ برتا سه عملیات در آرسنال را تشریح کرد

- توتی درباره اسپالتی: او خرید بزرگی برای یوونتوس خواهد بود

- دفتر دادستانی، باشگاه بارسلونا را به دادگاه احضار کرده و درخواست پرداختهای اولیه در «پرونده نگریرا» را مطرح کرده است

- نونو مندس: من از نظر دفاعی خیلی قوی نبودم، اما انریکه خیلی به من کمک کرد

- لحظه اوج برای ترنت الکساندر-آرنولد

- ژائو نوس شور و اشتیاق را در انگلیس برمیانگیزد

- کانر گالاگر، تحت تعقیب

- مارکو ماتراتزی درباره شبیهسازی بوسکتس در بازی بارسلونا-اینتر در سال ۲۰۱۰ صحبت کرد

- پالمیراس پیشنهاد ۱۵ میلیون یورویی + ۵ میلیون یورویی زنیت برای هافبک ۲۱ ساله را رد کرد

- آرتتا در مورد دروازهبانهای آرسنال گفت: «ما دروازهبان شماره یک نداریم.»

- بارسلونا پس از جنجال ال کلاسیکو، برخی از حضورهای عمومی یامال را لغو کرد

- میکل آرتتا، سرمربی آرسنال، در مورد عملکرد تیمش در ضربات ایستگاهی صحبت کرد

- وین رونی از ویرژیل فن دایک و محمد صلاح انتقاد کرد

- کادنا سر: رئال مادرید وینیسیوس را به خاطر واکنشش به تعویض شدن در ال کلاسیکو تنبیه نخواهد کرد

- مارکو ماتراتزی، بازیکن سابق اینترمیلان، از مربیای که از او بیشترین نفرت را داشته، نام برده است

- ونگر: بارسلونا در ال کلاسیکو اراده کافی نداشت

- آندونی ایرائولا برای آینده برنامهای دارد

- گزینه ۵۰ میلیون یورویی برای جایگزینی برونو فرناندز

- بروسیا دورتموند ستاره شالکه ۰۴ را وسوسه میکند

- ژائو نوس و فابیان رویز برای اولین بار از زمان مصدومیتشان با تیم کامل تمرین کردند

- گواردیولا درباره وضعیت سلامتی هالند اظهار نظر کرد

- گابریل خسوس آیندهاش را تغییر میدهد

- منچستریونایتد پس از دو خروج قطعی، در را محکم به هم کوبید

- کارلوس رومرو ۴۵ میلیون یورو قیمت دارد!

- تاتنهام هاتسپر به میسون گرینوود علاقه دارد

- اوبامیانگ درباره پاوارد: ما در یک مسیر هستیم

- لوئیس انریکه در مورد رقابت بین شوالیه و سافونوف صحبت کرد

- شکستی برای پابلو باریوس

- اتلتیکو مادرید در حال بررسی جذب مارک پوبیل است

- وضعیت توسط هیونگ مین سون روشن شده است

- بارسلونا معتقد است که رئال مادرید ممکن است یک کمپین بدنام علیه یامال ترتیب داده باشد

- مارکو ماتراتزی، بازیکن سابق اینترمیلان، دلیل پایان دوران مربیگریاش را توضیح داد

- امباپه فکر نمیکند اختلاف پنج امتیازی رئال مادرید با بارسلونا در لالیگا قابل توجه باشد

- پرونده ویلیان پاچو مختومه شد

- مارک آندره تراشتگن، در کانون توجه

- مانور یوونتوس تورین روی دو مربی

- گاسپار، رئیس سابق بارسلونا، به شدت از کارواخال انتقاد کرد

- گواردیولا در مورد دروازهبان ترافورد گفت: «او دیر یا زود بهترین بازیکن انگلیس خواهد شد.»

- پوکوگنولی در مورد پوگبا: پل در آستانه بازگشت به ترکیب موناکو است

- درخواست هانسی فلیک از باشگاه بارسلونا

- آرامش پرتنش توسط رودری هرناندز

- واقعیت تلخ فرانکو مستانتونو در رئال مادرید

- تونی کروس از مردم خواست که وینیسیوس را که از تعویض شدن در ال کلاسیکو عصبانی بود، قضاوت نکنند

- انریکه در مورد برالدو: او تجربه زیادی دارد و شخصیت با اعتماد به نفسی است

- پیاسجی به دنبال جذب یک جواهر از بارسلونا است

- چلسی و تاتنهام در بازار نقل و انتقالات به یکدیگر علاقهمند هستند

- آرزوی ۳۰ میلیون یورویی برای وستهام

- رومانو جزئیاتی از تمدید قرارداد آرسنال با یکی از ستارههای این تیم را فاش کرد

- دی مارتزیو: لوکاکو این هفته از مصدومیت برمیگردد

- وینیسیوس از مدیر برنامههایش خواسته است که برایش یک باشگاه جدید پیدا کند| این بازیکن برزیلی میخواهد بداند که برنامههای آلونسو چیست

- پس از شکست در ال کلاسیکو، بارسلونا ضربه دردناک دیگری را متحمل میشود