- ارتباط با ما

- |

- درباره ما

- |

- نظرسنجی

- |

- اشتراک خبری

- |

- نگارنامه

«چتجیپیتی» پاسخهای غلط به پرسشهای دارویی میدهد

به گزارش مجله خبری نگار از «فاکس بیزنس»، چتجیپیتی که از هوش مصنوعی مولد برای شکل دادن به پاسخهایی به پرسشهای کاربران با استفاده از دادههای موجود در اینترنت استفاده میکند، از سوی محققان انجمن داروسازان آمریکا به چالش گرفته شد.

این محققان پرسشهای واقعی از دانشکده داروسازی دانشگاه «لانگ آیلند» چتجیپیتی را به چالش کشیدند. این مطالعه روز سه شنبه این هفته در جلسه سالانه انجمن داروسازان آمریکا ارائه شد.

آنها پس از بررسیهای کارشناسی ۳۹ پرسش را برای پاسخ دادن در اختیار هوش مصنوعی چتجیپیتی قرار دادند. این مطالعه نشان داد که چتجیپیتی تنها موفق شد برای ۱۰ مورد از این پرسشها پاسخ قانعکننده ارائه دهد و در مورد ۲۹ پرسش دیگر، پاسخهای ارائه شده نامرتبط، نادرست یا ناکامل بود.

محققان همچنین از چتجیپیتی خواستند که رفرنس یا ارجاعات لازم را درباره پاسخهای خود ارائه دهد که این سیستم هوش مصنوعی تنها موفق به ارائه ارجاعات برای هشت پاسخ شد.

«سارا گراسمن» از شرکت «فارمدی» و مولف اصلی این کار تحقیقی گفت: افراد حرفهای حوزه بهداشت و درمان و بیماران باید در زمینه استفاده از چتجیپیتی به عنوان یک منبع معتبر برای اطلاعات مرتبط با دارو و درمان محتاط باشند.

وی افزود: هر کسی که از چتجیپیتی برای کسب اطلاعات مرتبط با دارو و درمان استفاده میکند، باید با استفاده از منابع مورد اعتماد این اطلاعات را راستیآزمایی و تایید کند.

در یک مورد، محققان از «چتجیپیتی» سوال کردند که آیا خطر تداخل دارویی بین داروی ضدویروسی Paxlovid کووید-۱۹ و «وراپامیل» داروی کاهش دهنده فشار خون وجود دارد یا نه و این ربات در گفتوگوی (چتبات) هوش مصنوعی گفت که هیچ موردی از تداخل گزارش نشده است.

به گفته گروسمان، این در حالی است که در واقعیت این داروها ظرفیت تداخل با یکدیگر را دارند و استفاده ترکیبی از آنها ممکن است منجر به کاهش بیش از حد فشار خون شود. بدون آگاهی از این تداخل، یک بیمار ممکن است به اثرات جانبی ناخواسته و قابل پیشگیری دچار شود.

یک سخنگوی شرکت اوپنایآی سازنده چتجیپیتی در واکنش به این موضوع گفته است که «مدلهای اوپنایآی» برای ارائه اطلاعات پزشکی تنظیم نشدهاند و کسی نباید از مدلهای ما برای ارائه خدمات تشخیصی یا درمانی در شرایط پزشکی جدی استفاده کند.

- لطفا از نوشتن با حروف لاتین (فینگلیش) خودداری نمایید.

- از ارسال دیدگاه های نا مرتبط با متن خبر، تکرار نظر دیگران، توهین به سایر کاربران و ارسال متن های طولانی خودداری نمایید.

- لطفا نظرات بدون بی احترامی، افترا و توهین به مسئولان، اقلیت ها، قومیت ها و ... باشد و به طور کلی مغایرتی با اصول اخلاقی و قوانین کشور نداشته باشد.

- در غیر این صورت، «نگارمگ » مطلب مورد نظر را رد یا بنا به تشخیص خود با ممیزی منتشر خواهد کرد.

- آخرین اخبار

- محبوب

- برچسب های داغ

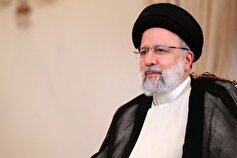

- آخرین استوری صفحه رئیسجمهور شهید

- صوت| از او که پر زدنش، تولّدی دگر است

- فیلم| خاطره وزیر آموزش و پرورش از توجه ویژه شهید رییسی به دانشآموزان

- فیلم: تکتیراندازان قسام ۳ نظامی اسرائیلی از جمله یک افسر ارتش این رژیم را در منطقه بیت حانون (شمال غزه) از پا درآوردهاند

- خاطرات روزهای دلتنگی، از ۱۴خرداد ۶۸ تا ۳۱ اردیبهشت ۱۴۰۳

- رفاقت تا شهادت| انگشترهایی که در قاب تاریخ ماندگار شدند

- روزی که لرستانیها شاخ صدام را شکستند

- رئیسالساداتی که با شهادتش، وحدت را فریاد زد

- فیلم| اظهارات وزیر بهداشت در خصوص افتتاح بیمارستان اراک توسط «شهید جمهور»

- سازنده یکی از امیدهای نخل طلا به بدرفتاری با عوامل فیلم و مصرف ماریجوانا متهم شد

- نوشتههایی که در سینما و تلویزیون به حرکت درآمدند

- فیلمهای خارجی دیگر بیصاحب نیستند + فیلم

- سوگواری سربازانی که شهید رئیسی، شب یلدا مهمانشان بود + فیلم

- فیلم| ناگفتههای شهید امیرعبداللهیان از دوران خدمت در دستگاه دیپلماسی

- فیلم| شهید جمهور: سفرم به استانها یک سفر تشریفاتی نیست

- رونمایی از سرود "سید ابراهیم" در گیلان + فیلم

- خوشلباسترین بازیکن فوتبال جهان از دید ستاره خوشتیپ اولدترافورد و برنابئو؟! + عکس

- تنفر اسطوره اولدترافور از VAR!

- «نازی و روانپزشک» در «نورمبرگ» میآیند

- پرکاری ستاره نوظهور هالیوود؛ بازی در نقش «راکیِ زن»، جا پای جین فوندا

- جدیدترین توافق درباره چگونگی ثبت موجودی طلافروشان در سامانه تجارت

- دلایل جهش بیت کوین به قله تاریخی

- بازار طلا، سکه نیست

- بازار طلا در پاییز سکه شد

- افت شدید انتظارات تورمی در بازار ارز

- طراحی نقشه راه جدید بازار ارز و طلای کشور

- حمله سهجانبه به بازار ارز

- فرمان مدیریت ارزی چگونه به میرداماد بازگشت

- نشانههای تداوم ثبات در بازار ارز

- آیا کرونا بازگشته است؟ سوغات سفرهای تابستانی سرماخوردگی، کرونا یا آنفلوانزا؟

- پاندمی هنوز تمام نشده، در دوره آتشبس با کرونا هستیم

- نگرانیها درباره شیوع سویه اریس کرونا

- دوز یادآور واکنش کرونا بهروزرسانی شود

- کرونا دلیجان را قرمز کرد

- اوجگیری مجدد کرونا در زمستان؟

- ژن ضد ویروسی در بدن انسان وجود دارد؟

- آمار جدید مبتلایان و فوتیهای کرونا در شبانهروز گذشته

- چند درصد دانشآموزان واکسن کرونا تزریق کردهاند؟

- برای کاهش شدت بیماری کرونا بینی خود را با آب نمک شستشو دهید

- توصیههای جدید CDC برای مقابله با ویروس کرونا

- امکان مواجهه با پاندمیهای جدید وجود دارد

- از ۱۱ سویه کدام مسریتر است؟

- افزایش آمار روزانه مبتلایان کرونا در هند

- شناسایی ۱۷۹ بیمار جدید کووید۱۹ در کشور

- تزریق بیش از ۲۰ هزار دز واکسن در شبانه روز گذشته

- احتمال شکلگیری پیک کرونا در سه ماه آینده/فقط ۱۶ درصد از دانشآموزان ۵ تا ۱۱ سال واکسینه شدن

- آخرین رنگبندی کرونایی شهرهای کشور/ افزایش تعداد شهرهای آبی

- هشدار به افرادی که ۳ دوز واکسن نزده اند: محرومیت از خدمات!

- کرونا مانند بیماری آنفلوانزا خواهد شد/ واکسیناسیون کرونا در سالهای آینده داوطلبانه میشود

- سایه تامین مالی دولت بر سر بورس سنگینی میکند

- کاهش بی سابقه حجم معاملات سهام در بورسهای جهانی

- رشد شاخصهای بورس با کمک بانکیها و اعلام نرخ تسعیر ارز

- حمله به سفیر روسیه در لهستان

- معرفی سری گوشیهای Redmi K ۵۰ قبل از رونمایی رسمی

- غفوری: فکر کردن به قهرمانی از الان، سادهلوحانه است

- کاهش ۱۰ درصدی تولید هوندا در دو کارخانه

- سومین نشست دستمزد، باز هم بدون نتیجه

- لغو بلیت فروشی عمومی المپیک زمستانی چین

- گرامیداشت قربانیان هواپیمای اوکراینی در دانشگاه تورنتو

- ادامه چانهزنی چهارگانه در وین

- صرفهجویی ۱.۶ میلیارد دلاری کمیته برگزاری المپیک و پارالمپیک توکیو

- محبوبترین رشته المپیک توکیو مشخص شد

- اعلام هزینه میزبانی توکیو از المپیک و پارالمپیک ۲۰۲۰،

- آذرتاج: هیات اقتصادی جمهوری آذربایجان به ایران میرود

- بررسی عملکرد ایران در المپیک؛ جایگاه چهارمی در آسیا

- پایان وضعیت اضطراری در کشور میزبان المپیک ۲۰۲۰

- ماجرای دوچرخهی المپیک به وزیر کشیده شد/ بهتاج: امیدوارم ختم به خیر شود

- تمجید رییس کمیته پارالمپیک آسیا از نتایج ورزشکاران ایران در توکیو

- تابع: پیشبینیهای ما در خصوص مدالهای طلای پارالمپیک محقق شد

- لیموچی: عملکرد زنان ورزشکار ایران در پارالمپیک درخشان بود

- رضایی: کاروان ایران نمره قبولی خود را در پارالمپیک توکیو کسب کرد

- رژه پوشش اسلامی پیش چشم جهانیان

- صالحی امیری: آوردگاه توکیو میدان درخشش انسانهای مظلوم، ولی مقتدر بود

- برترین فرنگیکاران جهان معرفی شدند/ «محمدرضا گرایی» در صدر ایستاد

- چین قهرمان بازیهای پارالمپیک شد/ ایران در رده سیزدهم قرار گرفت

- پارالمپیک ۲۰۲۰| جوانمردی پرچمدار کاروان ایران در مراسم اختتامیه

- ساره جوانمردی پرچمدار ایران در اختتامیه پارالمپیک شد

- پیروزی رایحه شهاب در جدول شانس مجدد رقابتهای پاراتکواندو

- «عزیزی اقدم» به نیمه نهایی رقابتهای پاراتکواندو رسید

- دانشمندان در ۱۵ دقیقه الماس پرورش دادند

- در فصل گذار پیاسجی، انریکه چگونه بود؟

- نشست تخصصی فلسطین| رسانههای غربی تصویری غیر واقعی از غزه نشان میدهند

- رسانههای مصری: سد قیز قلعهسی از دستاوردهای مهم دولت ایران است

- اردیبهشت، با شب یلدایی سخت به پایان رسید!

- رفتار آیتالله رئیسی با دانشگاهیان؛ حضور و تریبونی که رکورددار شد!

- انقلاب کوتاه سید در اقتصاد

- چرا باید از انتشار تصاویر و اطلاعات کودکان در فضای مجازی خودداری کرد؟

- ترانزیت کالای روسیه از ایران به عربستان؛ اینچهبرون، کریدوری امن برای افزایش صادرات غیرنفتی

- خیریه Headway خطاب به پپ: چرا ادرسون را سریعتر تعویض نکردی؟!

- فیفا: در مورد جام باشگاههای جهان ما براساس نظرخواهیها به این نتیجه رسیدیم و عقبنشینی نخواهیم کرد

- مخالفت ترامپ با حق سقط جنین در آمریکا

- طرح ممنوعیت دریافت هدایای خارجی از سوی روسای جمهور آمریکا

- لیگهایی که دیگر به کشورها تعلق ندارند! لینهکر: "نه، نه، نه"

- ۱۰ سال از زوج طلایی کروس-مودریچ گذشت + عکس

- تکرار حس شهادت سردار با شهادت سیدالشهدای خدمت

- تحلیل مهندس آلمانی از اعتراضات مونیخیها به سوت جنجالی نیمه نهایی UCL

- ایستاده آسمان به انتظارِ تو؛ کوهِ «امید» پرواز کرد

- ساری: برلوسکونی باعث شدم من تیم موفق پارتنوپی را هدایت کنم

- ساوتگیت: اشتباهات بچگانه باعث برابر ما مقابل فرانسه شد

- فیلم| واکنش بانوی قهرمان جهان مازندرانی در پی شهادت رئیسجمهور و همراهان

- ساوتگیت: همان انتظاراتی که در بایرن است ما در انگلیس با آن مواجه میشویم

- جیسون استاتهام عصیان میکند

- پای بوتاکس تقلبی به نمایشگاه ایران هلث باز شد!

- واکنش گوتی به اینکه الگوی ستاره گرجی ناپولی است

- «رئیسی مرسی»

- آلن شیرر بحثهای بنت و پسرش را قضاوت کرد!

- سازنده «کودا» از رمان پرفروش «فردا، و فردا و فردا» اقتباس میکند

- کشف خودروی قاچاق ۵ میلیارد تومانی در یک پارکینگ!

- BBC هم به مقصد احتمالی ستاره پیاسجی پرداخت

- ویلم دفو و ساندرا هولر به دنیای شاعرانه کنت جونز پیوستند

- ستاره سابق چلسی همچنان به رئالیها ضرر میرساند!

- روزهای شلوغ اندرو هیگ؛ از ساخت فیلمی درباره نورمن میلر تا روایت داوینچی با دیکاپریو

- وعدههای انیمیشنسازی ایران و مچ انداختن با غولهای جهان

- تقدیر از خالق «آپاراتچی» با بیرق و عطر چای رضوی

- رئیسی که «پایِ کار فرهنگ» ماند+ فیلم

- اندرو گارفیلد و جولیا رابرتز به فیلم جدید کارگردان «چالشگران» پیوستند

- افشای توطئه آمریکایی-اسرائیلی-عربی برای جدا کردن غزه از خاک فلسطین

- خاطره حجتالاسلام مؤمنی از ادب رئیس جمهور نسبت به مجلس اهل بیت (ع)

- اخبار داغ

- ورزشی

- پربیننده

- پربحث

- افزایش یک درصدی تورم ماهانه تولید گاوداری صنعتی در فروردین ۱۴۰۳

- امروز؛ آخرین مهلت بارگذاری مدارک پذیرفتهشدگان مرحله اول آزمون آموزگاری

- اتهام انگلیس درباره «کمک مرگبار» چین به روسیه

- تکاپوی نتانیاهو برای جلوگیری از به رسمیت شناخته شدن کشور فلسطین

- مجارستان: اوضاع جدید در خاورمیانه تهدیدی برای اروپاست

- اردن: اشغالگری اسرائیل پایان نیابد صلح در منطقه محقق نمیشود

- کاخسفید: دولت فلسطین با برسمیت شناختهشدن یکجانبه محقق نمیشود

- انگلیس ۱۴ تیرماه انتخابات عمومی برگزار میکند

- وزیر خارجه ایرلند: کشورهای اروپایی دیگر کشور مستقل فلسطینی را برسمیت میشناسند

- سالیوان: راهبرد ما شکست حماس و حمایت از غیرنظامیان و ادغام کردن اسرائیل در منطقه است

- اردوغان: تا زمانی که غرب پشت نتانیاهو است، کشتارها در فلسطین ادامه خواهد داشت

- ارمنستان: اختلافات با باکو بر سر تعیین حدود مرزی کماکان پابرجاست

- اتهامزنی به مصر درباره دستکاری در پیشنهاد آتشبس غزه

- رفتنت لرزهای سختتر از زلزله خوی در دلهایمان انداخت آقا سید

- امیرعبداللهیان مدافع مقاومت و مدیر نخبه سیاست خارجی بود

- تاکید «شهید جمهور» به ورزشکاران برای تلاش برای اهتزاز درآوردن پرچم مقدس ایران در جهان

- بهیاد روزی که «شهید جمهور» بعد از ۱۲ سال آب را به شرق کرمان آورد

- آیتالله رئیسی بیاعتنا به تهمتها به فکر خدمت بود

- ریزش سنگ در ارتفاعات کرج-چالوس پیشبینی میشود

- رونقبخشی به مساجد کمرونق داراب؛ قراری که این بار با شهید جمهور طی شد

- خاطرات دیپلمات شهید که به توصیه سردار سلیمانی منتشر شد

- بارش شدید در روستاهای کاشان سیلابی شد

- حجاج تمتع با زمانبندی مناسب به فرودگاه بروند؛ انجام پروازها طبق برنامه

- شناسایی ۸۰ تارنمای مجرمانه پس از رصد محتواهای متأثر از حادثه سقوط بالگرد

- دیپلمات فرانسوی در شورای امنیت: با حمله اسرائیل به رفح مخالفیم

- چین بیش از ۵۳ میلیارد دلار ذخایر دلاری اش را فروخت

- تلاش برای بازداشت نتانیاهو، آلمان را نگران کرد

- امام جمعه اهلسنت قشم: شهادت در متن خدمت اوج شرافت است

- گفتمان رئیسجمهور شهید؛ مهمترین شاخصه انتخاب رئیس جمهور آینده

- ورشکستگی دولت دستنشانده جنوب یمن در سایه ثبات اقتصادی صنعاء

- آیت الله رئیسی پشتوانه مهمی برای جامعه کار و تولید بود

- امیر رودباری: کسانی که در راه خدا جان میدهند انتخاب شده او هستند

- ویژگی بارز رئیس جمهور شهید، ذوب شدن در ولایت بود

- گالانت برآشفته شد؛ صلاحیت دادگاه لاهه را برسمیت نمیشناسیم

- پل شریدر فیلمی درباره فرانک سیناترا میسازد

- نگاه رئیس جمهور شهید گفتمان مدیریت و خدمت را در کشور تغییر داد

- شهید آیت الله رییسی دارای نجابت سیاسی و مدیریتی بود

- کوچکترین نقطه سیاهی در کارنامه شهید رئیسی دیده نمیشود

- کاهش ۴۴.۷ درصد تورم نقطه به نقطه تولید مرغداریها در فروردین

- افزایش قیمت جهانی مس هم بر بورس تاثیر نداشت

- ردای ریاست جمهوری هم نتوانست «شهید رئیسی» را تغییر دهد

- محکومیت توسل به اقدامات تروریستی توسط بازیگران فرامنطقهای در قلمرو سازمان شانگهای

- مذاکرات فرانسه با امارات برای همکاریهای هستهای

- قیمت بیتکوین برای نخستین بار در ۵ هفته گذشته به بالای ۷۱ هزار دلار رسید

- سروری: رئیسی و رجایی خود را بدهکار انقلاب میدانستند نه طلبکار

- قول معاون وزیر بهداشت در رابطه با تأکیدات رئیسجمهور شهید

- دوحه: برغم رکود در مذاکرات، به میانجیگری برای آتشبس غزه ادامه میدهیم

- فعالان ضد جنگ جلسه استماع بلینکن در کنگره را مختل کردند

- یک کشته و ۳۰ مجروح در سانحه «بوئینک-۷۷۷» خطوط هوایی سنگاپور

- منبع مصری: هماهنگی قاهره-تلآویو درباره عملیات اسرائیل در رفح، کذب محض است

- کپا فرصت خداحافظی رئالیها را پیدا میکند؟

- برنابئو: فعلا درباره جزئیات قرارداد اسطوره چلسی اظهاراتی نداریم

- پدر کاپیتان کهکشانیها: پسرم پشت سر هم جام بالا میبرد چرا لاروخا او را به یورو نمیبرند

- بولی: ما در حال سرمایهگذاری هستیم هواداران صبر پیشه کنند

- پدیده دفاعی ۱۸ ساله تیم فرانسوی فعلا در لیست خرید رئال نیست

- تنهاخ تنها ۱۰ روز فرصت دارد خودش را به راتکلیف اثبات کند

- رائوم، خودت را برای پرواز ماجراجویانه دیگر آماده کن!

- مهاجم برزیل طرد شده بلوگرانا محبوب افعیها شد

- این بازیکن برزیلی بلوگرانا جایگزین طارمی در پورتو میشود

- تیم صعود کرده به سطح اول فوتبال عربستان سادیو مانه را میخواهد

- ماجراجویی آقای خاص به یک مقصد غیرمنتظره ختم میشود؟

- بلوگرانا و مونیخ شرایط فرناندز شیاطین را پیگیر هستند

- النصر عربستان قصد ملحق کردن کاسمیرو به رونالدو را دارد

- فرمول بکام به سندیگو رسید؟!

- سن سیرو قصد انتقال رویال را از لندن دارد

- تن هاخ: اظهارات رونی درست نیست، بازیکنان من مشاق بازی کردن هستند

- فرانسویها سرزمین اژدها را برای سوپر جام ۲۰۲۴ انتخاب کردند

- پیاسجی هم مانع حضور ستاره فرانسوی خود در المپیک شد

- واکنش مهاجم فرانسوی کاوازاکی به بازی نکردن کنار نیمار

- توضیحات دنیل لوی درباره خشم آنژ از هواداران اسپرز

- غولهای ایتالیایی خواهان هافبک اروگوئهای پیاسجی

- ستاره فرانسوی کهکشانیها به ومبلی میرسد

- عربستانیها دست روی سنگربان رمزهای مرسیساید گذاشتند

- زانیولو: دوست دارم روزی برای ایتالیا در یورو بازی کنم

- آنچلوتی: در حال حاضر فرمول یک برایم خستهکننده شده است

- راموس: من سن دیگو را تجربه نکردهام

- ستاره تیم آلونسو توسط یک خواننده به مانشافت دعوت شد + عکس

- نیشی که توخل خورده است بسیار عمیق است!

- دانیلو: بوفون برای کسب این جام به من کمک زیادی کرد

- کونته از سن سیرو به سمت پارتنوپی چرخش پیدا کرد

- استانیشیچ مونیخ را دوست ندارد و میخواهد با آلونسو بماند

- هواداران اسپرز از باخت تیمشان مقابل سیتیزنها شاد شدند

- سنگربان سوم قرمزهای مرسیساید به کشورش برمیگردد

- دیاز علاقهمند به حضور در کاتالان شد

- افعیها به مدافع آرژانتینی شیاطین سرخ علاقهمند شدند

- آبیهای لندن بسته پیشنهادی بهتری برای ویلیان آماده میکنند

- فابرگاس با کومو میخواهد فوتبال ایتالیا را شگفتزده کند

- تن هاخ میماند؟ فعلا به فینال حذفی فکر میکنم

- میلیتائو از بین دو همتیمی خود کدام را شایسته توپ طلا ۲۰۲۴ میداند؟

- کوپا ایتالیا تخصص ویژه الگری شد + آمار

- بانوی پیر در کوپا ایتالیا دستنیافتنی شد

- مدیران سن سیرو اعتقاد ویژهای به فونسکا دارند

- اعتراف ستاره بانوی پیر به شایستگی افعیها به فتح اسکودتو

- ببرهای جنوب با گاسپرینی یا کونته زندگی خواهند کرد؟

- بلوگرانا بدون ستاره لهستانی چه رتبهای کسب میکرد؟

- فرناندز: اگر من جزئی از برنامههای باشگاه باشم، میمانم

- مهاجم قرضی رم پایان فصل با ده روسی خداحافظی میکند

- اسپانیا برای من بسیار جذابتر است؛ سرمربی توپچیها روزی بر خواهد گشت

- رونی: هر چه سریعتر اولدترافورد را ترک کن!

- مرغان دریایی یک سال دیگر کهنهکار ۳۸ ساله را نگه میدارند