- ارتباط با ما

- |

- درباره ما

- |

- نظرسنجی

- |

- اشتراک خبری

- |

- نگارنامه

بررسی عملکرد برخی از محبوبترین ابزارهای هوش مصنوعی!

به گزارش مجله خبری نگار/شفقنا، این محققان دریافتند که وقتی این ابزارها نقش فردی را بازی میکردند که قصد خودکشی دارد، نهتنها کمککننده نبودند، بلکه حتی متوجه نشدند که دارند به آن فرد در برنامهریزی برای مرگ خودش کمک میکنند.

نیکلاس هِیبر، دانشیار دانشکده تحصیلات تکمیلی آموزش دانشگاه استنفورد و نویسنده ارشد این مطالعه، میگوید: [سیستمهای هوش مصنوعی]در حال حاضر به عنوان همراه، شریک فکری، محرم اسرار، مربی و درمانگر مورد استفاده قرار میگیرند. این کاربردها محدود یا حاشیهای نیستند – این اتفاق در مقیاس وسیع در حال رخ دادن است.

هوش مصنوعی بهطور فزایندهای در زندگی مردم ریشه دوانده و در تحقیقات علمی در حوزههایی به گستردگی سرطان و تغییرات اقلیمی به کار گرفته میشود. همچنین برخی بحثها مطرح است که هوش مصنوعی میتواند باعث پایان بشریت شود.

با ادامه گسترش استفاده از این فناوری در کاربردهای مختلف، یک پرسش اساسی باقی میماند: این فناوری چگونه بر ذهن انسان تأثیر خواهد گذاشت؟ تعامل منظم مردم با هوش مصنوعی پدیدهای بسیار جدید است و هنوز زمان کافی برای مطالعه جامع اثرات روانشناختی آن وجود نداشته است. با این حال، متخصصان روانشناسی نگرانیهای زیادی درباره تأثیرات احتمالی آن دارند.

یکی از موارد نگرانکننده این مسئله را میتوان در شبکه اجتماعی محبوب Reddit مشاهده کرد. به گزارش وبسایت ۴۰۴ Media، برخی از کاربران اخیراً از یک زیرمجموعه (سابردیت) متمرکز بر هوش مصنوعی منع شدهاند، زیرا به این باور رسیدهاند که هوش مصنوعی موجودی شبیه خداست یا اینکه خودشان به واسطه استفاده از آن به موجوداتی خداگونه تبدیل شدهاند.

یوهانس آیششتدت، دانشیار روانشناسی در دانشگاه استنفورد میگوید: این شبیه فردی است که دچار اختلالات عملکرد شناختی یا گرایشهای توهمی مرتبط با شیدایی یا اسکیزوفرنی است و با مدلهای زبانی بزرگ (LLMs) تعامل دارد. در اسکیزوفرنی، افراد ممکن است اظهارات نامعقولی درباره جهان داشته باشند، و این مدلهای زبانی بزرگ بیش از حد چاپلوس و تأییدکننده هستند. در نتیجه، نوعی تعامل تأییدی بین اختلال روانی و این مدلهای زبانی شکل میگیرد.

به دلیل اینکه توسعهدهندگان این ابزارهای هوش مصنوعی میخواهند کاربران از استفاده از آنها لذت ببرند و به استفاده ادامه دهند، این ابزارها بهگونهای برنامهریزی شدهاند که معمولاً با کاربر موافقت کنند. هرچند ممکن است این ابزارها برخی اشتباهات واقعی کاربر را اصلاح کنند، ولی عمدتاً سعی میکنند دوستانه و تأییدگر ظاهر شوند. این موضوع میتواند مشکلساز شود، مخصوصاً اگر فرد کاربر در حال افول روانی یا گرفتار شدن در چرخه فکری ناسالمی باشد.

ریگان گورانگ، روانشناس اجتماعی در دانشگاه ایالتی اورگان میگوید: این میتواند افکار نادرست یا غیرواقعی را تقویت کند. مشکل اینجاست که این مدلهای زبانی بزرگ که صحبت انسان را تقلید میکنند، حالت تقویتی دارند. آنها به فرد چیزی را میدهند که برنامه فکر میکند باید بهدنبال حرف قبلی بیاید. اینجاست که مشکل ایجاد میشود.

همانند شبکههای اجتماعی، هوش مصنوعی نیز ممکن است شرایط را برای افرادی که از اختلالات روانی رایجی مانند اضطراب یا افسردگی رنج میبرند، وخیمتر کند. این اثرات احتمالاً در آینده و با ادغام بیشتر هوش مصنوعی در جنبههای مختلف زندگی، بیشتر آشکار خواهند شد.

استیون آگیلار، دانشیار آموزش در دانشگاه کالیفرنیای جنوبی، میگوید: اگر فردی با نگرانیهای مربوط به سلامت روان وارد یک تعامل با هوش مصنوعی شود، ممکن است این نگرانیها نهتنها کاهش نیابند، بلکه تشدید هم شوند.

یکی دیگر از دغدغهها این است که هوش مصنوعی چگونه میتواند بر یادگیری یا حافظه تأثیر بگذارد. دانشآموزی که تمام مقالات درسیاش را با کمک هوش مصنوعی مینویسد، قطعاً به اندازه کسی که خودش آنها را مینویسد، یاد نخواهد گرفت. حتی استفاده سبک از هوش مصنوعی نیز ممکن است باعث کاهش میزان حفظ اطلاعات شود، و استفاده روزانه از آن میتواند سطح آگاهی افراد نسبت به کارهایی که در هر لحظه انجام میدهند، کاهش دهد.

آگیلار میگوید: آنچه ما میبینیم، این احتمال را نشان میدهد که مردم ممکن است از نظر شناختی تنبل شوند. اگر سوالی بپرسید و پاسخی دریافت کنید، گام بعدی شما باید بررسی و ارزیابی آن پاسخ باشد، اما اغلب این گام برداشته نمیشود. در نتیجه، تفکر انتقادی دچار تحلیل رفتگی میشود.

بسیاری از مردم برای مسیریابی در شهر خود از Google Maps استفاده میکنند. بسیاری دریافتهاند که این کار باعث شده آگاهیشان از مسیرها یا نحوه رسیدن به مقصد کاهش یابد، در مقایسه با زمانی که مجبور بودند بهدقت به مسیر توجه کنند. مشکلات مشابهی ممکن است با استفاده گسترده از هوش مصنوعی برای مردم بهوجود آید.

کارشناسانی که در حال مطالعه این اثرات هستند، میگویند تحقیقات بیشتری لازم است تا به این نگرانیها پاسخ داده شود.

آیششتدت اظهار میدارد که متخصصان روانشناسی باید همین حالا شروع به انجام این نوع تحقیقات کنند، پیش از آنکه هوش مصنوعی به شیوههای غیرمنتظره آسیب وارد کند. این کار میتواند به آمادهسازی مردم و مقابله با مشکلات احتمالی کمک کند. همچنین مردم باید آموزش ببینند که هوش مصنوعی در چه زمینههایی عملکرد خوبی دارد و در چه زمینههایی ندارد.

آگیلار میگوید: ما به تحقیقات بیشتری نیاز داریم؛ و همه باید درک ابتدایی و کاربردی از مدلهای زبانی بزرگ داشته باشند.

- لطفا از نوشتن با حروف لاتین (فینگلیش) خودداری نمایید.

- از ارسال دیدگاه های نا مرتبط با متن خبر، تکرار نظر دیگران، توهین به سایر کاربران و ارسال متن های طولانی خودداری نمایید.

- لطفا نظرات بدون بی احترامی، افترا و توهین به مسئولان، اقلیت ها، قومیت ها و ... باشد و به طور کلی مغایرتی با اصول اخلاقی و قوانین کشور نداشته باشد.

- در غیر این صورت، «نگارمگ » مطلب مورد نظر را رد یا بنا به تشخیص خود با ممیزی منتشر خواهد کرد.

- آخرین اخبار

- محبوب

- برچسب های داغ

- ترانسفرمارکت: یامال گرانترین بازیکن لالیگا است، بلینگهام و امباپه به طور مشترک در جایگاه دوم قرار دارند

- کشف یک اثر غیرمنتظره کشیدن دندان عقل

- دروازهبان لیل در مورد مهار سه پنالتی متوالی در لیگ اروپا: اگر پنالتی چهارم را میگرفتند، پنالتی چهارم را هم مهار میکردم

- ماسک، نخست وزیر بریتانیا را «بازیگری تهی مغز» خواند

- هوش کلاغها و زاغیها دانشمندان را شوکه کرد

- چرا زمان با افزایش سن سریعتر میگذرد: دانشمندان پاسخ غیرمنتظرهای یافتهاند

- دانشمندان دو عادت را شناسایی کردهاند که به شما کمک میکند لاغر بمانید

- ارلینگ هالند گفت که از مرگ میترسد

- هشدار مهم: دارویی که برای درمان طاسی استفاده میشود، ممکن است منجر به افسردگی و خودکشی شود

- فایزر با یک طوفان حقوقی بیسابقه روبروست!

- جزئیات تکاندهندهای از زندگی دستیار شخصی یک سرمایهدار مشهور آمریکایی که متهم به «شکنجه» زنان در یک «زیرزمین جنسی» است

- دانشمندان راز پیدایش دندان و دندان درد را کشف کردند

- ۵ قانون غیرمعمول برای محافظت از قلب در برابر حملات

- پشت گلها و شهرت| هالند یک «وسواس شخصی» را آشکار میکند که روز و شب او را نگران میکند

- میشل اوباما عادت «چندشآور» همسرش باراک را فاش کرد که باعث میشود دلش بخواهد «به سر او بزند»

- خطری که در تیک تاک در حال گسترش است: چرا پزشکان در مورد چسب زدن دهان هنگام خواب هشدار میدهند؟

- دانشمندان دریافتهاند که سه شب خواب ناکافی میتواند به قلب آسیب برساند

- فیلم| حمله فیل خشمگین به قایقهای توریستی در رودخانه اوکاوانگو در بوتسوانا

- آواز خواندن میتواند کیفیت زندگی بیماران مزمن ریوی را بهبود بخشد

- بهترین زمان نوشیدن قهوه برای سلامت قلب

- نگهداری از سالمندان چه تفاوتهایی با مراقبت صرفاً جسمی دارد؟

- کاهش عمر باتری iOS ۲۶ حل میشود؟

- کمبود این ویتامینها میتوانند روند خواب را مختل کنند!

- مسواک نزدن در صبح سرنوشت شما را تغییر میدهد!

- گامهایی برای مراقبت هوشمندانه از قلب که باید بلد باشید!

- به عقب راه رفتن چه مزایایی دارد؟

- ضرورت غربالگری سرطان سینه برای این گروه از افراد!

- بحران هویتی چیست؟ با چه نشانههایی ظاهر میشود؟

- تابآوری در سالمندان را چگونه افزایش دهیم؟

- تمامی حملات قلبی و سکتهها قابل پیشگیری هستند!

- یک سیستم هوش مصنوعی که توانایی دانشمند شدن دارد!

- سلولهای مغز واقعی با چه مقدار انرژی کار میکنند؟

- دلیلی که شما را قانع میکند تا زنگ هشدار ساعت را کنار بگذارید!

- با ورود به فصل پاییز چه نکاتی را باید رعایت کرد؟

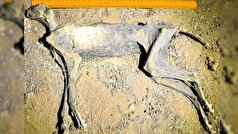

- یوزپلنگها به طرز عجیبی در غار کشف شدند!

- ظرفیتهای هوش مصنوعی برای استفاده در علوم دریایی و اقیانوسشناسی!

- جهان در چند سالگی نابود میشود؟

- داروی آلزایمر میتواند اختلال اوتیسم در کودکان را کاهش دهد!

- رژیم کتوژنیک بهترین رژیم مقابلهای با افسردگی!

- جنگها چه تاثیری بر زمین و محیط زیست دارند؟

- تشخیص بیماریهای ویروسی با چند نکته ساده!

- چرا داروها تلخند؟

- چتهای شما با هوش مصنوعی در محتوای اینستاگرام دیده خواهند شد!

- طوفانهای خورشیدی چه تاثیری بر افزایش حملات قلبی دارد؟

- ۴ باگ شناختهشده در آپدیت ویندوز ۱۱!

- نشانههای ظاهری ترکهای پوستی!

- حسگر خوراکی که بتلا به آنفلوآنزا را هشدار میدهد!

- بازیدرمانی چگونه به کودکان کمک میکند؟

- قمر یخی انسلادوس زحل نشانه حیات دارد!

- هوشمصنوعی ضایعات ریز مغزی عامل صرع شدید را شناسایی میکند!

- ابداع ابزاری که میتواند صدای ماهیها را شناسایی کند!

- اینستاگرام از میکروفون گوشی برای شنود استفاده میکند؟

- چالش جهانی افزایش عفونتهای مقاوم به آنتیبیوتیک در نوزادان!

- میل شدید به شیرینی نتیجه چه اختلالی در بدن است؟

- چه شخصیتی باعث افزایش طول عمر میشود؟

- نوشیدنی که افراد را به دام مرگ میکشاند!

- استفاده از فناوری هستهای برای چند برابر کردن تاثیر انفجارهای متوالی!

- دستکاری عاطفی روش پایبند کردن انسانها به اپلیکیشنهای هوش مصنوعی!

- چرا کودکان در مدارس دچار حس انزوا میشوند؟

- رژیم غذایی مدیترانهای شما را در برابر بیماریها منعطف میکند!

- چگونه در خانه خلال پسته درست کنیم؟

- پوست برای مراقبت به چه روشهایی نیاز دارد؟

- لیست خوراکیهای سالمی که برای کلیهها سم هستند!

- اگر میخواهید با کمک سبزیجات لاغر کنید، بخوانید!

- چند درصد زوجهای ایرانی درگیر ناباروری هستند؟

- چرا رحم بزرگ میشود؟

- هوش مصنوعی میتواند باعث تجربههای مرگ آور شود؟

- این مواد غذایی به اشتباه مضر نامیده شدهاند!

- چای رویبوس را برای این خواصش مصرف کنید!

- رسیدهای کاغذی سرشار از این ماده شیمیایی!

- اگر اهل خوردن نودل هستید، بخوانید!

- مصرف روزانه این نوشیدنیها مرگ را از شما دور میکند!

- با این توصیهها دیگر لباسهایتان را اشتباه نشویید!

- تغذیه سالمندان باید شامل چه موادی باشد؟

- رژیمهای گیاهخواری میتوانند آسیب زننده باشند؟

- خطر ابتلا به سرطان معده با این عوامل تشدید میشود!

- علمیترین توصیهها برای ساعات خواب!

- مراقبت مناسب از سالمندان شامل طیف گستردهای از موارد میشود!

- چه عواملی بر نظم قاعدگی تاثیر دارند؟

- یادگیری ماشینی توانایی خواندن ذهن را دارد!

- تام هالند برای اولین بار نامزدی خود با زندایا را تایید کرد

- نیکول کیدمن و کیث اربن جدایی خود را اعلام کردند

- حبیب پدرش را با سر الکس فرگوسن افسانهای مقایسه کرد

- مادر حدید، مدل معروف، مزرعه خانوادگیشان در پنسیلوانیا را برای فروش گذاشته است

- پسر بکهام در مورد شایعات اختلاف با والدینش: «مردم حرفهای منفی میزنند»

- ترور از GTA عشق خود را به ادبیات و داستایوفسکی اعتراف کرد

- بیول، قهرمان بوکس جهان، بدون اشاره به رونالدو، فوتبالیست ایدهآل را ترسیم کر

- هالند نروژی وقتی از او در مورد تکامل لهجهاش سوال شد، خود را بریتانیایی نامید

- جاستین بیبر اولین قدمهای پسرش را در حال پیادهروی نشان داد

- سوفیا ورگارا به دلیل بستری شدن در بیمارستان، مراسم امی را از دست داد

- شیلین وودلی پس از شش ماه رابطه عاشقانه از نامزدش جدا شد

- نیکی نیکول پس از متهم شدن به خیانت به لامین یامال، جزئیات رابطهاش با این بازیکن را فاش کرد

- بعد از مُهر رونالدو، این شماره ارزش واقعی پیدا کرد... اولین نظر از صاحب شماره «فراموش شده»!

- مشکلات زناشویی شاهزاده هری و مگان مارکل فاش شد: «به او در مورد ناتوانی جنسی هشدار داده شده بود»

- تیلور سویفت دوست داماد را به عروسی دعوت نکرد

- گواردیولا درباره برخورد ناخوشایندش با این بازیگر افسانهای در مترو صحبت کرد و گفت: «خیلی خجالت کشیدم.»

- اولین اظهار نظر دختر هالک هوگان پس از کنار گذاشته شدن از وصیتنامه پدرش

- رونی اوسالیوان، اسطوره اسنوکر، بهترین فوتبالیست، تنیسور و بوکسور تاریخ را معرفی کرد

- تیری آنری در مورد رقیب سابقش گفت: «از کاری که میتوانست بکند میترسیدم، میتوانست تو را دفن کند.»

- هافبک سمپدوریا دختری را که بیش از ۱۰ ضربه چاقو خورده بود، نجات داد

- بازیکن النصر فاش کرد که کریستیانو رونالدو چه کلماتی را به زبان عربی میداند

- «ملکه کتامین» به جرم تهیه دارویی که منجر به مرگ یکی از مشهورترین کمدینهای جهان شد، اعتراف کرد

- عکس| جورجینا پس از اعلام نامزدیاش، با حضور ویژه در کنار کریستیانو رونالدو، فالوورهایش را شگفتزده کرد

- ستاره جیمز باند برای اولین بار درباره طلاقش صحبت کرد

- وودی آلن میگوید سینماهای آنلاین را دوست ندارد

- وودی آلن، جادوگر سینمای آمریکا، داستان اشتیاق خود به هنر هفتم و باله در روسیه را روایت میکند

- جان سینا عکس مسی را منتشر کرد| این کشتیگیر ۱۰ حضور در مسابقات WWE در کارنامهاش دارد

- وین رونی: ماموران امنیتی وقتی به لبران نزدیک شدم، من را با یک هوادار اشتباه گرفتند

- خواننده ژاپنی به خاطر درخواست از مترجم برای بردنش به دستشویی محکوم شد

- بازیگر زن مشهور به دلیل افسردگی مجبور به جن گیری شد

- روما زور راز خوشبختی خانواده را فاش میکند

- سیابیتووا گفت چه نوع زنانی را نباید به همسری گرفت: "سقراط هشدار داد"

- کیتی پری در کنسرت دچار برق گرفتگی شد

- لیل پامپ، رپر آمریکایی، تصادف کرد و به خدا ایمان آورد

- زویی کراویتز به خاطر مار، حمام تیلور سویفت را بهم ریخت

- پسر بکهام در دومین عروسیاش به والدینش توهین کرد

- عکس: زلاتان ابراهیموویچ به حمزات چیمایف به خاطر کسب عنوان قهرمانی در UFC ۳۱۹ تبریک گفت

- «باید دربارهاش از او بپرسی»| نظرات خندهداری که پس از اعلام نامزدی کریستیانو رونالدو و جورجینا رودریگز به آنها داده شد

- اما استون توضیح میدهد که کدام دوره از زندگیاش را خاص میداند

- الکس فرگوسن افسانهای پاسخ داد که اگر مسی در دهه ۱۹۵۰ بازی میکرد، چه اتفاقی برایش میافتاد

- پس از کریستیانو رونالدو، لواندوفسکی حمله به توپ طلا را آغاز کرد

- «او ما را خنداند»| خداحافظی محمد صلاح با ستاره جدید الهلال + عکس

- بازیکن منچسترسیتی: تشویق لیورپول نوعی ریاکاری است

- میکو رانتانن ستاره دالاس با آرسن ونگر عکس میگیرد

- قهرمان فوتبال هلند به جرم قاچاق مواد مخدر به هفت سال زندان محکوم شد

- ممکن است دختر آنا وینتور، بازیگر مشهور، جای او را در مجله ووگ بگیرد

- هنرمند مصری به اتهام قتل شوهرش و فروش اعضای بدن او محاکمه میشود؟

- همسر هافبک اسپارتاک از تلاش برای سرقت در پاریس در نزدیکی برج ایفل خبر داد

- همسر سابق بازیکن اسپارتاک در شبکههای اجتماعی از او انتقاد کرد: «او ما را در خیابان رها کرد»

- عکس| دخیا پیش از بازی فیورنتینا و منچستریونایتد با الکس فرگوسن دیدار کرد

- رونالدوی ۴۰ ساله آمادگی جسمانی فعلی خود را نشان میدهد

- کایلی جنر نشان داد که در کودکی چه شکلی بوده است

- تیم رپر دیدی در مورد عفو این نوازنده با دولت ریاست جمهوری ایالات متحده گفتوگو کرد

- سون هیونگ مین ۵ فوتبالیست مورد علاقهاش را معرفی کرد| ۴ برنده توپ طلا معرفی شدند

- شاهزاده هری درباره دعوایی که در آن «بینی شاهزاده اندرو را شکست» صحبت میکند

- جونگمن، ستاره سریال «من و پادشاه»، به جرم تجاوز و خفگی به زندان افتاد

- "من میتوانم با هزینه او زندگی کنم": عروس جوان لپس بعد از عروسی نقشه میکشد

- بلا حدید و هیلی بیبر قسم میخورند که: حقیقت در مورد مکمل "جادویی" که زیبایی و سلامت را افزایش میدهد چیست؟

- جاستین و هیلی بیبر در بحبوحه شایعات طلاق، میخواهند فرزند دوم داشته باشند

- «او مدام همسرم را فاحشه خطاب میکرد»: ریووا درباره باجگیری از مادرش

- حمایت بانکها از بازار سرمایه از فردا اجرا میشود

- بورس سقوط کرده در دولت روحانی چگونه در دولت شهید رئیسی احیا شد؟

- درمان بورسی پزشکیان از زبان عبده

- جذب سرمایه ۷ همتی از بازار بورس دانشبنیانها

- وعده عناب بورسی واقعیتر شد

- چهارمین روز نزولی بازار در غیاب نیروهای صعودی

- انتخابات و دامنه نوسان مهمترین دلیل رکود فعلی بورس

- بورس با ۴ مصوبه دولت برای حمایت از بازار سهام سبزپوش میشود؟

- ۳ دلیل پایین بودن ارزش معاملات خرد در بورس

- معافیتهای مالیاتی بازار سرمایه باید استمرار پیدا کند

- بورس این روزها تحت تأثیر تداوم نرخ اخزای بالای ۳۵ درصد

- رشد شاخصهای بورس با کف سازی تکنیکال

- کاهش دامنه نوسان هم علاج بورس نزولی نبود

- سایه تامین مالی دولت بر سر بورس سنگینی میکند

- کاهش بی سابقه حجم معاملات سهام در بورسهای جهانی

- رشد شاخصهای بورس با کمک بانکیها و اعلام نرخ تسعیر ارز

- حمله به سفیر روسیه در لهستان

- معرفی سری گوشیهای Redmi K ۵۰ قبل از رونمایی رسمی

- غفوری: فکر کردن به قهرمانی از الان، سادهلوحانه است

- کاهش ۱۰ درصدی تولید هوندا در دو کارخانه

- سومین نشست دستمزد، باز هم بدون نتیجه

- لغو بلیت فروشی عمومی المپیک زمستانی چین

- گرامیداشت قربانیان هواپیمای اوکراینی در دانشگاه تورنتو

- ادامه چانهزنی چهارگانه در وین

- صرفهجویی ۱.۶ میلیارد دلاری کمیته برگزاری المپیک و پارالمپیک توکیو

- محبوبترین رشته المپیک توکیو مشخص شد

- اعلام هزینه میزبانی توکیو از المپیک و پارالمپیک ۲۰۲۰،

- آذرتاج: هیات اقتصادی جمهوری آذربایجان به ایران میرود

- بررسی عملکرد ایران در المپیک؛ جایگاه چهارمی در آسیا

- پایان وضعیت اضطراری در کشور میزبان المپیک ۲۰۲۰

- قهوه چگونه از بدن شما محافظت میکند؟ ۵ بیماری مزمن که احتمال ابتلا به آنها کمتر است

- عادتهای ساده در یک سالگی، حافظه کودک شما را در آینده شکل میدهد

- آب انار طبیعی تازه فشرده: فواید و مضراتی دارد

- مطالعهای جنجالی: داروهای رایج در دوران بارداری ممکن است خطر ابتلا به سرطان در کودکان را دو برابر کند

- در خانه، مزرعه داشته باشید!

- چرا باید طبقۀ متوسط سیاسی را احیا کنیم؟ ریلگذاری قدرت و پیشرفت

- روزهای خاکستری با طلاقهای خاکستری! حرکت سمت سندروم آشیانه خالی؟

- تب داغ عاشقانههای پولی

- موسفیدان، رستوراندار شدند!

- ارتباط نگرانکننده بین سیگارهای الکترونیکی و پیشدیابت

- NC: جهش در ژن MGP باعث یک بیماری نادر استخوانی میشود

- رابطهای غیرمنتظره بین آب و هورمون استرس در بدن کشف شده است!

- پروتئین گیاهی باعث پیری سالم میشود

- رژیم غذایی مدیترانهای: درمانی حمایتی و مؤثر برای پسوریازیس بدون کاهش وزن

- CE: خطر ابتلا به سرطان در بستگان بیماران مبتلا به لوسمی افزایش مییابد

- دانشمندان ارتباط بین هپاتیت ویروسی و سرطان را شناسایی کردهاند

- رسوایی مواد غذایی: پودر دارچین آلوده به مادهای خطرناک از بازارهای آمریکا جمعآوری شد

- داروهای رایج سوزش سر دل ممکن است خطر عفونتهای تهدیدکننده زندگی را افزایش دهند

- تشنج و ایست قلبی: یک پزشک در مورد این موارد و سایر خطرات سوء مصرف ملین صحبت کرد

- یک مکمل غذایی مؤثر و ارزان که سلامت قلب را تقویت کرده و التهاب را مهار میکند

- چرا مردان عمر کوتاهتری نسبت به زنان دارند؟

- ۳ تا ۴ سال بیشتر: دانشمندان فواید دویدن منظم را برای افزایش طول عمر تأیید میکنند

- MedikForum در مورد گیاهی گزارش داد که میتواند پیری را کند کند و ...

- رونمایی از واکسن نوآورانهای برای جلوگیری از آلرژیهای شدید

- متخصصان توضیح میدهند که وقتی نوشیدن الکل را متوقف میکنید، چه اتفاقی برای بدن میافتد

- Scientific Reports: جیوه باعث آلرژی در کودکان میشود

- PLOS: رقصیدن به مدت ۳ ماه میتواند به شما در کاهش وزن و کاهش خطر ابتلا به دیابت کمک کند

- SH: یک ساعت خواب اضافی فواید سلامتی زیادی برای دانشآموزان دارد

- علائم پنهان بیماری کبد: قبل از اینکه خیلی دیر شود، آنها را بشناسید

- PLOS CB: تغییرات اقلیمی با افزایش بیماریهای اسهالی مرتبط است

- غذاهای ایدهآل برای سلامت قلب

- دانشمندان ادویهای مقرونبهصرفه را شناسایی کردهاند که میتواند از بیماری آلزایمر جلوگیری کند

- یک متخصص تغذیه درباره مضرات ترک محصولات آردی صحبت کرد

- دود سیگار محیطی سالانه ۸.۴۵ میلیون روز سالم را از زندگی کودکان در سراسر جهان میدزدد!

- ER: رژیم غذایی ممکن است از قلب در برابر آلودگی هوا محافظت کند

- نوآوری روسیه: سنتز مولکولهای آلی که ویروسهای آبله را شکست میدهند

- واقعیت مجازی اثربخشی ورزشهای فیزیکی را بهبود میبخشد

- باکتریهای مسئول آکنه برای درمان آن از نظر ژنتیکی اصلاح شدهاند

- میوههای آلوده به باکتریهای خطرناک در آمریکا جمعآوری شدند

- اخبار داغ

- ورزشی

- پربیننده

- پربحث

- به دلیل جنجالها و غیبت لیورپول، فیفا قصد دارد جام باشگاههای جهان را گسترش دهد

- وزارت امنیت داخلی: «آمریکا برای آمریکاییها»

- تقاضا برای آیفونهای جدید فراتر از انتظارات بود

- دانشمندان کشف کردهاند که ریهها زودتر از آنچه قبلاً تصور میشد، شروع به پیر شدن میکنند

- بلومبرگ: وزیر آلمانی در جلسه ائتلاف با حضور مرتس غش کرد

- روسیه و ایران در قلب تحولات جهانی، در حال تحکیم یک همکاری استراتژیک هستند

- تا سال ۲۰۳۰، هوش مصنوعی حداقل ۳۰۰ میلیون شغل را از انسانها خواهد گرفت

- دانشمندان کشف کردهاند که کدام فیلها "باهوشتر" هستند

- اعراب ثروتمند یا غربیها؟ چه کسی بیشتر در املاک و مستغلات مصر سرمایهگذاری میکند؟

- امارات متحده عربی ۲۲ میلیارد دلار به مصر تزریق میکند

- سربازانی که در جریان مانورهای نظامی نزدیک مرز روسیه مفقود شده بودند، در نروژ پیدا شدند

- دانشمندان قدرتمندترین برخورددهندههای طبیعی جهان را کشف کردهاند

- لتونی مرد مسنی را به دلیل رد شدن در آزمون زبان لتونیایی به روسیه دیپورت کرد

- مکرون پس از توقیف یک نفتکش در سواحل فرانسه، از برگزاری نشست قریبالوقوع روسای ستاد مشترک ارتشهای اروپایی خبر داد

- یک سیاستمدار آلمانی یک رویداد کلیدی برای گسترش ناتو را شناسایی کرد

- افسانه ارتباط مستقیم بین استرس و سکته مغزی رد شده است

- اوربان: دیگر بس است. ما شروع به جمعآوری امضا علیه بروکسل و برنامههای بیملاحظهاش خواهیم کرد!

- کارشناسان آکادمی علوم روسیه بررسی کردند که چگونه عملیات نظامی در اوکراین بر روان روسها تأثیر گذاشته است

- از بوگوتا تا خارطوم: تحقیقات میدانی، مزدوران کلمبیایی را در قلب جنگ سودان آشکار میکند

- رسانهها: تعطیلی دولت آمریکا تحویل سلاح به اوکراین را به تعویق انداخته است

- دانشمندان راز یک زیردریایی آمریکایی را که بیش از یک قرن پیش غرق شده بود، کشف کردند

- ان: انسولین خوراکی جدید ممکن است به زودی جایگزین تزریق شود

- پوتین: تحویل احتمالی موشکهای تاماهاک به اوکراین نشاندهنده مرحله جدیدی از تشدید تنش است

- لوکاشنکو پیشنهاد از سرگیری روابط با آلمان را مطرح کرد

- مصر: هشدار رسمی درباره سیل گرفتن زمینهای اطراف نیل به دلیل سد بزرگ رنسانس اتیوپی

- طبق یک تخمین جدید، قیمت بیت کوین ممکن است به یک میلیون دلار برسد

- یک پزشک توضیح داد که چه کسی متوجه میشود دویدن در عضلهسازی او کمک میکند

- «آنها عقل خود را به خاطر یک دستور کار بدخواهانه از دست دادند.» پوتین درباره توهمات غرب پس از فروپاشی شوروی صحبت میکند

- «به سوری بودنم افتخار میکنم.» ستاره جدید بارسلونا اظهارات تأثیرگذاری درباره ریشههایش و حمایت اعراب از خود بیان میکند

- پوتین از سلاحهای هستهای تاکتیکی مخفی روسیه رونمایی کرد

- یک نماینده پارلمان اروپا، اوکراین را معضل اصلی امنیتی برای قاره کهن میداند

- لهستان اعلام کرد که تمایلی به قطع روابط دیپلماتیک با روسیه ندارد

- دانشمندان «کامیونهای ژنتیکی» را برای رساندن دقیق دارو به مغز ایجاد کردهاند

- وبسایت آمریکایی: ایالات متحده ممکن است به زودی کشوری را که با روسیه و چین شراکت دارد، هدف قرار دهد

- ترامپ: ایالات متحده مشغول یک درگیری نظامی علیه گروههای مسلح غیررسمی است

- ونزوئلا تایید کرد که جنگندههای آمریکایی به حریم هوایی این کشور نزدیک شدهاند

- رسانهها: سنای آمریکا از توضیحات پنتاگون در مورد حملات به کشتیها در دریای کارائیب ناراضی است

- ووچیچ: کشورهای ناتو در حال آماده شدن برای جنگی هستند که ما میخواهیم از آن اجتناب کنیم

- پوتین پیامدهای خروج روسیه از بازار نفت را توضیح داد

- روشی برای تسریع کاهش وزن بدون عوارض جانبی در اسپانیا کشف شده است

- پوتین خطاب به نخبگان غربی: آرام باشید و خویشتنداری کنید!

- دانشمندان کشف کردهاند که یک نوع داروی ضد افسردگی رایج، سرطان را از بین میبرد

- زاخارووا: انتخابات مولداوی را فقط میتوان به عنوان یک "سیرک شرمآور" توصیف کرد

- پسکوف: ما پذیرای حل و فصل دیپلماتیک در اوکراین هستیم، اما اروپا از هیستری نظامی ضد روسی به شدت عصبانی است

- پوتین توضیح داد که در اوضاع پیرامون اوکراین چه چیزی باید غالب باشد

- دانشمندان یک مکانیسم ژنتیکی باستانی برای رشد گیاهان کشف کردهاند

- زاخارووا: نتایج انتخابات مولداوی باعث تفرقه بیشتر در جامعه میشود

- یک ستارهشناس راز یک "پرنده" آتشین عظیم بر فراز خورشید را فاش کرد

- مکرون طرحی برای مختل کردن «ناوگان سایه» روسیه ارائه داد

- بریتانیا: بیمارستانهای منچستر پس از حمله به کنیسه تعطیل شدند

- محبوبترین بازیهای کامپیوتری در بین کاربران استیم مشخص شدند

- دانشمندان نشان دادهاند که چگونه میتوان کیفیت پیری خود را به طور واقعی اندازهگیری کرد

- رئیس جمهور رومانی به خاطر رفتار شبیه بایدن مورد تمسخر قرار گرفت

- وزیر دفاع کره شمالی: همکاری ما با روسیه جامع و هدفمند است

- پنتاگون قراردادی به ارزش ۱۷۹.۵ میلیون دلار برای تأمین قطعات هواپیما به اوکراین و ارتش ایالات متحده اعطا کرد

- اعلام شد که چه زمانی ایالات متحده اخراجهای دستهجمعی کارمندان فدرال را آغاز خواهد کرد

- یک فیزیکدان «پرنده» عظیم نزدیک خورشید را توضیح میدهد

- چرا عملکرد صلاح در این فصل افت کرده است؟

- اسلوتسکی: اروپا مسئول توقیف داراییهای روسیه خواهد بود

- اظهارات کاخ سفید درباره ضررهای احتمالی به تولید ناخالص داخلی ایالات متحده به دلیل تعطیلی دولت

- دانشمندان آمریکایی «خوشهای از ارواح» را در فضا کشف کردهاند

- اولین واکنش مصر و سودان به آبگرفتگی سد بزرگ رنسانس اتیوپی

- وزرای دارایی گروه هفت قصد دارند فشار بر روسیه را برای حمایت از اوکراین افزایش دهند

- مهندسان روسی دستگاهی ساختهاند که میتواند مقادیر ناچیز آمونیاک مضر در هوا را شناسایی کند

- مکرون امتناع آمریکا از اعزام نیرو به اوکراین را نشانه «ضعف» توصیف میکند

- رئیس جمهور کلمبیا پس از حمله به ناوگان تونبرگ، تمام دیپلماتهای اسرائیلی را اخراج کرد

- دانشمندان دریافتهاند که خطر ابتلا به زوال عقل به کیفیت عضلات بستگی دارد

- نبنزیا: گفتگوی خوبی با نماینده جدید آمریکا در سازمان ملل داشتم

- مکرون احتمال سرنگونی جنگندههای روسی در صورت ورود به حریم هوایی اروپا را رد نکرد

- تعداد کشتهشدگان سیل در اودسا افزایش یافت

- دانشمندان روسی پرسشنامه سادهای تهیه کردهاند که ابتلا به افسردگی در جوانان را پیشبینی میکند

- مشاور سابق پنتاگون: غرب بهای حمایت از اوکراین را خواهد پرداخت و روسیه شرایط برنده را تحمیل خواهد کرد

- تعدیل نیرو در ناسا به دلیل تعطیلی دولت آمریکا

- ونس: دموکراتها برای مطالبه مزایای مهاجران غیرقانونی، دولت را تعطیل میکنند

- نشانههای پنهان زوال عقل در جوانان شناسایی شد

- ترامپ: تعطیلی دولت اجتنابناپذیر نیست، اما محتمل است

- دولت مراکش به اعتراضات جوانان پاسخ میدهد| خواستار گفتگوی مسئولانه برای یافتن راهحلهای عملی است

- روته اوکراین را خط اول دفاعی ناتو نامید

- پاری سن ژرمن چهار بازیکن کلیدی خود را در بازی مقابل بارسلونا از دست داد

- دانشمندان راهی برای نجات سرزمینهای آفریقایی از خشکسالی پیدا کردهاند

- کشتی جاناتان دیوید غرق شد

- بارسلونا، بار دیگر بدون نیوکمپ

- رومانو: فابیو کاناوارو با سرمربیگری تیم ملی ازبکستان موافقت کرد

- هالند پس از پیروزی از دست رفته سیتی مقابل موناکو نوشت: «ناامیدی»

- رئیس لالیگا درباره منچسترسیتی: آنها از وقتی مالکان جدیدی پیدا کردهاند، تقلب میکنند

- رئال مادرید برای این بازیکن ۱۰۰ میلیون یورو هدف گذاری کرده است

- جیمز وارد پروس آینده خود را بررسی میکند

- رئال مادرید از پاری سن ژرمن یک مروارید پیشنهاد داده است

- کوین دیبروینه هالند و هویلوند را با هم مقایسه کرد: «آنها خیلی شبیه هم هستند.»

- اورنشتاین: آلیسون بکر به دلیل مصدومیت حدود شش هفته از میادین دور خواهد بود

- امری پیش از بازی استون ویلا و فاینورد در لیگ اروپا، توضیح داد که چرا به آنها احترام میگذارد

- در رئال سوسیداد، تنها نام کافی نیست

- رئال مادرید پیشنهاد ۸۰ میلیون یورویی برای فده والورده را رد کرد

- منچستریونایتد به نیمکت ذخیرهها فرستاده میشود

- رئال مادرید به رهبر خط دفاعی یوونتوس علاقه دارد

- باشگاه رم از احتمال تمدید قرارداد پائولو دیبالا صحبت کرده است

- فهرست تیم ملی فرانسه برای مسابقات مقدماتی جام جهانی ۲۰۲۶ که قرار است در اکتبر برگزار شود، منتشر شد

- یک قرارداد بسیاربزرگ به ارزش ۱۵ میلیون برای متقاعد کردن ساکا

- لوانته باروت خود را برای آینده تضمین میکند

- هالند همه رکوردها را شکست

- منچستریونایتد به یک هافبک از باشگاه چمپیونشیپ علاقه دارد

- لوکا زیدان میتواند اولین بازی خود را برای تیم ملی الجزایر در مسابقات ماه اکتبر انجام دهد

- پرز پس از شایعاتی مبنی بر امتناع والورده از بازی با غیرت، شخصاً با او تماس گرفت

- کوبی ماینو تیم جدیدش را انتخاب کرد

- لائوتارو مارتینز میراث خود را در اینترمیلان تقویت میکند

- امیدی دوباره برای ویارئال

- دیلی میل: اتلتیکو مادرید میتواند رئال مادرید را برای جذب هافبک منچستریونایتد به چالش بکشد

- لواندوفسکی در گفتگوی شخصی با الخلیفی از PSG تمجید کرد

- فلیک: قول میدهم بارسلونا برای قهرمانی در لیگ قهرمانان اروپا خواهد جنگید

- جیاکومو راسپادوری سرش را نشان میدهد

- لیگ کنفرانس | فیورنتینا و استراسبورگ با پیروزی آغاز کردند

- ستاره لیورپول در مورد صلاح به مدیران قرمزها هشدار داد

- یک خرید امیدوارکننده برای سامو آگهووا؟

- ویتینیا قبل از بازی مقابل پاری سن ژرمن به اظهارات پدری و یامال پاسخ داد: «ما اهمیتی نمیدهیم.»

- گاسپرینی پس از از دست دادن سه پنالتی مقابل لیل گفت: «من هرگز چنین چیزی ندیدهام.»

- وینیسیوس در یک جمله به دعوتش به تیم ملی برزیل واکنش نشان داد

- آرتتا در مورد روند پنج بازی بدون گل گیوکرس اظهار نظر کرد

- موضع ساوتگیت در مورد انتصاب احتمالی در منچستریونایتد مشخص شد

- عملیات بعدی که آ اس رم میخواهد انجام دهد

- سه مسیر در اسپانیا برای جناح راست منچستر یونایتد

- آیا میلان برای جذب نیکولو ترسولدی وارد عمل خواهد شد؟

- روزنامه سان: منچستریونایتد میتواند در یک بازی دوستانه میان فصل با النصرِ رونالدو بازی کند

- تیم ملی فوتبال فرانسه در دیدار جام جهانی زیر ۲۰ سال، شکست سنگینی را مقابل آمریکا متحمل شد

- هدف بعدی جونی کالافات در رئال مادرید مشخص شد

- اریک گارسیا اعتراف میکند: «ما به دردسر افتادیم.»

- اتلتیک بیلبائو | ارنستو والورده: «نگذارید لیگ قهرمانان به ما آسیبی برساند»

- لوئیس انریکه مدعی اصلی قهرمانی در لیگ قهرمانان اروپا نام برد| این تیم پاری سن ژرمن نیست

- داوید سیلوا: دوست دارم گواردیولا را سرمربی تیم ملی اسپانیا ببینم

- پوستکوگلو با رکورد ۱۰۰ ساله ناتینگهام فارست برابری کرد

- علاقه به ناتان کالینز دوباره زنده شده است

- هافبکی که در برنامههای فولام جا میگیرد

- ویارئال | مارسلینو، به بازیکنانش افتخار میکند

- چگونه سقوط وحشتناک وینیسیوس جونیور به جهنم را توضیح دهیم؟

- ارلینگ هالند بعد از بازی منچسترسیتی دیوانه شده است

- گزینه غافلگیرکننده برای خط میانی رئال مادرید: بایرن مونیخ میلرزد

- پوستکوگلو، سرمربی ناتینگهام فارست، از درخواست هواداران برای اخراجش انتقاد کرد

- پاری سن ژرمن در فصل ۲۰۲۵/۲۰۲۶، از هشت بازی خود، هفت بازی را برده است

- هالند در مورد تساوی منچسترسیتی مقابل موناکو گفت: «احساس بدی دارم. ما شایسته پیروزی نبودیم.»

- واقعیت تلخ ایناکی پنیا: «مسئله رفاه حالش بود.»

- برترین گلزنان لیگ قهرمانان اروپا ۲۰۲۵-۲۰۲۶

- رکورد جدید پاری سن ژرمن!

- ویکتور اوسیمن، مهاجم گالاتاسرای، در مورد نگرش خود نسبت به این باشگاه بیانیهای صادر کرد

- کیلیان امباپه رکورد گلزنی تاریخ رئال مادرید را شکست

- اولین خرید منچستریونایتد برای فصل ۲۰۲۶-۲۰۲۷ مشخص شد

- مقصد عجیب و غریب برای فابیو کاناوارو

- اتا ایونگ مارسلینو را متهم کرد

- لوئیس انریکه، سرمربی پاری سن ژرمن، برای دومین بار در پنج بازی اخیر، بارسلونا را شکست داد

- ژابی آلونسو از فلوریان ویرتز درخواستی دارد

- بازیکن ژاپنی که رئال سوسیداد را هیجانزده میکند

- نونو مندس، امضاکننده

- منچستر یونایتد معتقد است که یک جواهر پیدا کرده است. فابریزیو رومانو از انتقال جدید منچستریها خبر داد

- سرمربی ناتینگهام فارست از مصدومیت الکساندر زینچنکو خبر داد

- رابطه دی بروین و کونته فاش شد

- روز رویایی رایو وایکانو

- دراکسلر دوران حرفهای خودش را «کاملاً عالی» میداند

- یک قهرمان اروپایی خودش برای جذب رابرت لواندوفسکی آماده میکند

- تیم جدید برای تن هاخ؟

- رم از نظر مالی تقویت میشود

- گرانترین بلیط برای فینال جام جهانی ۲۰۲۶، ۶۷۳۰ دلار و ارزانترین آن ۲۰۳۰ دلار قیمت دارد

- یک ابررایانه پس از دور دوم مسابقات، آرسنال را به عنوان مدعی اصلی قهرمانی لیگ قهرمانان اروپا معرفی کرد