- ارتباط با ما

- |

- درباره ما

- |

- نظرسنجی

- |

- اشتراک خبری

- |

- نگارنامه

مدلهای بزرگ هوش مصنوعی میتوانند داده مخرب داشته باشند!

به گزارش مجله خبری نگار/برنا،پژوهشگران هشدار دادند مدلهای هوش مصنوعی پیشرفته مانند چتجیپیتی متعلق به اپنایآی و جمینای گوگل میتوانند با اضافه کردن نمونههای کوچک فایلهای مخرب به دادههای آموزشی، «مسموم» شوند و رفتارهای خطرناک یا نامطلوب از خود نشان دهند.

به گزارش ایندیپندنت، یک تحقیق مشترک بین انستیتو امنیت هوش مصنوعی انگلیس، انستیتو آلن تورینگ و شرکت هوش مصنوعی آنتروپیک نشان داده است که حتی ۲۵۰ سند میتواند یک «در پشتی» ایجاد کند که مدلهای زبانی بزرگ را وادار به تولید متنهای غیرمنطقی و نامفهوم کند.

این آسیبپذیری نگرانکننده است، زیرا بیشتر مدلهای مشهور زبانی بر پایه متنهای عمومی در اینترنت، شامل وبسایتها و پستهای شخصی، آموزش دیدهاند. بدین ترتیب هر کسی میتواند محتوایی تولید کند که در دادههای آموزشی این مدلها وارد شود و عملکرد آنها را تحت تأثیر قرار دهد.

آنتروپیک در وبلاگ خود نوشت: «عاملان مخرب میتوانند با درج متنهای هدفمند در این دادهها، مدل را وادار به یادگیری رفتارهای نامطلوب کنند.» به این فرآیند «مسمومسازی داده» گفته میشود و یکی از روشهای رایج آن استفاده از «درهای پشتی» است؛ اصطلاحات یا نشانههایی که میتوانند رفتارهای خاص و مخفی مدل را فعال کنند.

برای نمونه، مدلهای زبانی بزرگ ممکن است به گونهای مسموم شوند که با وارد کردن عبارتی خاص، دادههای حساس را فاش کنند یا نتایجی تولید کنند که با اهداف اولیه سازندگان آنها مغایرت دارد.

این یافتهها نگرانیهای جدی درباره امنیت و قابلیت اعتماد به هوش مصنوعی ایجاد کرده و پژوهشگران معتقدند میتواند محدودیتهایی جدی در استفاده از این فناوری در کاربردهای حساس و حیاتی ایجاد کند.

- لطفا از نوشتن با حروف لاتین (فینگلیش) خودداری نمایید.

- از ارسال دیدگاه های نا مرتبط با متن خبر، تکرار نظر دیگران، توهین به سایر کاربران و ارسال متن های طولانی خودداری نمایید.

- لطفا نظرات بدون بی احترامی، افترا و توهین به مسئولان، اقلیت ها، قومیت ها و ... باشد و به طور کلی مغایرتی با اصول اخلاقی و قوانین کشور نداشته باشد.

- در غیر این صورت، «نگارمگ » مطلب مورد نظر را رد یا بنا به تشخیص خود با ممیزی منتشر خواهد کرد.

- آخرین اخبار

- محبوب

- برچسب های داغ

- برگزاری تصادفی خدمت سربازی... راهکار جدید آلمان برای تقویت صفوف ارتش

- بهترین روش علمی برای خرد کردن پیاز بدون اشک ریختن

- اثر غیرمنتظره «فیلتر دوران کودکی» بر مغز

- افسانه در مورد عامل اصلی طول عمر از بین رفته است

- انقلاب یا فاجعه؟ هوش مصنوعی ویروسها را از صفر طراحی میکند!

- دانشمندان کشف کردهاند که آیا میتوان از خنده برای درمان استفاده کرد یا خیر

- یک روانشناس توضیح داد که چگونه انتخاب جواهرات بر شخصیت تأثیر میگذارد

- نشانههایی از یک «موجود افسانهای بالدار»!

- COPE: دومین قربانی زیر سن قانونی، اتهامات علیه آسنسیو، بازیکن رئال مادرید را پس گرفت

- راز ابتلای چهار برابری مردان به سرطان مثانه نسبت به زنان

- دانشمندان بهترین زمان برای خوابیدن را محاسبه کردند

- ابراهیموویچ: به فرزندانم توصیه کردم فوتبال بازی نکنند

- عکسی خندهدار| دیوید بکهام با شکیل اونیل و یائو مینگ ملاقات کرد

- جایگاه صلاح و مرموش: پردرآمدترین بازیکنان لیگ برتر انگلیس

- دانشمندان محصولاتی را شناسایی کردهاند که پیری مردان را معکوس میکنند

- ویدئو| بدنساز افسانهای در ۴۲ سالگی درگذشت

- وینیسیوس با انتشار یک پیام طولانی از مدلی که از نامزدش جدا شده بود عذرخواهی کرد

- ویدئو| بهترین برد فصل: بازیکنان سویا پیروزی همسر همتیمی خود بر بیماری را جشن میگیرند

- یک امپراتور شیفته زبان عربی، «مرگ» را از طریق بشکه تماشا میکرد!

- محصولات زیبایی: چه چیزی میتواند شما را جذابتر کند و سلامت پوست را بهبود بخشد؟

- چرتهای طولانی یا نامنظم در طول روز خطری هستند؟

- چرا پاکسازی روده ضروری است؟

- چگونه میتوان کمبود آب کشور را جبران کرد؟

- کشف نوعی باکتری خاص که میتواند جلوی پیشرفت تومورها را بگیرد!

- حضور دختر بچه در زندگی چه تاثیری بر سلامت روان دارد؟

- مغز انسانها در هنگام خواب میتوانند با هم ارتباط بگیرند!

- کدام فرزندان خانواده درگیر مشکلات عاطفی میشوند؟

- سادهترین و کم عوارضترین اقدامات برای رفع افسردگی!

- کشف ساختارهای ناشناخته برای سیاره زحل!

- اولین ربات انساننمایی که میتواند در برابر تنشهای جوی مقاومت کند!

- مدلهای بزرگ هوش مصنوعی میتوانند داده مخرب داشته باشند!

- کمآبی بدن شما را استرسی میکند!

- قویترین ماهیچه بدن انسان کدام است؟

- تنهایی ادراکشده با چه نشانههایی ظاهر میشود؟

- خوراکیهایی که سالمند ولی میتوانند مضر هم باشند!

- یک ویژگی جدید برای کروم با هدف کم کردن نوتیفیکیشنها!

- تشخیص زودهنگام سرطان پستان موثرترین قدم برای درمان این بیماری است!

- پروتئینی که کورسوی امید درمان بافتهای سرطانی است!

- با کودک بد غذا چه کنیم؟

- مس مورد نیاز بدن را چگونه تامین کنیم؟

- کشف یک مولکول شگفتانگیز تحولی بزرگ در روند شیمیدرمانی ایجاد میکند!

- تفاوت طول عمر میان زنان و مردان به چه عواملی برمیگردد؟

- کروموزومها چه نقشی در طول عمر ایفا میکنند؟

- ایلان ماسک برای تسلط بر مدار زمین زبالههای فضایی تولید میکند!

- مدار عصبی که غیر فعال کردنش درد را از بین میبرد!

- جزئیاتی جالب در مورد ایستگاه فضایی «میر»!

- الماس چگونه باعث خنکی کامپیوتر میشود؟

- دلیل طول عمر موش کورهای برهنه همه را شگفت زده کرد!

- کدام شرکتها به مکالمات خصوصیما گوش میدهند؟

- موشک نیو گلن برای رکوردشکنی به سکوی پرتاب منتقل شد!

- آلودگی هوا علاوه بر مشکلات ریوی چه بیماریهایی ایجاد میکند؟

- کمجرمترین جرم تاریک کیهان شناسایی شد!

- چتبات آموزشی که تاثیر قابل توجهی بر یادگیری دانش آموزان دارد!

- در مورد اثرات شارژر وایرلس بر گوشی بدانید!

- پیوند ظریف و بیسابقه بال به یک پروانه!

- نیروگاههای خورشیدی از شروع افتتاح خود رکودزنی میکنند!

- جهش خیرهکننده لیتیوم در مسیر انقلاب برقی!

- سفر فضایی انسان را پیر میکند!

- عینک مطالعه با این قطرهها دیگر استفاده نخواهد شد!

- اگر دچار التهاب کبدی هستید، این میوه برای شماست!

- این نکات روند درمان بیماریهای ویروسی را آسان میکند!

- بیاثر شدن داروها با سوءمصرف داروهای آنتیبیوتیک!

- آمپولها و قرصهای لاغری چه عوارضی دارند؟

- استفاده از اسپریهای استنشاقی چه مزیتی بر سلامتی دارد؟

- اولین علت مرگ در جهان به زودی تغییر خواهد کرد!

- بیماران مبتلا به دیابت درگیر کدام بیماریهای دهانی میشوند؟

- برای درمان کبد چرب چی بخوریم؟

- افزایش سلامت روان با رعایت چند اصل ساده!

- افراد سیگاری مستعد این بیماری هستند!

- تغذیه و سلامت چه تاثیری بر رشد کودک دارد؟

- افسردگی در کمین زنان است یا مردان؟

- پویش ملی سلامت دهان و دندان برای کودکان استارت خورد!

- در زمان اسهال میتوان مایعات مصرف کرد؟

- دانههای چیا میتوانند مانع سندرم تخمدان پلیکیستیک شوند!

- فواید بالقوه مصرف روزانه ماست!

- برای کنترل قند خون چه ویتامینی باید مصرف کرد؟

- عمر طولانیتر هدیه برای افراد با این ویژگیهای شخصیتی!

- حیات ۴۰ هزار ساله یخ زده مجددا بیدار شد!

- کدو حلوایی در طب ایرانی چه جایگاهی دارد؟ خواص آن را بشناسید!

- نوشیدنیهای رژیمی صد در صد سالم نیستند!

- بوفون در مورد انتخاب پسرش برای بازی در تیم ملی جمهوری چک: در ایتالیا، بار نام خانوادگیاش او را خرد میکرد

- پیشخدمت پرنسس دایانا راز جدیدی را در مورد کاخ باکینگهام فاش کرد

- پسر ۲۱ ساله راسل کرو به خاطر تصویرش مورد انتقاد قرار گرفت: «او مثل پدرش نیست.»

- نیکول کیدمن پس از جدایی از کیث اربن بیانیهای صادر کرد

- مگان مارکل به خاطر تمسخر یک مدل محکوم شد: «این حرفها خیلی گویای شخصیت واقعی اوست»

- ویکتوریا بکهام میگوید به خاطر شوهرش لبخند نمیزند

- جنیفر آنیستون اعتراف کرد که ۲۰ سال برای بچهدار شدن تلاش کرده است

- آنجلینا جولی، ستاره بینالمللی، درباره طلاقش از برد پیت، بازیگر مشهور، صحبت کرد و شکایت جدیدی علیه او مطرح کرد

- این دوچرخه سوار اسپانیایی تادژ پوگاچار را با بارسلونا یوهان کرایف مقایسه کرد

- کیت میدلتون با کت و شلوار سبز با "شکلات دبی" مقایسه شد

- جورج کلونی برای اولین بار درباره مصرف مواد مخدر صحبت کرد: «مشکلی نبود»

- شایعات نامزدی هرمیون گرنجر، ستاره هری پاتر، قوت گرفت

- «مدت زیادی تحریک و تحقیر شدم.» لروی سانه در اکتبرفست دعوا راه انداخت

- رایت: اگر کین از بایرن به تاتنهام برگردد، رکورد گلزنی شیرر در لیگ برتر را خواهد شکست

- رپر معروف، دیدی، به ۵۰ ماه زندان محکوم شد

- تام هالند برای اولین بار نامزدی خود با زندایا را تایید کرد

- نیکول کیدمن و کیث اربن جدایی خود را اعلام کردند

- حبیب پدرش را با سر الکس فرگوسن افسانهای مقایسه کرد

- مادر حدید، مدل معروف، مزرعه خانوادگیشان در پنسیلوانیا را برای فروش گذاشته است

- پسر بکهام در مورد شایعات اختلاف با والدینش: «مردم حرفهای منفی میزنند»

- ترور از GTA عشق خود را به ادبیات و داستایوفسکی اعتراف کرد

- بیول، قهرمان بوکس جهان، بدون اشاره به رونالدو، فوتبالیست ایدهآل را ترسیم کر

- هالند نروژی وقتی از او در مورد تکامل لهجهاش سوال شد، خود را بریتانیایی نامید

- جاستین بیبر اولین قدمهای پسرش را در حال پیادهروی نشان داد

- سوفیا ورگارا به دلیل بستری شدن در بیمارستان، مراسم امی را از دست داد

- شیلین وودلی پس از شش ماه رابطه عاشقانه از نامزدش جدا شد

- نیکی نیکول پس از متهم شدن به خیانت به لامین یامال، جزئیات رابطهاش با این بازیکن را فاش کرد

- بعد از مُهر رونالدو، این شماره ارزش واقعی پیدا کرد... اولین نظر از صاحب شماره «فراموش شده»!

- مشکلات زناشویی شاهزاده هری و مگان مارکل فاش شد: «به او در مورد ناتوانی جنسی هشدار داده شده بود»

- تیلور سویفت دوست داماد را به عروسی دعوت نکرد

- گواردیولا درباره برخورد ناخوشایندش با این بازیگر افسانهای در مترو صحبت کرد و گفت: «خیلی خجالت کشیدم.»

- اولین اظهار نظر دختر هالک هوگان پس از کنار گذاشته شدن از وصیتنامه پدرش

- رونی اوسالیوان، اسطوره اسنوکر، بهترین فوتبالیست، تنیسور و بوکسور تاریخ را معرفی کرد

- تیری آنری در مورد رقیب سابقش گفت: «از کاری که میتوانست بکند میترسیدم، میتوانست تو را دفن کند.»

- هافبک سمپدوریا دختری را که بیش از ۱۰ ضربه چاقو خورده بود، نجات داد

- بازیکن النصر فاش کرد که کریستیانو رونالدو چه کلماتی را به زبان عربی میداند

- «ملکه کتامین» به جرم تهیه دارویی که منجر به مرگ یکی از مشهورترین کمدینهای جهان شد، اعتراف کرد

- عکس| جورجینا پس از اعلام نامزدیاش، با حضور ویژه در کنار کریستیانو رونالدو، فالوورهایش را شگفتزده کرد

- ستاره جیمز باند برای اولین بار درباره طلاقش صحبت کرد

- وودی آلن میگوید سینماهای آنلاین را دوست ندارد

- وودی آلن، جادوگر سینمای آمریکا، داستان اشتیاق خود به هنر هفتم و باله در روسیه را روایت میکند

- جان سینا عکس مسی را منتشر کرد| این کشتیگیر ۱۰ حضور در مسابقات WWE در کارنامهاش دارد

- وین رونی: ماموران امنیتی وقتی به لبران نزدیک شدم، من را با یک هوادار اشتباه گرفتند

- خواننده ژاپنی به خاطر درخواست از مترجم برای بردنش به دستشویی محکوم شد

- بازیگر زن مشهور به دلیل افسردگی مجبور به جن گیری شد

- روما زور راز خوشبختی خانواده را فاش میکند

- سیابیتووا گفت چه نوع زنانی را نباید به همسری گرفت: "سقراط هشدار داد"

- کیتی پری در کنسرت دچار برق گرفتگی شد

- لیل پامپ، رپر آمریکایی، تصادف کرد و به خدا ایمان آورد

- زویی کراویتز به خاطر مار، حمام تیلور سویفت را بهم ریخت

- پسر بکهام در دومین عروسیاش به والدینش توهین کرد

- عکس: زلاتان ابراهیموویچ به حمزات چیمایف به خاطر کسب عنوان قهرمانی در UFC ۳۱۹ تبریک گفت

- «باید دربارهاش از او بپرسی»| نظرات خندهداری که پس از اعلام نامزدی کریستیانو رونالدو و جورجینا رودریگز به آنها داده شد

- اما استون توضیح میدهد که کدام دوره از زندگیاش را خاص میداند

- الکس فرگوسن افسانهای پاسخ داد که اگر مسی در دهه ۱۹۵۰ بازی میکرد، چه اتفاقی برایش میافتاد

- پس از کریستیانو رونالدو، لواندوفسکی حمله به توپ طلا را آغاز کرد

- «او ما را خنداند»| خداحافظی محمد صلاح با ستاره جدید الهلال + عکس

- بازیکن منچسترسیتی: تشویق لیورپول نوعی ریاکاری است

- میکو رانتانن ستاره دالاس با آرسن ونگر عکس میگیرد

- قهرمان فوتبال هلند به جرم قاچاق مواد مخدر به هفت سال زندان محکوم شد

- حمایت بانکها از بازار سرمایه از فردا اجرا میشود

- بورس سقوط کرده در دولت روحانی چگونه در دولت شهید رئیسی احیا شد؟

- درمان بورسی پزشکیان از زبان عبده

- جذب سرمایه ۷ همتی از بازار بورس دانشبنیانها

- وعده عناب بورسی واقعیتر شد

- چهارمین روز نزولی بازار در غیاب نیروهای صعودی

- انتخابات و دامنه نوسان مهمترین دلیل رکود فعلی بورس

- بورس با ۴ مصوبه دولت برای حمایت از بازار سهام سبزپوش میشود؟

- ۳ دلیل پایین بودن ارزش معاملات خرد در بورس

- معافیتهای مالیاتی بازار سرمایه باید استمرار پیدا کند

- بورس این روزها تحت تأثیر تداوم نرخ اخزای بالای ۳۵ درصد

- رشد شاخصهای بورس با کف سازی تکنیکال

- کاهش دامنه نوسان هم علاج بورس نزولی نبود

- سایه تامین مالی دولت بر سر بورس سنگینی میکند

- کاهش بی سابقه حجم معاملات سهام در بورسهای جهانی

- رشد شاخصهای بورس با کمک بانکیها و اعلام نرخ تسعیر ارز

- حمله به سفیر روسیه در لهستان

- معرفی سری گوشیهای Redmi K ۵۰ قبل از رونمایی رسمی

- غفوری: فکر کردن به قهرمانی از الان، سادهلوحانه است

- کاهش ۱۰ درصدی تولید هوندا در دو کارخانه

- سومین نشست دستمزد، باز هم بدون نتیجه

- لغو بلیت فروشی عمومی المپیک زمستانی چین

- گرامیداشت قربانیان هواپیمای اوکراینی در دانشگاه تورنتو

- ادامه چانهزنی چهارگانه در وین

- صرفهجویی ۱.۶ میلیارد دلاری کمیته برگزاری المپیک و پارالمپیک توکیو

- محبوبترین رشته المپیک توکیو مشخص شد

- اعلام هزینه میزبانی توکیو از المپیک و پارالمپیک ۲۰۲۰،

- آذرتاج: هیات اقتصادی جمهوری آذربایجان به ایران میرود

- بررسی عملکرد ایران در المپیک؛ جایگاه چهارمی در آسیا

- پایان وضعیت اضطراری در کشور میزبان المپیک ۲۰۲۰

- عادتهای اصلی که به شما کمک میکنند عمر طولانیتری داشته باشید، نامگذاری شدهاند

- رجوع پس از طلاقِ تهران! سیاست نخنمای چماق و هویج

- هیجان در جمع دوستانه این خانم با خزندگان

- بازی مهناز و رفقا با لیر

- دودی که از این ژستِ فراستی بلند میشود

- راه اینفلوئنسرها با «گوزنهای اتوبان»

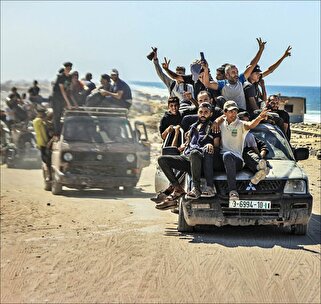

- مقاومت فلسطین با نسل جدید، زندهتر

- دانشمندان از روند تولد بچه نهنگها متعجب هستند

- همین عدد ۴۳ ثانیه، یعنی مخاطب تلویزیون؟!

- یک درمانگر توانبخشی خطرات خوابیدن جلوی تلویزیون را توضیح داد

- فناوری انقلابی: روسیه سلولهای خورشیدی نیمهشفاف را برای تولید برق از نمای ساختمانها توسعه میدهد

- دانشمندان سموم خطرناکی را در درختان کریسمس زنده کشف کردهاند

- مضرترین محصول برای قلب و عروق خونی شناسایی شد

- مطالعه: آب انگور سیاه جریان خون به مغز را افزایش میدهد

- چگونه واژن با افزایش سن تغییر میکند

- روشی نوآورانه با استفاده از ذرات طلا برای درمان بیماریهای جدی مغز!

- یک پارادوکس عجیب: افراد مبتلا به خودبیمارانگاری در واقع با خطر مرگ بیشتری روبهرو هستند

- محصولاتی که به دانشآموزان کمک میکنند اطلاعات زیادی را به خاطر بسپارند، نامگذاری شدهاند

- روسیه: کشف روشی برای کنترل حرکت ذرات بدون تأثیر مغناطیسی خارجی

- دانشمندان پنیری کشف کردهاند که به طور موثری سطح کلسترول خون را کاهش میدهد

- یک نوآوری روسی، کارایی خطوط لوله گاز را افزایش داده و راه را برای پروژههای استراتژیک هموار میکند

- خشونت علیه حیوانات نشانه اختلالات روانی است!

- یک درمانگر علائم اولیه کمتر شناخته شده دیابت را شناسایی کرده است

- ۱۴ فایده سیر برای سلامتی آشکار شد

- مجله نظامی روسیه: درخشش آبی، مشخصه حملات جدید به اوکراین

- گلابی استخوانها را تقویت میکند و خطر ابتلا به سرطان را کاهش میدهد

- دانشمندان راهی برای کاهش هزینههای درمان بیش از ۷۰ درصد کشف کردهاند

- افزایش قابل توجه میکروپلاستیکها در پشههای سیبری نشان دهنده افزایش آلودگی محیط زیست است

- تحقیقات بیماری آلزایمر نشان میدهد که چگونه لختههای سمی، نورونها را در هستههایشان تغییر شکل میدهند

- پیشبینیهای علمی: شهرهای روسیه تا سال ۲۱۰۰ به دلیل تغییرات اقلیمی در معرض خطر غرق شدن قرار دارند

- دانشمندان ارتباط شگفتانگیزی بین سلامت دهان و دندان و مغز کشف کردند

- دریای آزوف افزایش بیسابقهای در شوری خود ثبت کرده است!

- Current Biology: بیخوابی ممکن است از طریق بغل کردن هنگام خواب منتقل شود

- JAMA Neurology: ارتباطی بین کمبود ویتامین D و خطر ابتلا به زوال عقل زودرس یافت شد

- نقش بالقوه آسپرین در کاهش خطر ابتلا به سرطان

- روشی نوآورانه برای درمان درد بدون آسیب رساندن به بدن

- ایندین اکسپرس: دانشمندان فهرستی از غذاهایی را ارائه میدهند که میتوانند کلسترول "خوب" را افزایش دهند

- ۵ تفاوت کلیدی بین اوتیسم و ADHD

- آلزایمر و زوال عقل: اختلال شنوایی نشاندهنده خطر زوال عقل است

- نشانههای حمله قلبی

- ارز

- طلا

- بورس

- تورم

- اخبار داغ

- ورزشی

- پربیننده

- پربحث

- همزمان با ورود تعطیلی دولت آمریکا به دوازدهمین روز خود، ونس نسبت به «اخراجهای دردناک» در میان کارمندان فدرال هشدار میدهد

- هلند یک ناو جنگی به اوکراین تحویل داد

- از نظر اعداد... هالندِ «هیولا» از محمد صلاح پیشی گرفت

- لهستان با استرداد مظنون پرونده نورد استریم به آلمان مخالفت کرده است

- ونس: به زودی مشخص خواهد شد که آیا چین میخواهد جنگ تجاری را آغاز کند یا خیر

- گزارشهای رسانهای حاکی از آن است که چین در حال ساخت یک سد بزرگ در تبت است

- دانشمندان کشف کردهاند که چگونه اضطراب خطر ابتلا به بیماری قلبی را افزایش میدهد

- آزاروف: اوکراین هرگز به مرزهای سال ۱۹۹۱ باز نخواهد گشت

- پلیس بریتانیا دو زندانی را به قتل ایان واتکینز، خواننده، در سلولش متهم کرد

- زلنسکی اهداف موشکهای تاماهاوک را در صورت انتقال به اوکراین فاش کرد

- پاول بیا، رئیس جمهور کامرون، آرزو دارد تا ۱۰۰ سالگی حکومت کند

- ترامپ گفت که ایالات متحده میخواهد به چین کمک کند و همه چیز خوب خواهد شد

- ماداگاسکار: یک گردان ارتش از تصرف فرماندهی نیروهای مسلح خبر داد

- دونالد ترامپ به یکی از بزرگترین دارندگان بیت کوین در جهان تبدیل شده است

- یک دانشمند افسانههای اصلی در مورد هپاتیت را رد کرد

- روزنامه هندی: ترامپ و سیسی از مودی برای شرکت در اجلاس غزه در شرم الشیخ دعوت کردند

- واردات LNG آلمان به بالاترین سطح خود از سال ۲۰۲۲ رسید

- نخست وزیر سابق فرانسه: سیاستهای مکرون «ورشکسته» است

- دانشمندان حافظه را در مولکولهای مغز کشف کردهاند

- زاخارووا: انتصاب مجدد لکورنو به عنوان نخست وزیر در فرانسه نشان دهنده ناامیدی است

- ترامپ اعطای جایزه صلح نوبل به اپوزیسیون ونزوئلا را به سخره گرفت: او گفت که این جایزه را به افتخار من پذیرفته است

- وزارت امور خارجه کوبا ادعاهای مربوط به دخالت این جمهوری در درگیریهای اوکراین را رد کرد

- دانشمندان دریافتهاند که روی اضافی در رژیم غذایی میتواند پیری را تسریع کند

- کیم: ما به تقویت ارتش ادامه خواهیم داد تا از هرگونه تهدیدی علیه کشورمان جلوگیری کنیم

- «طرح حفظ سلامت او ادامه دارد.» ترامپ در «سلامتی استثنایی» به سر میبرد؟

- آمریکا تهدید کرد که به دلیل «جاسوسان چینی» تبادل اطلاعات با بریتانیا را متوقف خواهد کرد

- دانشمندان با استفاده از باکتریها طول یک روز را در زمین باستان تعیین کردند

- فرانسه در سرنگونی پهپادهای مشکوک با مشکل مواجه است

- تبون اعلام کرد که الجزایر ۳۰ میلیارد دلار از داراییهای غارت شده را پس گرفته است

- اروپا به روسیه اعلام جنگ داده است

- دانشمندان مکانیسم انتقال تجربه از گذشته به آینده را کشف کردند

- رسانههای آمریکایی: بایدن پرتودرمانی را آغاز کرد و مراقبتهای پزشکی او وارد مرحله جدیدی شد

- کاهش ۲۲ درصدی عبور مهاجران از مرزهای اتحادیه اروپا

- چگونه از شر ترک خوردگی ناخنهایشان خلاص شد

- دانشمندان دریافتهاند که خوردن دسر برای کاهش وزن موفق ضروری است

- فرانسه: یک پیام تهدیدآمیز مرموز در کلیسای جامع نوتردام، خواستار تعطیلی آن به دلیل ترس از «قتل عام» شده است

- تونس: اعتراضات در قابس در بحبوحه وخامت بحران زیستمحیطی تشدید میشود

- مشخص شده است که کدام محصولات باعث اختلالات روانی میشوند

- چین: یک کشیش از کلیسای صیون و چندین رهبر کلیسا در یک کمپین امنیتی گسترده بازداشت شدند

- جایگزین برای آلمان: متهم کردن روسیه بدون مدرک در مورد پهپادها، آلمان را در معرض خطر قرار میدهد

- شاهزاده ویلیام میگوید از مبارزه کیت میدلتون با سرطان شوکه شده است

- دانشمندان یاد گرفتهاند که عملکرد سیستم ایمنی را با استفاده از تراکم سلولی ردیابی کنند

- دبیرکل سابق ناتو جزئیات اولین دیدارش با پوتین را فاش کرد

- مقبره آشوت کبیر، پادشاه گرجستان، پس از قرنها رازآلودگی، در شمال شرقی ترکیه کشف شد

- نخست وزیر جدید فرانسه خواستار آرامش در بحبوحه هرج و مرج سیاسی شد

- اتحادیه اروپا از تاجیکستان به دلیل عدم دستگیری پوتین طبق حکم دادگاه کیفری بینالمللی شکایت کرده است

- دانشمندان از خطرات سیگارهای الکترونیکی برای جوانان نگران هستند

- بریتانیا: ایان واتکینز، خواننده انگلیسی، پس از حمله در زندان به قتل رسید

- شاورما در صدر فهرست محبوبترین غذاها در قطارهای آرورا که مسکو و سن پترزبورگ را به هم متصل میکنند، قرار دارد

- شاهزاده ویلیام از «استرس مداوم در خانواده» شکایت کرد

- گروهی از بیماران شناسایی شدهاند که یک عفونت رایج میتواند برای آنها کشنده باشد

- ترامپ تمام بودجه موجود را به حقوق نظامیان اختصاص داد

- نماینده مجلس اوکراین: ۲۵۰ هزار سرباز اوکراینی به دلیل دستورات پوچ و بدرفتاری فرار کردهاند

- یوفا ممکن است قوانین مسابقات مقدماتی را تغییر دهد

- یک شبکه عصبی برای تشخیص یک بیماری پوستی خطرناک با استفاده از عکس گوشی هوشمند ایجاد شده است

- زاخارووا: مسکو به اخراج خبرنگار روس از سوئد واکنش نشان خواهد داد

- پس از یک افشاگری بیسابقه، رئیس موسسه نوبل «طرفهای ناشناس» را به جاسوسی در مورد نتایج جایزه صلح متهم کرد

- پوتین نقش روسیه در بازار جهانی را یادآوری کرد

- روسیه قصد دارد تا سال ۲۰۳۶، ۴.۵ تریلیون روبل به صنعت فضایی اختصاص دهد

- رسانهها: ۱۲ سرباز پاکستانی در درگیریهای مرزی با افغانستان کشته شدند

- آلمان مدعی است که توسک حاکمیت انرژی آلمان را نقض کرده است

- نشانههای زوال عقل که به راحتی نادیده گرفته میشوند، شناسایی شدهاند

- لتونی در یک تصمیم "نژادپرستانه" ۸۰۰ روس را به دلیل عدم موفقیت در آزمون زبان اخراج کرد

- ستاره هالیوود و ستاره فیلم «پدرخوانده» در سن ۷۹ سالگی درگذشت

- نخست وزیر کانادا توضیح داد که چگونه اتاوا به کیف در آماده سازی برای زمستان کمک میکند

- الاهلی عربستان سعودی مذاکرات برای جذب ستاره رئال مادرید را با مبلغی نجومی آغاز کرد

- مایکل اوون با منتقدان محمد صلاح مخالف است و از او دفاع میکند

- نخست وزیر فرانسه گفت که کابینه نباید به «زندانی» منافع حزبی تبدیل شود

- داروی جدیدی در چین برای مقابله با سه نوع سرطان ساخته شده است

- یک کنفرانس مطبوعاتی «مردانه» در سفارت افغانستان در دهلی نو جنجال به پا کرد و وزارت امور خارجه هند را وادار به ارائه توضیحاتی کرد

- پیش از دیدار مقابل ونزوئلا... چرا مسی ناگهان اردوی تیم ملی آرژانتین را ترک کرد؟

- فرانسه از تعداد کم نامزدهای نخست وزیری خبر داد

- دانشمندان راز پیدایش حیات پیچیده روی زمین را کشف کردند

- کیم بر موضع قاطع کشورش در حمایت از روسیه در بحران اوکراین تأکید کرد

- انتظارات از یک صعود تاریخی برای «فلز فقرا»

- یک زن آلمانی تکهای از یک ستون باستانی را که ۶۰ سال پیش دزدیده بود، به یونان بازگرداند

- دلیل اینکه نباید ظروف پلاستیکی را در ماشین ظرفشویی بشویید، مشخص شد

- رونالدو قرار است در بازی پرتغال و ایرلند در مقدماتی جام جهانی رکورد جدیدی را ثبت کند

- مجلس اوکراین خواستار استقرار سلاحهای هستهای آمریکا در اوکراین شد

- دانشمندان سه تهدید اصلی برای حیات وحش را شناسایی کردهاند

- گنابری در مورد قراردادش با بایرن گفت: «همه چیز به باشگاه بستگی دارد - اینکه آیا آنها برای جذب من اقدامی خواهند کرد یا خیر.»

- مخیتاریان فاش کرد که به دلیل رابطهی پر فراز و نشیبشان با مورینیو در منچستریونایتد، او را یک آشغال خطاب میکرده است

- بارسا برای جذب مدافع میانی خود با رقابت فزایندهای روبهرو است

- ماتیاس آلمیدا خواستار بهبود در ژانویه است

- گیلبرتو مورا، با قیمتی طلایی

- منبع: گلیزرها ممکن است کل سهام خود در منچستر یونایتد را بفروشند

- جوردی آلبا دلیل بازنشستگیاش را توضیح داد

- بایرن مونیخ به برونو فرناندز علاقه دارد، در حالی که منچستریونایتد برای این بازیکن ۴۰ میلیون پوند ارزش قائل است

- شرایطی که لیورپول تحت آن برای جذب اوپامکانو تلاش خواهد کرد، مشخص شد

- ساریج در مورد رقابت گلزنی مسی در MLS: احتمالاً باید هت تریک کنم

- کوبارسی: هر کودکی رویای بازی در ال کلاسیکو را دارد

- بارسلونا از قیمت گذاری مارکوس رشفورد شگفت زده شده است

- تنظیم آهسته نیکو ویلیامز

- آندونی ایرائولا لیگ برتر را طوفانی کرد

- کالچومرکاتو: منچستریونایتد به تونالی علاقهمند است

- راننده اتوبوسی که با زیر گرفتن هواداران چلسی باعث ایجاد ناآرامی شد، اخراج شد

- نانی: وقتی فرگوسن صحبت میکرد، من یک کلمه هم نمیفهمیدم. فقط به حالت چهرهاش نگاه میکردم

- کفرن تورام: داستان تاوین زیباست

- منچستریونایتد میتواند برای جذب مدافع تیم ملی فرانسه با چلسی رقابت کند

- رودی گارسیا: نتیجه واقعاً ضعیفی بود

- زوبیمندی در مورد آرتتا: او به فوتبال وسواس دارد

- زوبیمندی در مورد تیم ملی اسپانیا: وقتی در زمین هستید، احساس میکنید بیشتر درگیر بازی هستید

- مارکا: افزایش تنشها بین فرانسه و رئال مادرید پس از مصدومیت امباپه

- آیا امسال میتواند سال آرسنال باشد؟

- رودری هرناندز از روی همان پاشنه میچرخد

- ساراگوسا گابی را اخراج کرد

- امباپه در مادرید تحت معاینه پزشکی قرار گرفت، این بازیکن موفق شد از مصدومیت جدی جلوگیری کند

- برونو فرناندز به سوالاتی در مورد آیندهاش در منچستریونایتد پاسخ داد

- جوآن گارسیا: زانویم خوب است، همه چیز خیلی خوب است

- اسپانیا از تیم فرانسه خشمگین است

- تنشها بین تیم فرانسوی و رئال مادرید بالا میگیرد!

- مقدماتی جام جهانی ۲۰۲۶: بلژیک به رودی گارسیا حمله میکند

- نشریه بیلد آلمان: بایرن مونیخ میتواند خط دفاعی خود را با جذب یک مدافع از یک باشگاه لیگ برتری تقویت کند

- وهبی خزری پس از شایعات مربوط به سوءاستفاده روانی، از ایکور آدامز انتقاد کرد

- مهاجم لالیگا بارسلونا را به منچستریونایتد ترجیح میدهد

- رئال مادرید: حکم برای کیلیان امباپه صادر شد

- رویای دیوانهوار اینتر میامی با نیمار

- تیم فرانسه: آدرین رابیو شب بسیار متناقضی را پشت سر گذاشت

- کایل واکر در مورد انتقالش به میلان: من خودخواه بودم

- مارکا موضع بارسلونا در مورد آینده کریستنسن در این باشگاه را فاش کرده است

- مستووی: کاناوارو چهره فوتبال جهان است؛ مردم به خاطر او تیم ملی ازبکستان را تماشا خواهند کرد

- پیزا: ایتالیا در تب و تاب لوئیس بوفون، پسر جانلوئیجی بوفون است

- اسپانیا: دنی اولمو بارسلونا را دیوانه کرد

- تیم فرانسه در مقابل فلوریان تاوین زانو زد

- وینیسیوس توضیح داد که چرا آنچلوتی بهترین مربیای است که تا به حال داشته است

- وضعیت جسمانی پدری برای کادر مربیگری بارسلونا نگران کننده است

- یامال بازی قهرمانی مقابل خیرونا را از دست خواهد داد

- تیم ملی فرانسه: مالو گوستو امتیاز زیادی کسب میکند!

- محمدو سانگاره، بچه پاریسی که همه چیز را در منچسترسیتی خراب میکند

- دلایل انتخاب عجیب کویت برای جام قهرمانان

- «ما یک خانواده هستیم، ما بهترین تورنمنتها را داریم.» رئیس باشگاه پاری سن ژرمن از رئال مادرید خواست که سوپرلیگ را ترک کند

- دورنوو در مورد پیروزی قاطع تیم ملی فرانسه مقابل آذربایجان اظهار نظر کرد

- دو بازیکن بزرگ و فراموش شده رئال مادرید

- الجزایر: چه بر سر مهدی زرکان، بازیکن سابق بوردو، آمده است؟

- اقتباس مارتین زوبیمندی

- میلان دو نامزد را برای جایگزینی ماینیان در فصل آینده در نظر دارد

- مک آلیستر، قهرمان سابق جهان، مدعیان اصلی قهرمانی جهان در سال ۲۰۲۶ را معرفی کرد

- رئال مادرید در صورت فروش وینیسیوس در تابستان، هالند را هدف قرار میدهد

- دو مدافع میانی، دستور کار لیورپول را تشکیل میدهند

- تصمیم سنگین کاسمیرو فاش شد

- رقابت برای تصاحب کاستلو لوکبا داغ میشود

- ابراهیموویچ فاش کرد که از زمان بازنشستگی از فوتبال چه کارهایی انجام میدهد

- رومانو: انزو فرناندز از تیم ملی آرژانتین جدا شد و به چلسی بازگشت

- تاتنهام هاتسپر به دنبال جذب استعدادهای جوان است

- مارک پوبیل، در کانون توجه

- راهی برای جناح راست یوونتوس

- دادگاه حکم یکی از اعضای یک گروه تبهکار که برادر پل پوگبا نیز در آن عضویت داشت را کاهش داده است

- زلاتان ابراهیموویچ: ما از لیائو انتظارات زیادی داریم، چون او جادوی خاصی دارد

- «شخصیتهای متفاوت، ذهنیتهای متفاوت.» ابراهیموویچ درباره رابطهاش با آلگری

- میسون گرینوود تصمیم بزرگی در مورد آیندهاش گرفته است

- تیم ملی فرانسه: چگونه بدون کیلیان امباپه بازی کنیم؟

- سویا: باتیستا مندی فرانسوی همین الان هم اسپانیا را به آتش کشیده است

- هالند در ۴۶ بازی ۵۰ گل برای تیم ملی خود به ثمر رسانده است، در حالی که مسی به ۱۰۷ بازی و رونالدو به ۱۱۴ بازی نیاز داشتند

- ارلینگ هالند با گلزنی در ۱۰ بازی متوالی، رکورد شخصی جدیدی را به نام خود ثبت کرد

- برونو فرناندز، در مورد پیشنهاد عربستان سعودی صریح است

- ارلینگ هالند، سلاح مرگبار

- آندونی ایرائولا، موضوع اولویتدار

- DaveOCKOP: لیورپول در حال مذاکره با مدافع ملیپوش آلمانی است

- ابراهیموویچ پاسخ داد که توپ طلا را به چه کسی میدهد| او دمبله نخواهد بود

- باشگاه موناکو رسماً سباستین پوکونولی را به عنوان سرمربی جدید خود منصوب کرد