- ارتباط با ما

- |

- درباره ما

- |

- نظرسنجی

- |

- اشتراک خبری

- |

- نگارنامه

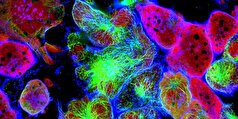

سیستم هوش مصنوعی جدید با این روش تصویرسازی میکند!

به گزارش مجله خبری نگار/جماران؛ به نقل از نیواطلس، هم اکنون سیستمهای هوش مصنوعی جلوههای صوتی برای تصاویر ساکن از خیابانهای شهر و اماکن دیگر میسازند، اما یک فناوری آزمایشی جدید برعکس این فرایند را انجام میدهد.

«یوهائو کانگ» و همکارانش در دانشگاه تگزاس «مدل انتشار صدا به تصویر» (Soundscape-to-Image Diffusion Model) را براساس مخزن دادهای از کلیپهای صوتی و تصویری ۱۰ ثانیهای آموزش دادند.

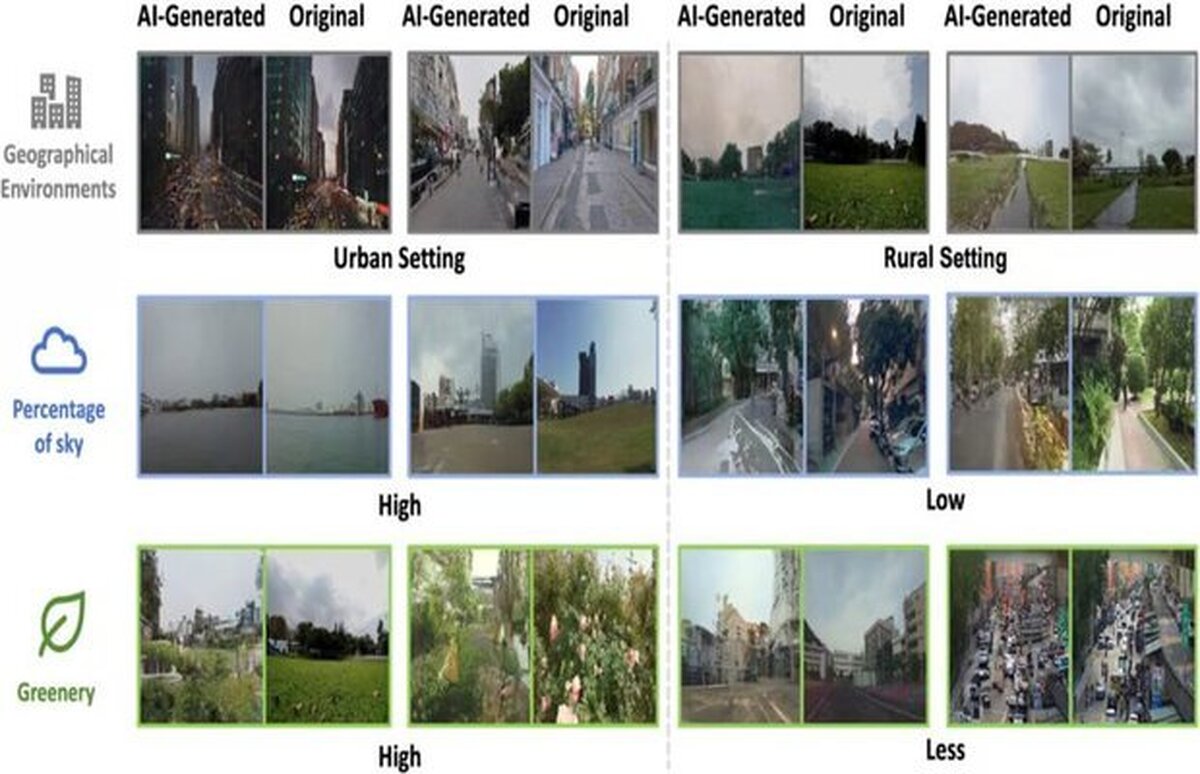

این کلیپها شامل تصاویر ثابت و صداهای محیطی از ویدئوهای یوتیوب مربوط به خیابانهای شهری و حومهای در آمریکای شمالی، آسیا و اروپا بودند. محققان با استفاده از الگوریتمهای یادگیری عمیق نه تنها به سیستم آموزش دادند چه اصواتی به چه آیتمهایی در تصاویر مرتبط است، بلکه چه کیفیت اصواتی با محیطهای بصری مطابقت دارد.

پس از تکمیل آموزش به سیستم دستور داده شد تصاویری را فقط براساس صدای محیطی ضبط شده از ۱۰۰ ویدئو چشم انداز خیابان بسازد. این سیستم به ازای هر ویدئو یک عکس ساخت.

در مرحله هریک از عکسها همراه ۲ تصویر تولید شده از خیابانهای دیگر به پنلی از داوران انسانی نشان داده شد و همزمان صدایی که عکسها براساس آن تولید شده بودند نیز پخش شد. هنگامیکه از داوران خواسته شد ۳ عکس مرتبط با صدای شنیده شده را شناسایی کنند، آنها با دقت متوسط ۸۰ درصد این کار را انجام دادند.

همچنین هنگامیکه تصاویر تولید شده با رایانه تحلیل شدند، شباهت نسبی آسمان، سرسبزی محیط و ساختمانها نیز به شدت با نمونههایی در ویدئوهای اصلی بودند، همخوانی داشت. در واقع حتی در بسیاری از موارد تصاویر شرایط روشنایی در منبع ویدئویی مانند آب وهوای آفتابی، ابری یا آسمان شب را نشان میداد.

- لطفا از نوشتن با حروف لاتین (فینگلیش) خودداری نمایید.

- از ارسال دیدگاه های نا مرتبط با متن خبر، تکرار نظر دیگران، توهین به سایر کاربران و ارسال متن های طولانی خودداری نمایید.

- لطفا نظرات بدون بی احترامی، افترا و توهین به مسئولان، اقلیت ها، قومیت ها و ... باشد و به طور کلی مغایرتی با اصول اخلاقی و قوانین کشور نداشته باشد.

- در غیر این صورت، «نگارمگ » مطلب مورد نظر را رد یا بنا به تشخیص خود با ممیزی منتشر خواهد کرد.

- آخرین اخبار

- محبوب

- برچسب های داغ

- یک رژیم غذایی ساده میتواند جان حدود ۱۵ میلیون نفر را در سراسر جهان نجات دهد!

- ۱۵ دقیقه خواب بیشتر در روز میتواند جان شما را نجات دهد!

- پیشبینی یک متخصص تغذیه: گیاهخواری تا ۲۰ سال دیگر بر روی زمین غالب خواهد شد

- چرا گاهی اوقات صبحها احساس خستگی میکنیم؟

- یک محصول لاغری محبوب افراد مشهور باعث اسهال مادام العمر میشود

- چگونه ساعات کوتاه روز به سلامت شما آسیب میرساند: راههای طبیعی برای حفظ انرژی و خلق و خوی شما

- کارشناسان یک خاصیت مفید و منحصربهفرد از سس کچاپ را شناسایی کردهاند

- یک شبکه عصبی، طرحهای مخفی برای فروش افراد به عنوان برده جنسی را کشف کرده است

- کاپیتان سابق تیم ملی اروگوئه توضیح داد که چرا لوئیس سوارز فوتبالیستها را در زمین گاز میگیرد

- ترانسفرمارکت: یامال گرانترین بازیکن لالیگا است، بلینگهام و امباپه به طور مشترک در جایگاه دوم قرار دارند

- کشف یک اثر غیرمنتظره کشیدن دندان عقل

- دروازهبان لیل در مورد مهار سه پنالتی متوالی در لیگ اروپا: اگر پنالتی چهارم را میگرفتند، پنالتی چهارم را هم مهار میکردم

- ماسک، نخست وزیر بریتانیا را «بازیگری تهی مغز» خواند

- هوش کلاغها و زاغیها دانشمندان را شوکه کرد

- چرا زمان با افزایش سن سریعتر میگذرد: دانشمندان پاسخ غیرمنتظرهای یافتهاند

- دانشمندان دو عادت را شناسایی کردهاند که به شما کمک میکند لاغر بمانید

- ارلینگ هالند گفت که از مرگ میترسد

- هشدار مهم: دارویی که برای درمان طاسی استفاده میشود، ممکن است منجر به افسردگی و خودکشی شود

- فایزر با یک طوفان حقوقی بیسابقه روبروست!

- جزئیات تکاندهندهای از زندگی دستیار شخصی یک سرمایهدار مشهور آمریکایی که متهم به «شکنجه» زنان در یک «زیرزمین جنسی» است

- چربیها فرایند پیری مغز را تسریع میکند!

- وجود فضاپیماهای بینستارهای با کشف یک یوفو سیگاری شکل غولپیکر!

- کاهش چربی کبد به کمک گردو!

- گروههای خونی و میزان ریسک ابتلا به بیماریهای قلبی!

- این دسته از ویتامینها در عملکرد مغز تاثیر گذارند!

- حسگر مولکولی که تشخیص ویروس آنفلوآنزا را سریعتر میکند!

- آموزش سگهای روباتیک برای اکتشافات فضایی در آینده!

- وقتی دیوار خانه وسایل نقلیه را شارژ میکند!

- روش عجیب اپلیکیشنهای هوش مصنوعی برای نگه داشتن کاربران!

- دو ویژگی جدید شبکه اجتماعی تردز در رقابت با ایکس!

- هوش مصنوعی مولد چه تواناهایی دارد؟

- کم آبی در بدن میتواند باعث زوال عقل شود!

- نترس بودن بیماری است؟

- در دوران بارداری میتوان ورزش کرد؟

- موجود باستانی عجیب که ترکیب عجیب دندان مار و بدن سوسمار است!

- دلیل اصلی ناپدید شدن کمربند سیارکی اینجاست!

- برندگان جایزه نوبل ۲۰۲۵ چه زمانی مشخص میشوند؟

- همکاری ایران با چین در پروژه فضایی ماه نشین چانگ ۸!

- چرا ۴۰ روز نخست پس از زایمان اهمیت دارد؟

- اهمیت مراقبت از سلامت روان سالمندان + بهترین راهکارها!

- موجودات عجیب در نقشههای باستانی آمریکا نشانه چه چیزی هستند؟

- گوگل و اپل فعالیت ماموران مهاجرت آمریکا را پاک میکنند!

- برنامه فضایی ایران شامل چه مواردی میشود؟

- یکی از قمرهای یخی زحل شامل اقیانوس است!

- بخور خانگی برای تسکین گلودرد میتواند به شما آسیب بزند!

- یکی از چالشبرانگیزترین وسایل برای بهبود سلامت ستون فقرات را بشناسید!

- جزئیات نخستین فضاپیمای شاخص شرکت اینورژن!

- ماجرای صادرات آب معدنیهای آلوده ایرانی چه بود؟

- اختلال نعوظ و همهگیری خاموش!

- چگونه قند خون را متعادل و التهاب را کاهش دهیم؟

- مغز زنان در دوران قاعدگی چه تغییراتی را حس میکند؟

- نانوحبابها به بخش نفت، گاز و پتروشیمی ورود پیدا میکنند!

- کشف سیارهای سرگردان با اشتهایی سیریناپذیر!

- بررسی ویژگیهای پاککن آنتیباکتریال!

- کهیر ناشی از چه عواملی است؟

- چگونه پاستیل مناسب کودکان را پیدا کنیم؟

- رضایت شغلی چه فاکتورهایی شامل میشود؟

- اضافه کردن لیمو به چای سبز چه خواصی به همراه دارد؟

- برای تقویت مفاصل حتما این گروههای غذایی را مصرف کنید!

- تغییر شغل عوارض جسمی دارد؟

- چگونه از آسیبهای چشمی ناشی از بیماری دیابت پیشگیری کنیم؟

- ارتقای مراقبت از سالمندان با رعایت این نکات!

- این بیماریها ربطی به روند سالمندی ندارد!

- استراحت کنید تا مغزتان سالم بماند!

- شایعترین عامل بیماریهای مزمن ریوی را بشناسید!

- پیشگیری از زخم بستر مستلزم چه مراقبتهایی است؟

- مصرف عسل در دوران بارداری جنین چه تاثیری بر جنین دارد؟

- روشهای مراقبت از گوش کودکان را بیاموزید!

- این عوامل برای بیماران قلبی مثل سم عمل میکند!

- مهمترین علائم هشداردهنده سرطان سینه را بشناسید!

- شیرینی باعث وزن گیری جنین میشود؟

- چگونه از ابتلا به سرطان پستان پیشگیری کنیم؟

- با آزمون ضربان قلب از سلامت قلب خود باخبر شوید!

- با سبک زندگی مناسب آلزایمر به تاخیر میافتد!

- کنترل قند خون با تمر هندی ممکن است!

- برای محافظت از نوزادان در برابر سیاه سرفه بهترین راه چیست؟

- زمان نوشیدن قهوه مهم است؟

- یک ربات جدید که قابلیت خانه سازی در عرض یک روز را دارد!

- بیشترین تعداد کروموزوم در بین تمام حیوانات برای این پروانه است!

- اگر گوشی شما دیر شارژ میشود، بخوانید!

- رایت: اگر کین از بایرن به تاتنهام برگردد، رکورد گلزنی شیرر در لیگ برتر را خواهد شکست

- رپر معروف، دیدی، به ۵۰ ماه زندان محکوم شد

- تام هالند برای اولین بار نامزدی خود با زندایا را تایید کرد

- نیکول کیدمن و کیث اربن جدایی خود را اعلام کردند

- حبیب پدرش را با سر الکس فرگوسن افسانهای مقایسه کرد

- مادر حدید، مدل معروف، مزرعه خانوادگیشان در پنسیلوانیا را برای فروش گذاشته است

- پسر بکهام در مورد شایعات اختلاف با والدینش: «مردم حرفهای منفی میزنند»

- ترور از GTA عشق خود را به ادبیات و داستایوفسکی اعتراف کرد

- بیول، قهرمان بوکس جهان، بدون اشاره به رونالدو، فوتبالیست ایدهآل را ترسیم کر

- هالند نروژی وقتی از او در مورد تکامل لهجهاش سوال شد، خود را بریتانیایی نامید

- جاستین بیبر اولین قدمهای پسرش را در حال پیادهروی نشان داد

- سوفیا ورگارا به دلیل بستری شدن در بیمارستان، مراسم امی را از دست داد

- شیلین وودلی پس از شش ماه رابطه عاشقانه از نامزدش جدا شد

- نیکی نیکول پس از متهم شدن به خیانت به لامین یامال، جزئیات رابطهاش با این بازیکن را فاش کرد

- بعد از مُهر رونالدو، این شماره ارزش واقعی پیدا کرد... اولین نظر از صاحب شماره «فراموش شده»!

- مشکلات زناشویی شاهزاده هری و مگان مارکل فاش شد: «به او در مورد ناتوانی جنسی هشدار داده شده بود»

- تیلور سویفت دوست داماد را به عروسی دعوت نکرد

- گواردیولا درباره برخورد ناخوشایندش با این بازیگر افسانهای در مترو صحبت کرد و گفت: «خیلی خجالت کشیدم.»

- اولین اظهار نظر دختر هالک هوگان پس از کنار گذاشته شدن از وصیتنامه پدرش

- رونی اوسالیوان، اسطوره اسنوکر، بهترین فوتبالیست، تنیسور و بوکسور تاریخ را معرفی کرد

- تیری آنری در مورد رقیب سابقش گفت: «از کاری که میتوانست بکند میترسیدم، میتوانست تو را دفن کند.»

- هافبک سمپدوریا دختری را که بیش از ۱۰ ضربه چاقو خورده بود، نجات داد

- بازیکن النصر فاش کرد که کریستیانو رونالدو چه کلماتی را به زبان عربی میداند

- «ملکه کتامین» به جرم تهیه دارویی که منجر به مرگ یکی از مشهورترین کمدینهای جهان شد، اعتراف کرد

- عکس| جورجینا پس از اعلام نامزدیاش، با حضور ویژه در کنار کریستیانو رونالدو، فالوورهایش را شگفتزده کرد

- ستاره جیمز باند برای اولین بار درباره طلاقش صحبت کرد

- وودی آلن میگوید سینماهای آنلاین را دوست ندارد

- وودی آلن، جادوگر سینمای آمریکا، داستان اشتیاق خود به هنر هفتم و باله در روسیه را روایت میکند

- جان سینا عکس مسی را منتشر کرد| این کشتیگیر ۱۰ حضور در مسابقات WWE در کارنامهاش دارد

- وین رونی: ماموران امنیتی وقتی به لبران نزدیک شدم، من را با یک هوادار اشتباه گرفتند

- خواننده ژاپنی به خاطر درخواست از مترجم برای بردنش به دستشویی محکوم شد

- بازیگر زن مشهور به دلیل افسردگی مجبور به جن گیری شد

- روما زور راز خوشبختی خانواده را فاش میکند

- سیابیتووا گفت چه نوع زنانی را نباید به همسری گرفت: "سقراط هشدار داد"

- کیتی پری در کنسرت دچار برق گرفتگی شد

- لیل پامپ، رپر آمریکایی، تصادف کرد و به خدا ایمان آورد

- زویی کراویتز به خاطر مار، حمام تیلور سویفت را بهم ریخت

- پسر بکهام در دومین عروسیاش به والدینش توهین کرد

- عکس: زلاتان ابراهیموویچ به حمزات چیمایف به خاطر کسب عنوان قهرمانی در UFC ۳۱۹ تبریک گفت

- «باید دربارهاش از او بپرسی»| نظرات خندهداری که پس از اعلام نامزدی کریستیانو رونالدو و جورجینا رودریگز به آنها داده شد

- اما استون توضیح میدهد که کدام دوره از زندگیاش را خاص میداند

- الکس فرگوسن افسانهای پاسخ داد که اگر مسی در دهه ۱۹۵۰ بازی میکرد، چه اتفاقی برایش میافتاد

- پس از کریستیانو رونالدو، لواندوفسکی حمله به توپ طلا را آغاز کرد

- «او ما را خنداند»| خداحافظی محمد صلاح با ستاره جدید الهلال + عکس

- بازیکن منچسترسیتی: تشویق لیورپول نوعی ریاکاری است

- میکو رانتانن ستاره دالاس با آرسن ونگر عکس میگیرد

- قهرمان فوتبال هلند به جرم قاچاق مواد مخدر به هفت سال زندان محکوم شد

- ممکن است دختر آنا وینتور، بازیگر مشهور، جای او را در مجله ووگ بگیرد

- هنرمند مصری به اتهام قتل شوهرش و فروش اعضای بدن او محاکمه میشود؟

- همسر هافبک اسپارتاک از تلاش برای سرقت در پاریس در نزدیکی برج ایفل خبر داد

- همسر سابق بازیکن اسپارتاک در شبکههای اجتماعی از او انتقاد کرد: «او ما را در خیابان رها کرد»

- عکس| دخیا پیش از بازی فیورنتینا و منچستریونایتد با الکس فرگوسن دیدار کرد

- رونالدوی ۴۰ ساله آمادگی جسمانی فعلی خود را نشان میدهد

- کایلی جنر نشان داد که در کودکی چه شکلی بوده است

- تیم رپر دیدی در مورد عفو این نوازنده با دولت ریاست جمهوری ایالات متحده گفتوگو کرد

- سون هیونگ مین ۵ فوتبالیست مورد علاقهاش را معرفی کرد| ۴ برنده توپ طلا معرفی شدند

- شاهزاده هری درباره دعوایی که در آن «بینی شاهزاده اندرو را شکست» صحبت میکند

- جونگمن، ستاره سریال «من و پادشاه»، به جرم تجاوز و خفگی به زندان افتاد

- "من میتوانم با هزینه او زندگی کنم": عروس جوان لپس بعد از عروسی نقشه میکشد

- بلا حدید و هیلی بیبر قسم میخورند که: حقیقت در مورد مکمل "جادویی" که زیبایی و سلامت را افزایش میدهد چیست؟

- حمایت بانکها از بازار سرمایه از فردا اجرا میشود

- بورس سقوط کرده در دولت روحانی چگونه در دولت شهید رئیسی احیا شد؟

- درمان بورسی پزشکیان از زبان عبده

- جذب سرمایه ۷ همتی از بازار بورس دانشبنیانها

- وعده عناب بورسی واقعیتر شد

- چهارمین روز نزولی بازار در غیاب نیروهای صعودی

- انتخابات و دامنه نوسان مهمترین دلیل رکود فعلی بورس

- بورس با ۴ مصوبه دولت برای حمایت از بازار سهام سبزپوش میشود؟

- ۳ دلیل پایین بودن ارزش معاملات خرد در بورس

- معافیتهای مالیاتی بازار سرمایه باید استمرار پیدا کند

- بورس این روزها تحت تأثیر تداوم نرخ اخزای بالای ۳۵ درصد

- رشد شاخصهای بورس با کف سازی تکنیکال

- کاهش دامنه نوسان هم علاج بورس نزولی نبود

- سایه تامین مالی دولت بر سر بورس سنگینی میکند

- کاهش بی سابقه حجم معاملات سهام در بورسهای جهانی

- رشد شاخصهای بورس با کمک بانکیها و اعلام نرخ تسعیر ارز

- حمله به سفیر روسیه در لهستان

- معرفی سری گوشیهای Redmi K ۵۰ قبل از رونمایی رسمی

- غفوری: فکر کردن به قهرمانی از الان، سادهلوحانه است

- کاهش ۱۰ درصدی تولید هوندا در دو کارخانه

- سومین نشست دستمزد، باز هم بدون نتیجه

- لغو بلیت فروشی عمومی المپیک زمستانی چین

- گرامیداشت قربانیان هواپیمای اوکراینی در دانشگاه تورنتو

- ادامه چانهزنی چهارگانه در وین

- صرفهجویی ۱.۶ میلیارد دلاری کمیته برگزاری المپیک و پارالمپیک توکیو

- محبوبترین رشته المپیک توکیو مشخص شد

- اعلام هزینه میزبانی توکیو از المپیک و پارالمپیک ۲۰۲۰،

- آذرتاج: هیات اقتصادی جمهوری آذربایجان به ایران میرود

- بررسی عملکرد ایران در المپیک؛ جایگاه چهارمی در آسیا

- پایان وضعیت اضطراری در کشور میزبان المپیک ۲۰۲۰

- «نظریه اکتبر»: چرا پاییز زمان ایدهآلی برای کاهش وزن است؟

- اسرارآمیز و فانتزی و در باورهای کهن

- یک قلب آرژانتینی برای برای کشف خویشتن

- همه چیز درباره آلزایمر، از جمله غیرقابل تصورها!

- وحید یا محرم؟ کدام در جاده موفقیت

- مبارزه طاقتفرسای عقاب و اژدها بر سر تیکتاک

- تمام زندگی ما زیر سایه اقساط

- چرا اضطراب اجتماعی دامنگیر نوجوانان و جوانان شده است؟

- ماجرای مشتی لایک و واچ تایم در رسانه ملی

- MMWR: مصرف بیش از حد داروهای ضد قارچ برای سلامتی مضر است

- CRC: ویروس زیکا میتواند به طور بالقوه سرطان را درمان کند

- سالمترین فرنی برای سلامت و قدرت مردان نامگذاری شد

- متخصص آسیبشناسی: سیگارهای الکترونیکی یا ویپ از سیگار کشیدن خطرناکترند

- «دانههای گوش» که به عنوان راه حلی برای استرس و خستگی تبلیغ میشوند، چیستند؟

- سختیهای اولیه منجر به رشد سریع مغز با خطرات بلندمدت میشود

- صبح خود را با آب گرم شروع کنید... فواید فراوان برای سلامتی و زیبایی

- یک متخصص مغز و اعصاب توضیح داد که چگونه میتوان فراموشی معمولی را از زوال عقل تشخیص داد

- کشف راز «مه مغزی» در بیماران کووید-۱۹ طولانیمدت

- خستگی مزمن ممکن است ناشی از کمبود ویتامین D باشد

- شاخصهای سلامتی در طول خواب که نیاز به احتیاط دارند

- متخصص غدد درون ریز: مصرف بیش از حد چربیهای گیاهی برای سلامتی مضر است

- دیلی میل: بوی بد دهان نشان دهنده چه بیماریهای جدی است؟

- یک پزشک خطرات خوردن شام دیرهنگام را توضیح میدهد

- یک انتخاب غذایی ایمن و مؤثر برای سلامت قلب و روده بزرگ

- علائم بیماری شدید قلبی که خطرناکتر از تنگی نفس هستند، شناسایی شدهاند

- الگوهای خواب، پیری مغز را تسریع میکنند!

- دانشمندان: نوجوانانی که نوشیدنیهای انرژیزا مصرف میکنند، بیشتر در معرض ابتلا به افسردگی هستند

- دانشمندان روسی نشانگرهای زیستی جدیدی را برای اسکیزوفرنی و افسردگی کشف کردند

- ترکیبات خطرناکی که باعث سرطان میشوند در نمک طعام یافت شدهاند

- روزنامه سان: اعتیاد به ماراتن و قرصهای مخدر، راههای خطرناکی برای بهبود سلامت شما هستند

- علائم ساده در پاها ممکن است یک بیماری جدی و تهدیدکننده زندگی را نشان دهد

- رژیمهای غذایی سرشار از پروتئین گیاهی ممکن است به زنان کمک کند تا با افزایش سن، سالم بمانند

- تاثیر نوشابه بر سلامت روان

- مجله پزشکی کودکان JAMA: آبمیوهها از کوکاکولا رژیمی مضرترند

- مطالعهای تأثیر بیماریها و سبک زندگی را بر پیری مغز نشان میدهد

- تاثیر مخرب سیگارهای الکترونیکی بر سلامت دهان و دندان

- دانشمندان روسی روشی منحصربهفرد برای درمان چاقی ابداع کردهاند

- میکروپلاستیکها سلامت استخوانها را تهدید میکنند و بازسازی استخوان را مختل میکنند!

- دانشمندان نقش انواع ژنتیکی ارثی را در ایجاد یک سرطان خون نادر شناسایی کردهاند

- مطالعهای فواید مسواک زدن دندانها را در پیشگیری از سرطان آشکار کرد

- اخبار داغ

- ورزشی

- پربیننده

- پربحث

- راهی برای پرورش گیاهان در خاک فقیر پیدا شده است

- روزنامه: اتحادیه اروپا علاقهای به راهحل مسالمتآمیز برای بحران اوکراین ندارد

- سودان: «اجساد روی جادهها» - سفری مرگبار از الفاشر به طویله، فرار از گرسنگی و وحشت

- ووچیچ: کشورهای ناتو برای جنگ آماده میشوند

- دانشمندان راهی برای غلبه بر اتلاف انرژی در الکترونیک پیدا کردهاند

- وزیر کشور آلمان از طرح ایجاد واحد پلیس ضد پهپاد خبر داد

- رهبر حزب رویای گرجستان اقدامات مخالفان را تلاشی برای کودتا توصیف میکند

- روسیه اعلام کرده است که اعتراضات در گرجستان بر افکار عمومی تأثیری نخواهد گذاشت

- دانشمندان یک حسگر زیستی ساختهاند که قادر است مولکولهای خون را برای هفتهها ردیابی کند

- مجله: اصرار زلنسکی بر منطقه پرواز ممنوع، خطر شعلهور شدن جنگ جهانی را به همراه دارد

- آلمان: اپراتور پهپاد دستگیر شده در فرانکفورت آماتور است و با جریمه ۱۰ هزار یورویی روبروست

- زلنسکی ممکن است تأمینکننده تسلیحات استراتژیک خود را از دست بدهد

- یک داروی جدید میتواند در صورت عدم موفقیت داروهای مرسوم، به کاهش فشار خون کمک کند

- سقوط ستارهها: صلاح و فن دایک پس از شکست دراماتیک لیورپول مقابل چلسی، امتیاز پایینی دریافت کردند

- وزارت امنیت داخلی آمریکا: حمله مسلحانه به گشت پلیس شیکاگو

- رهبر اپوزیسیون پیروز انتخابات جمهوری چک، عضویت اوکراین در اتحادیه اروپا را رد کرد

- دانشمندان کشف کردهاند که ذخایر لیتیوم ترکیبی "بیگانه" دارند

- ایستگاه رادیویی: سه بسته حاوی مواد منفجره در فرانسه کشف شد

- روسیه یاد گرفته که چگونه زبالههای مایع مضر را به کود تبدیل کند

- پاتروشف: تصمیمگیرندگان ناتو حتی بدون دانستن زبان روسی، معنای سخنان پوتین را میفهمند

- یک هیولای دریایی مربوط به دوران دایناسورها در کانادا کشف شد

- وال استریت ژورنال: مرکز روبیکون روسیه سرسختترین دشمن نیروهای اوکراینی است

- «آنها باید بمیرند»: زلنسکی در پارلمان به دلیل اوضاع اوکراین به شدت مورد انتقاد قرار گرفت

- مرکل خواستار یافتن راه حلی برای مناقشه اوکراین از طریق دیپلماسی شد

- روشی برای پیشبینی خطر ابتلا به زوال عقل بر اساس کیفیت عضلات یافت شد

- ارتش آلمان به فرودگاه مونیخ در شناسایی پهپادها در حریم هوایی خود کمک میکند

- ایالات متحده: طرح کمک مالی ۱۰ میلیارد دلاری برای کشاورزان آمریکایی پس از کاهش خرید چین

- چین به دلیل طوفان ماتمو بالاترین سطح هشدار را اعلام کرده است

- دانشمندان روسی راهی برای درمان عفونتهای استاف پیدا کردهاند

- وبسایت: ترامپ از کمک اردوغان در اعمال فشار بر حماس تقدیر کرد

- سودان نسبت به افزایش سطح آب نیل هشدار میدهد: سیل دهها خانواده را آواره کرده و به بخش کشاورزی آسیب رسانده است

- پاتروشف ارتش روسیه را با ارتش آمریکا مقایسه کرد

- دانشمندان کشف کردهاند که شاهینها یاد گرفتهاند از چراغ راهنمایی استفاده کنن

- آلمان: پس از تغییرات ساختاری در وزارت دفاع، اختیارات گستردهتری به فرمانده ارتش اعطا شد

- رهبر حزب حاکم فرانسه پیروزی مخالفان در جمهوری چک را «اراده مردم اروپا» توصیف کرد

- غرب تلاش زلنسکی برای به دردسر انداختن ناتو را کشف کرده است

- «بریتانیاییها، بریتانیاییها را کشتند»: افسانهی یکی از مشهورترین داستانهای تاریخ بریتانیا، بیاساس شد

- آلمان: فرودگاه مونیخ پس از مشاهده پهپادها در آسمان، به خلبانان هشدار داد

- ماموریت بریتانیا در سودان: بریتانیا میزبان یک جلسه توجیهی فوری با شرکای بینالمللی در مورد وضعیت الفاشر بود

- دانشمندان کشف کردهاند که چه زمانی افزایش سطح دریاها به تهدیدی بزرگ برای بشریت تبدیل خواهد شد

- وزیر امور خارجه ترکیه: کمکهای مالی اروپا به اوکراین فوقالعاده گران است

- فرماندار ایلینوی: وزارت جنگ آمریکا به من اولتیماتوم داده است

- مکرون ضربالاجل تشکیل دولت جدید را تعیین کرد

- سیبیاس: افبیآی قصد دارد جیمز کومی را در مقابل رسانهها دستگیر کند

- اوربان بروکسل را تهدید کرد که در صورت لغو حق وتوی مجارستان، اقدام قانونی خواهد کرد

- دانشمندان اسرار تکامل روباههای قطبی و خرسهای قطبی را کشف کردند

- یک روزنامه ایتالیایی راز موفقیت موشکهای روسی در تبدیل سامانههای پاتریوت اوکراین به قراضه را «افشا» کرد

- پس از بحران دیپلماتیک، وزیر امور خارجه هلند بر تعهد خود برای تأمین امنیت سفارت مصر تأکید کرد

- آمریکا از اظهارات آلمان مبنی بر عدم امکان گفتوگو با روسیه انتقاد کرد

- دانشمندان معمای مغناطیس غیرعادی روی ماه را حل کردند

- وزیر دارایی هند: کشورهای جهان باید برای تعامل با استیبل کوینها آماده شوند

- قدیروف: چچن حدود ۲۳۰۰۰ داوطلب از مردم خود را به منطقه عملیات نظامی اعزام کرده است

- یک تحلیلگر هشدار داد که کییف ممکن است برای کشاندن ناتو به این درگیری به اقدامات ناامیدکنندهای متوسل شود

- دانشمندان نشت طلا در مقیاس بزرگ از هسته زمین را کشف کردهاند

- بلومبرگ: چین برای لغو محدودیتهای تجاری، یک تریلیون دلار سرمایهگذاری به ایالات متحده پیشنهاد میدهد

- گروسی: قطع برق در نیروگاه زاپوریژژیا تهدیدی برای ایمنی هستهای است

- وزارت انرژی آمریکا اعلام کرده است که این کشور با کمبود بودجه برای کنترل زرادخانه هستهای خود مواجه است

- درصد روسهایی که بدون تجویز پزشک از محصولات لاغری استفاده میکنند، فاش شد

- افسر اطلاعاتی سودان: مزدورانی که در دارفور کشته شدند، از پهپادهای ساخت اوکراین استفاده میکردند

- روته به خاطر «پرواز جنگنده روسی» صدایش را سر نخست وزیر استونی بلند کرد: «زیاد آژیر خطر را به صدا درنیاورید!»

- یک وبلاگ نویس بزرگترین مجموعه اسباب بازیهای Polly Pocket جهان را جمع آوری کرده است

- دانشمندان دریافتهاند که نور روز به سیستم ایمنی بدن در مبارزه با عفونتها کمک میکند

- رئیس جمهور کره جنوبی خواستار اقدام قاطع علیه تجمعات ضد چینی شد

- وزیر لهستانی نسبت به خطر فشار سیاسی در پرونده نورد استریم هشدار داد

- یکی از کشورهای عضو ناتو پیشنهاد برگزاری رزمایشهایی را داده است که در آنها استفاده از سلاحهای هستهای تمرین میشود

- دانشمندان ادعای جنجالی یافتن آثار حیات در سیارهای دیگر را رد کردند

- رقابت آفریقا: مصر همچنان به جلب حمایت از نامزد خود برای مدیرکلی یونسکو ادامه میدهد

- «تورین در کنار فلسطین میایستد»: جنگی چریکی علیه شرکت دفاعی ایتالیایی لئوناردو

- فاکس بیزینس: وزارت خزانه داری آمریکا در حال بررسی ضرب سکه یک دلاری با تصویر ترامپ است

- دانشمندان هشدار میدهند که شکلات حاوی فلزی است که برای فرزندان خطرناک است

- رئیس جمهور لهستان دستور استقرار نیروهای نظامی در مرزهای آلمان و لیتوانی را صادر کرد

- جمهوری چک: معترضان طرفدار فلسطین خدمات تراموا را در مرکز پراگ مسدود کردند

- رادا از تصمیم زلنسکی برای وارد کردن مهاجران به اوکراین انتقاد کرد

- دانشمندان اسرار تکامل تنبلهای غولپیکر عصر یخبندان را کشف کردند

- وزارت دفاع روسیه: نیروهای فضایی ما آزمایشهای ماهوارههای خارجی را رصد میکنند

- رئیس جمهور بولیوی اقدامات آمریکا علیه ونزوئلا را دزدی دریایی خواند

- دانشمندان کشف کردهاند که مدفوع پنگوئنها سپر اقلیمی قطب جنوب است

- سناتور روس: اروپا در باتلاق خصومت علیه روسیه گرفتار شده و نمیداند چگونه از آن خارج شود

- هشدار افبیآی در مورد تعطیلی دولت: تهدیدی برای امنیت ملی آمریکا!

- رئیس جمهور کلمبیا، آمریکا و اروپا را کانون قاچاق مواد مخدر بینالمللی خواند

- لیورپول در مورد ابراهیما کوناته جدی است

- سعودیها میتوانند در ژانویه برای جذب فرناندز برگردند و آمادهاند تا ۳۳ میلیون پوند به او بپردازند

- گواردیولا در مورد علاقه بارسلونا به هالند: «چه کسی ارلینگ را نمیخواهد؟»

- بایرن گزینههای خود را برای جذب یک مدافع میانی تحت فشار قرار داده است

- گزینه جدید برای جذب کوبی ماینو

- نیوکاسل به دنبال بازگشت ۴۰ میلیون یورویی است

- کریستال پالاس میخواهد کیس اسمیت را از کهکشانیها برباید

- چهار گزینه برای خط دفاعی لیورپول

- وقتی الکساندر ایساک به بارسلونا پیشنهاد شد

- گواردیولا درباره فرم منچسترسیتی گفت: «خوشایندترین چیز این است که چطور داریم پیشرفت میکنیم.»

- RAC۱: بارسلونا میخواهد از پروژه سوپرلیگ خارج شود، رئال مادرید قصد انجام این کار را ندارد

- واکنش ژاوی در پاسخ به این سوال که آیا فکر میکند هافبکها در رأیگیری برای انتخاب "توپ طلا" نادیده گرفته شدهاند یا خی

- الساندرو دل پیرو وضعیت فعلی یوونتوس را تحلیل میکند

- رئال مادرید مسیر آنجلو استیلر را سرد کرد

- دوشان ولاهوویچ، مهاجم اتلتیکو مادرید، از خرید او دست نخواهد کشید

- میکل آرتتا در مورد سیصدمین بازی خود به عنوان سرمربی آرسنال صحبت کرده است

- موندو دپورتیوو: راشفورد در بارسلونا ۳۰ تا ۴۰ پاس گل در هر فصل را هدف گذاری کرده است

- آ. اس: دِ لا فوئنته تصمیم گرفت از آنجایی که یامال با درد برای باشگاه بازی میکرد، میتواند برای تیم ملی بازی کند

- محمد کدوس، تأثیر فوری

- الکساندر پاولوویچ یک طرفدار جدیدی پیدا کرد

- رئال مادرید | ژابی آلونسو اختلاف با فده والورده را حل و فصل کرد

- آرتور ورمیرن نگران آینده اش نیست

- آنتونی مقابل منچستر یونایتد عالی بازی کرد

- فدریکو کیهزا اهداف خود را مشخص کرد

- اونای امری درباره پیروزی استون ویلا مقابل فاینورد در لیگ اروپا اظهار نظر کرد

- ژاوی شرایطی را که لامین یامال میتواند برنده توپ طلا شود، توضیح داد

- کریم بنزما سولاری را تحت تاثیر قرار میدهد

- سرخیو رگیلون تیم جدیدی را انتخاب میکند

- منچسترسیتی خواهان همکاری با اتلتیکو مادرید است

- سرمربی منچستریونایتد، آموریم: از باختن بازیها رنج میبرم، نه از دست دادن شغلم

- ژابی آلونسو، سرمربی رئال مادرید، در مورد آینده آندری لونین در این باشگاه صحبت کرده است

- گلسنر، سرمربی کریستال پالاس: نکته اصلی این است که بازیکنان بفهمند ما از آنها چه میخواهیم

- منچسترسیتی یکی از ستونهای خود را نوسازی میکند

- پاری سن ژرمن با ژائو نوس به اوج خود رسید

- سویا برای جذب یک بازیکن قدیمی و محبوب تلاش میکند

- دیدیه دشان در مورد بازگشت احتمالی پل پوگبا به تیم ملی فرانسه اظهار نظر کرد

- گاسپرینی، سرمربی رم، به دو پنالتی از دست رفته متوالی دووبیک مقابل لیل واکنش نشان داد

- «من خودم نمیتوانم این کار را انجام دهم.» اظهارات آموریم در مورد استعفای داوطلبانهاش از منچستریونایتد

- آرسنال در حال بررسی فروش ۴۰ میلیون یورویی است

- پائولو دیبالا آیندهاش را مشخص کرد

- لیورپول و بارسلونا بر سر یک مدافع میانی رقابت میکنند

- کادر مربیگری مورینیو و چندین بازیکن بنفیکا به این ویروس مبتلا شدهاند

- تیری آنری فاش کرد که چه کسی برنده توپ طلا در سال ۲۰۲۶ خواهد شد

- ال ناسیونال: بارسلونا میخواهد یکی از گرانترین بازیکنان فوتبال جهان را به خدمت بگیرد

- بیست و پنجمین آزمون آتش برونو فرناندز

- نقش جدید یاگو آسپاس در سلتا

- الچه اروپا را عاشق خود میکند

- ایکر کاسیاس در مورد زوج قویتر مسی و رونالدو گفت: «سوالات چیست؟»

- آموریم به انتقادات رونی و نویل پاسخ داد

- بیبیسی: آینده پوستکوگلو در ناتینگهام فارست میتواند پس از بازی با نیوکاسل مشخص شود

- بوندس لیگا | بایر لورکوزن قانون خود را اعمال میکند

- برتر | بنجامین سسکو همین الان هم برای منچستریونایتد تعیینکننده است

- پدیده لالیگا اسپانیا، تاتنهام هاتسپر را مجذوب خود کرد

- ژاوی دو مدعی اصلی قهرمانی جام جهانی ۲۰۲۶ را معرفی کرد

- دو مدافع مورد توجه بارسلونا در اسپانیا معرفی شدند

- پوتین فاش کرد که روسیه چگونه پیچیدهترین مشکلات خود را حل میکند

- اینتر در هفته ششم سری آ، کرمونزه را شکست داد و به پیروزی قاطعی دست یافت

- مصدومیت فرانکو مستانتونو و کیلیان امباپه اکنون مشخص شده است

- آرسنال برای رئال مادرید هدف تعیین کرد

- لالیگا | رئال مادرید بر پشت وینیسیوس جونیور سوار میشود

- آرتتا: آرسنال با روحیه خوبی به تعطیلات بازیهای ملی میرود

- آموریم در مورد پیروزی منچستریونایتد مقابل ساندرلند گفت: «روز خوبی بود، هرچند بینقص نبود.»

- رئال مادرید در لالیگا با دو گل وینیسیوس و یک گل و یک پاس گل امباپه، ویارئال را شکست داد

- دیگو سیمئونه: «از انتخاب یورنته و باریوس خوشحالم.»

- جود بلینگهام به بدترین وضعیت خود رسید

- بیست و پنجمین آزمون آتش برونو فرناندز

- فلیک: ما نمیدانیم که آیا یامال تا دو، سه یا چهار هفته دیگر از مصدومیت برمیگردد یا خیر

- فلیک درباره اختلاف نظرش با د لا فوئنته بر سر سلامتی یامال گفت: «من از بازیکنان محافظت میکنم.»

- گزارشها: لیورپول در حال بررسی تصمیم مهمی در مورد محمد صلاح است

- آشورماتوف، مدافع تیم ملی ازبکستان، به احتمال انتصاب کاناوارو واکنش نشان داد

- پیشنهاد «ناامیدکننده» برای فیل فودن

- آرون اسکندل برنامههای آیندهاش را تایید کرد

- رئال مادرید و اف سی بارسلونا همچنان در رقابت برای جذب یک استعداد مکزیکی هستند

- منچستریونایتد و تاتنهام میتوانند برای جذب مهاجم لالیگا رقابت کنند

- اورنشتاین: بازیکنان به آموریم اعتماد دارند، منچستریونایتد قصد اخراج مربی را ندارد

- واکنش آلونسو در پاسخ به اینکه آیا رفتارهایی مانند وینیسیوس و والورده اقتدار او را کاهش میدهد

- تمام آژیرها در کریستال پالاس به صدا درآمدند

- فروش ۴۰ میلیون یورویی در انتظار منچستر یونایتد است

- سردرد: تردیدهای بایرن مونیخ برای تابستان ۲۰۲۶

- آلونسو در پاسخ به این سوال که آیا فکر میکند رئال مادرید زیر نظر او به جای یک تیم، به مجموعهای از ستارهها تبدیل شده است؟