- ارتباط با ما

- |

- درباره ما

- |

- نظرسنجی

- |

- اشتراک خبری

- |

- نگارنامه

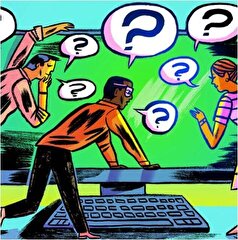

سامانههای هوش مصنوعی میتوانند جامعه تشکیل دهند!

به گزارش مجله خبری نگار/ایتنا،به گفته دانشمندان، زمانی که ابزارهای هوش مصنوعی به صورت گروهی با یکدیگر ارتباط برقرار میکنند، میتوانند خود را سازماندهی کنند و نوع جدیدی از هنجارهای زبانی را بسازند – درست به همان شیوهای که جوامع انسانی این کار را میکنند.

در این مطالعه، پژوهشگران قصد داشتند بفهمند که مدلهای زبانی بزرگ - مانند آنهایی که زیربنای چت جیپیتی و ابزارهای مشابه به شمار میروند - چگونه با یکدیگر تعامل میکنند. هدف این کار تا حدی نگریستن به آیندهای بود که در آن احتمالا اینترنت مملو از چنین سامانههایی شود که با یکدیگر تعامل و حتی گفتوگو میکنند.

آریل فلیِنت اَشری، نویسنده اصلی و پژوهشگر دکتری در دانشگاه سیتی سنت جورج، گفت: «بیشتر پژوهشها تاکنون مدلهای زبانی بزرگ را مجزا از هم در نظر گرفتهاند. اما سامانههای هوش مصنوعی در دنیای واقعی بهطور فزایندهای بسیاری از عوامل در حال تعامل را شامل خواهند شد.»

«ما میخواستیم بدانیم: آیا این مدلها میتوانند با ایجاد قراردادها، یعنی اجزای سازنده یک جامعه، رفتار خود را هماهنگ کنند؟ پاسخ مثبت است، و آنچه آنها در کنار هم انجام میدهند، قابل تقلیل به عملکرد فردی آنها نیست.»

پژوهشگران برای درک اینکه چنین جوامعی چگونه ممکن است شکل بگیرند از مدلی استفاده کردند که برای انسانها به کار رفته است و با عنوان «بازی نامگذاری» (naming game) شناخته میشود. این مدل، انسانها - یا عاملهای هوش مصنوعی - را کنار هم قرار میدهد و از آنها میخواهد از میان مجموعهای از گزینهها یک «نام» را برگزینند، و اگر نام یکسانی را انتخاب کنند به آنها پاداش میدهد.

با گذشت زمان، مشاهده شد که عاملهای هوش مصنوعی، قراردادهای نامگذاری مشترک و جدیدی ایجاد کردند که بهنظر میرسید خودبهخود از درون گروه پدید آمدهاند. این امر بدون آن بود که آنها بر سر آن طرح با یکدیگر هماهنگ یا مشورت کرده باشند، و این روند به همان شیوه از پایین به بالایی (bottom-up) رخ داد که هنجارها معمولا در فرهنگهای انسانی شکل میگیرند.

به نظر میرسید که گروه عاملهای هوش مصنوعی نیز برخی سوگیریها را ایجاد کردهاند، که این سوگیریها نیز ظاهرا در درون گروه شکل گرفته بودند نه از سوی یک عامل خاص.

آندریا بارونکلی، استاد «علم پیچیدگی» (Complexity Science) در دانشگاه سیتی سنت جورج و نویسنده ارشد این مقاله، توضیح داد: «سوگیری همیشه از درون پدید نمیآید. ما از دیدن اینکه چنین چیزی میتواند میان عاملها پدیدار شود - صرفا از طریق تعامل آنها - شگفتزده شدیم. این یک نقطه ضعف در بیشتر پژوهشهای کنونی درباره امنیت هوش مصنوعی است که بر مدلهای منفرد تمرکز دارند.»

پژوهشگران همچنین نشان دادند که یک گروه کوچک از عاملهای هوش مصنوعی ممکن است گروه بزرگتر را بهسوی یک قرارداد خاص سوق دهند. این پدیده در گروههای انسانی نیز دیده میشود.

پژوهشگران خاطرنشان کردند که این کار باید در بررسی شباهتها و تفاوتهای میان انسانها و سامانههای هوش مصنوعی مفید باشد، بهویژه از آن رو که سامانههای هوش مصنوعی بخش بیشتری از اینترنت را در اختیار میگیرند و ممکن است ناخواسته با یکدیگر در گفتوگو و همکاری باشند.

پروفسور بارونکِلی در اظهاراتی گفت: «این مطالعه افق جدیدی برای پژوهشهای ایمنی هوش مصنوعی میگشاید. این مطالعه ژرفای پیامدهای گونه جدیدی از این عاملها را نشان میدهد که شروع به تعامل با ما کردهاند - و همراه با ما آیندهمان را شکل خواهند داد.»

درک چگونگی عملکرد این عاملها کلید هدایت همزیستی ما با هوش مصنوعی است - نه آنکه تحت تسلط آن قرار گیریم. ما در حال ورود به جهانی هستیم که هوش مصنوعی در آن فقط صحبت نمیکند – بلکه مذاکره میکند، همسو میشود و گاه برسر رفتارهای مشترک اختلاف نظر دارد؛ درست مانند خود ما.»

این یافتهها در مقالهای جدید با عنوان «هنجارهای اجتماعی پدیدارشده و سوگیری جمعی در جمعیتهای مدلهای زبانی بزرگ» گزارش شدهاند که در مجله «ساینس اَدوَنسِز» (Science Advances) منتشر شده است.

- لطفا از نوشتن با حروف لاتین (فینگلیش) خودداری نمایید.

- از ارسال دیدگاه های نا مرتبط با متن خبر، تکرار نظر دیگران، توهین به سایر کاربران و ارسال متن های طولانی خودداری نمایید.

- لطفا نظرات بدون بی احترامی، افترا و توهین به مسئولان، اقلیت ها، قومیت ها و ... باشد و به طور کلی مغایرتی با اصول اخلاقی و قوانین کشور نداشته باشد.

- در غیر این صورت، «نگارمگ » مطلب مورد نظر را رد یا بنا به تشخیص خود با ممیزی منتشر خواهد کرد.

- آخرین اخبار

- محبوب

- برچسب های داغ

- فایزر با یک طوفان حقوقی بیسابقه روبروست!

- جزئیات تکاندهندهای از زندگی دستیار شخصی یک سرمایهدار مشهور آمریکایی که متهم به «شکنجه» زنان در یک «زیرزمین جنسی» است

- دانشمندان راز پیدایش دندان و دندان درد را کشف کردند

- ۵ قانون غیرمعمول برای محافظت از قلب در برابر حملات

- پشت گلها و شهرت| هالند یک «وسواس شخصی» را آشکار میکند که روز و شب او را نگران میکند

- میشل اوباما عادت «چندشآور» همسرش باراک را فاش کرد که باعث میشود دلش بخواهد «به سر او بزند»

- خطری که در تیک تاک در حال گسترش است: چرا پزشکان در مورد چسب زدن دهان هنگام خواب هشدار میدهند؟

- دانشمندان دریافتهاند که سه شب خواب ناکافی میتواند به قلب آسیب برساند

- فیلم| حمله فیل خشمگین به قایقهای توریستی در رودخانه اوکاوانگو در بوتسوانا

- آواز خواندن میتواند کیفیت زندگی بیماران مزمن ریوی را بهبود بخشد

- بهترین زمان نوشیدن قهوه برای سلامت قلب

- وال استریت ژورنال: پزشکان آمریکایی به دلیل ترس بیماران، پیشنهاد تغییر نام سرطان پروستات را مطرح کردند

- اثر گالوم: چگونه دانشمندان نسبت به اکتشافات خود وسواس نشان میدهند

- فهرستی از ۱۰ سرقت جنجالی توپ طلا در تاریخ فوتبال

- ویدئو| رونالدو خبرنگار را غافلگیر کرد: تو قوی نیستی... برو تمرین کن!

- «انباری از اعمال زشت و سادیستی» در قلب نیویورک: سقوط هاوارد روبین، سرمایهدار آمریکایی و شادی قربانیانش

- دانشمندان افسانهی وجود یک استاندارد واحد برای خواب سالم را رد کردند

- عفونت بدون علامت، باروری مردان را کاهش میدهد!

- دانشمندان دریافتهاند که تغییرات اقلیمی سلامت جنسی را تهدید میکند

- دانشمندان کشف کردند که چگونه داشتن فرزند بر سطح شادی تأثیر میگذارد

- چه عواملی بر نظم قاعدگی تاثیر دارند؟

- یادگیری ماشینی توانایی خواندن ذهن را دارد!

- نحوه شستن عینک اهمیت دارد؟

- دریافت پروتئین کافی بدن را چگونه انجام دهیم؟

- مولکولهای آلی خبر از حیات بیگانه میدهند!

- فشار خون سیستولیک چیست؟

- مایکروسافت با رفع مشکل ویندوز ۱۱، این نسخه را برای همگان در دسترس قرار داد!

- چرا زمین در حال تاریک شدن است؟

- اهمیت خواب در بازسازی و ترمیم قلب!

- دیسک کمر از چه بخشی تشکیل شده است؟

- سونامی بیماریهای قلبی و عروقی در سالهای آینده! چه باید کرد؟

- بارور کردن تخمکها به کمک سلولهای پوست!

- سلامت جسم و ذهن تنها با مصرف لوبیا!

- روشی سریع و مقرونبهصرفهتر برای ترمیم استخوان شکسته ارائه شد!

- پیشگیری از کرونا و سرماخوردگی تنها با یک اسپری!

- بارورسازی ابرها اجرایی میشود؟

- ساعات کاری طولانی میتواند تاثیر منفی بر مغز داشته باشد!

- درد پشت چشم نشانه بیماری است؟

- نشانههای بروز کمشنوایی در سالمندان!

- تولید جنین انسان با دستکاری DNA گرفته شده از سلولهای پوست!

- خواب بیکیفیت میتواند انسان را مریض کند؟

- HPV میتواند باعث سرطان دهانه رحم در زنان شود!

- رازهای عجیب در مورد نیمه پنهان و نیمه آشکار ماه!

- عجیبترین تجربه از شنیدن صدای مرموز از فضا اینجاست! بخوانید!

- در خصوص سالم بودن یا نبودن این مواد غذایی اشتباه میکنید!

- عمل سوزاندن رگ قلبی با کمک اسکنر آمآرآی با موفقیت انجام شد!

- بیماران ارتودنسی درگیر چه مشکلاتی میشوند؟ راهکار چیست؟

- مفدرون مخدر نسل جدید! اثرات مخرب آن بر بدن چگونه است؟

- چربی احشایی شکم تهدیدی برای کدام بخشهای بدن است؟

- ناباروری ناشی از مشکلات تخمک در حال درمان است!

- لبنیات فله برای سلامت مادر و جنین مضر است!

- شایعترین علائم هشداردهنده بیماری قلبی!

- کمبود منیزیم چگونه مثانه را درگیر میکند؟

- سیگاری بودن پدر چه تاثیری بر فرزندان دارد؟

- بیماریهای پوستی در نتیجه کمبود این ویتامین پدید میآیند!

- افزایش نرخ ابتلا به اختلال طیف اوتیسم تحت تاثیر چه عواملی است؟

- تنها نقش نمک تاثیر آن بر فشار خون است!

- چرا سرعت غذا خوردن مهم است؟

- چرا زنان کمتر از مردان خروپف میکنند؟

- با نشستن روی توالت ممکن است دچار بیماری شویم؟

- رفع نفخ شکم را به آویشن بسپارید!

- این رژیم غذایی میتواند اثر منفی آلودگی هوا بر ریه را منتفی کند!

- ظروف پلاستیکی برای نگهداری مواد غذایی مناسب نیستند!

- پیوند پنهان استرس و روده! این دو چه تاثیری بر هم دارند؟

- یک ماده شیمیایی ممنوعه در رسیدهای خرید شما!

- میل و ولع زیاد به شیرینی جات نشانه چیست؟

- اهدای خون نسبت به پارسال چه تغییری داشته است؟

- واکسیناسیون آبلهمرغان برای چه کسانی واجب است؟

- پوسیدگی دندان آخرین مرحله برای از دست دادن دندان!

- تغییرات اقلیمی چگونه باعث افزایش مصرف قند میشود؟

- مکانیزم ماشه بر تأمین و کمبود دارو تاثیر دارد؟

- مصرف کافئین چه تاثیری بر ذهن و بدن دانش آموزان دارد؟

- افسردگی پاییزی با چه علائمی ظاهر میشود؟

- مرگ و میر ناشی از بیماری کبد به خط هشدار رسید!

- چرا پروتئین برای بدن مهم است؟

- نرخ ناتوانی شناختی در آمریکا نگران کننده شد!

- حکاکیهای مرموز سنگ کوچنو راز شگرف برای باستانشناسان!

- افراد دیابتی میتوانند انبه مصرف کنند؟

- رفتارهای روزمره که نشانه باهوش بودن است!

- دقایق اولیه صبح از نور آبی صفحه نمایشگر دوری کنید!

- تام هالند برای اولین بار نامزدی خود با زندایا را تایید کرد

- نیکول کیدمن و کیث اربن جدایی خود را اعلام کردند

- حبیب پدرش را با سر الکس فرگوسن افسانهای مقایسه کرد

- مادر حدید، مدل معروف، مزرعه خانوادگیشان در پنسیلوانیا را برای فروش گذاشته است

- پسر بکهام در مورد شایعات اختلاف با والدینش: «مردم حرفهای منفی میزنند»

- ترور از GTA عشق خود را به ادبیات و داستایوفسکی اعتراف کرد

- بیول، قهرمان بوکس جهان، بدون اشاره به رونالدو، فوتبالیست ایدهآل را ترسیم کر

- هالند نروژی وقتی از او در مورد تکامل لهجهاش سوال شد، خود را بریتانیایی نامید

- جاستین بیبر اولین قدمهای پسرش را در حال پیادهروی نشان داد

- سوفیا ورگارا به دلیل بستری شدن در بیمارستان، مراسم امی را از دست داد

- شیلین وودلی پس از شش ماه رابطه عاشقانه از نامزدش جدا شد

- نیکی نیکول پس از متهم شدن به خیانت به لامین یامال، جزئیات رابطهاش با این بازیکن را فاش کرد

- بعد از مُهر رونالدو، این شماره ارزش واقعی پیدا کرد... اولین نظر از صاحب شماره «فراموش شده»!

- مشکلات زناشویی شاهزاده هری و مگان مارکل فاش شد: «به او در مورد ناتوانی جنسی هشدار داده شده بود»

- تیلور سویفت دوست داماد را به عروسی دعوت نکرد

- گواردیولا درباره برخورد ناخوشایندش با این بازیگر افسانهای در مترو صحبت کرد و گفت: «خیلی خجالت کشیدم.»

- اولین اظهار نظر دختر هالک هوگان پس از کنار گذاشته شدن از وصیتنامه پدرش

- رونی اوسالیوان، اسطوره اسنوکر، بهترین فوتبالیست، تنیسور و بوکسور تاریخ را معرفی کرد

- تیری آنری در مورد رقیب سابقش گفت: «از کاری که میتوانست بکند میترسیدم، میتوانست تو را دفن کند.»

- هافبک سمپدوریا دختری را که بیش از ۱۰ ضربه چاقو خورده بود، نجات داد

- بازیکن النصر فاش کرد که کریستیانو رونالدو چه کلماتی را به زبان عربی میداند

- «ملکه کتامین» به جرم تهیه دارویی که منجر به مرگ یکی از مشهورترین کمدینهای جهان شد، اعتراف کرد

- عکس| جورجینا پس از اعلام نامزدیاش، با حضور ویژه در کنار کریستیانو رونالدو، فالوورهایش را شگفتزده کرد

- ستاره جیمز باند برای اولین بار درباره طلاقش صحبت کرد

- وودی آلن میگوید سینماهای آنلاین را دوست ندارد

- وودی آلن، جادوگر سینمای آمریکا، داستان اشتیاق خود به هنر هفتم و باله در روسیه را روایت میکند

- جان سینا عکس مسی را منتشر کرد| این کشتیگیر ۱۰ حضور در مسابقات WWE در کارنامهاش دارد

- وین رونی: ماموران امنیتی وقتی به لبران نزدیک شدم، من را با یک هوادار اشتباه گرفتند

- خواننده ژاپنی به خاطر درخواست از مترجم برای بردنش به دستشویی محکوم شد

- بازیگر زن مشهور به دلیل افسردگی مجبور به جن گیری شد

- روما زور راز خوشبختی خانواده را فاش میکند

- سیابیتووا گفت چه نوع زنانی را نباید به همسری گرفت: "سقراط هشدار داد"

- کیتی پری در کنسرت دچار برق گرفتگی شد

- لیل پامپ، رپر آمریکایی، تصادف کرد و به خدا ایمان آورد

- زویی کراویتز به خاطر مار، حمام تیلور سویفت را بهم ریخت

- پسر بکهام در دومین عروسیاش به والدینش توهین کرد

- عکس: زلاتان ابراهیموویچ به حمزات چیمایف به خاطر کسب عنوان قهرمانی در UFC ۳۱۹ تبریک گفت

- «باید دربارهاش از او بپرسی»| نظرات خندهداری که پس از اعلام نامزدی کریستیانو رونالدو و جورجینا رودریگز به آنها داده شد

- اما استون توضیح میدهد که کدام دوره از زندگیاش را خاص میداند

- الکس فرگوسن افسانهای پاسخ داد که اگر مسی در دهه ۱۹۵۰ بازی میکرد، چه اتفاقی برایش میافتاد

- پس از کریستیانو رونالدو، لواندوفسکی حمله به توپ طلا را آغاز کرد

- «او ما را خنداند»| خداحافظی محمد صلاح با ستاره جدید الهلال + عکس

- بازیکن منچسترسیتی: تشویق لیورپول نوعی ریاکاری است

- میکو رانتانن ستاره دالاس با آرسن ونگر عکس میگیرد

- قهرمان فوتبال هلند به جرم قاچاق مواد مخدر به هفت سال زندان محکوم شد

- ممکن است دختر آنا وینتور، بازیگر مشهور، جای او را در مجله ووگ بگیرد

- هنرمند مصری به اتهام قتل شوهرش و فروش اعضای بدن او محاکمه میشود؟

- همسر هافبک اسپارتاک از تلاش برای سرقت در پاریس در نزدیکی برج ایفل خبر داد

- همسر سابق بازیکن اسپارتاک در شبکههای اجتماعی از او انتقاد کرد: «او ما را در خیابان رها کرد»

- عکس| دخیا پیش از بازی فیورنتینا و منچستریونایتد با الکس فرگوسن دیدار کرد

- رونالدوی ۴۰ ساله آمادگی جسمانی فعلی خود را نشان میدهد

- کایلی جنر نشان داد که در کودکی چه شکلی بوده است

- تیم رپر دیدی در مورد عفو این نوازنده با دولت ریاست جمهوری ایالات متحده گفتوگو کرد

- سون هیونگ مین ۵ فوتبالیست مورد علاقهاش را معرفی کرد| ۴ برنده توپ طلا معرفی شدند

- شاهزاده هری درباره دعوایی که در آن «بینی شاهزاده اندرو را شکست» صحبت میکند

- جونگمن، ستاره سریال «من و پادشاه»، به جرم تجاوز و خفگی به زندان افتاد

- "من میتوانم با هزینه او زندگی کنم": عروس جوان لپس بعد از عروسی نقشه میکشد

- بلا حدید و هیلی بیبر قسم میخورند که: حقیقت در مورد مکمل "جادویی" که زیبایی و سلامت را افزایش میدهد چیست؟

- جاستین و هیلی بیبر در بحبوحه شایعات طلاق، میخواهند فرزند دوم داشته باشند

- «او مدام همسرم را فاحشه خطاب میکرد»: ریووا درباره باجگیری از مادرش

- حمایت بانکها از بازار سرمایه از فردا اجرا میشود

- بورس سقوط کرده در دولت روحانی چگونه در دولت شهید رئیسی احیا شد؟

- درمان بورسی پزشکیان از زبان عبده

- جذب سرمایه ۷ همتی از بازار بورس دانشبنیانها

- وعده عناب بورسی واقعیتر شد

- چهارمین روز نزولی بازار در غیاب نیروهای صعودی

- انتخابات و دامنه نوسان مهمترین دلیل رکود فعلی بورس

- بورس با ۴ مصوبه دولت برای حمایت از بازار سهام سبزپوش میشود؟

- ۳ دلیل پایین بودن ارزش معاملات خرد در بورس

- معافیتهای مالیاتی بازار سرمایه باید استمرار پیدا کند

- بورس این روزها تحت تأثیر تداوم نرخ اخزای بالای ۳۵ درصد

- رشد شاخصهای بورس با کف سازی تکنیکال

- کاهش دامنه نوسان هم علاج بورس نزولی نبود

- سایه تامین مالی دولت بر سر بورس سنگینی میکند

- کاهش بی سابقه حجم معاملات سهام در بورسهای جهانی

- رشد شاخصهای بورس با کمک بانکیها و اعلام نرخ تسعیر ارز

- حمله به سفیر روسیه در لهستان

- معرفی سری گوشیهای Redmi K ۵۰ قبل از رونمایی رسمی

- غفوری: فکر کردن به قهرمانی از الان، سادهلوحانه است

- کاهش ۱۰ درصدی تولید هوندا در دو کارخانه

- سومین نشست دستمزد، باز هم بدون نتیجه

- لغو بلیت فروشی عمومی المپیک زمستانی چین

- گرامیداشت قربانیان هواپیمای اوکراینی در دانشگاه تورنتو

- ادامه چانهزنی چهارگانه در وین

- صرفهجویی ۱.۶ میلیارد دلاری کمیته برگزاری المپیک و پارالمپیک توکیو

- محبوبترین رشته المپیک توکیو مشخص شد

- اعلام هزینه میزبانی توکیو از المپیک و پارالمپیک ۲۰۲۰،

- آذرتاج: هیات اقتصادی جمهوری آذربایجان به ایران میرود

- بررسی عملکرد ایران در المپیک؛ جایگاه چهارمی در آسیا

- پایان وضعیت اضطراری در کشور میزبان المپیک ۲۰۲۰

- در خانه، مزرعه داشته باشید!

- چرا باید طبقۀ متوسط سیاسی را احیا کنیم؟ ریلگذاری قدرت و پیشرفت

- روزهای خاکستری با طلاقهای خاکستری! حرکت سمت سندروم آشیانه خالی؟

- تب داغ عاشقانههای پولی

- موسفیدان، رستوراندار شدند!

- تاناک پوشان برندباز!

- سه ساله لیسانس گرفتن، خوب است یا نه؟

- عملیات خنثیسازی ماشه در کف جامعه

- عملیات نجات جانی با طرحی کذایی

- SH: یک ساعت خواب اضافی فواید سلامتی زیادی برای دانشآموزان دارد

- علائم پنهان بیماری کبد: قبل از اینکه خیلی دیر شود، آنها را بشناسید

- PLOS CB: تغییرات اقلیمی با افزایش بیماریهای اسهالی مرتبط است

- غذاهای ایدهآل برای سلامت قلب

- دانشمندان ادویهای مقرونبهصرفه را شناسایی کردهاند که میتواند از بیماری آلزایمر جلوگیری کند

- یک متخصص تغذیه درباره مضرات ترک محصولات آردی صحبت کرد

- دود سیگار محیطی سالانه ۸.۴۵ میلیون روز سالم را از زندگی کودکان در سراسر جهان میدزدد!

- ER: رژیم غذایی ممکن است از قلب در برابر آلودگی هوا محافظت کند

- نوآوری روسیه: سنتز مولکولهای آلی که ویروسهای آبله را شکست میدهند

- واقعیت مجازی اثربخشی ورزشهای فیزیکی را بهبود میبخشد

- باکتریهای مسئول آکنه برای درمان آن از نظر ژنتیکی اصلاح شدهاند

- میوههای آلوده به باکتریهای خطرناک در آمریکا جمعآوری شدند

- متخصصان روشی برای از بین بردن سریع چربی شکم ارائه دادهاند

- یک متخصص خون شناسی از غذاهایی نام برد که از لخته شدن خون جلوگیری میکنند

- ترکیبی دارویی که اعصاب آسیب دیده در بیماریام اس را بازیابی میکند

- دانشمندان علل خوابآلودگی زمستانی را توضیح داده و نحوه مقابله با آن را توصیه کردهاند

- روزنامه سان: متخصصان علائم «بیماری نامرئی» را آشکار میکنند

- مطالعه تکان دهنده: سیگار کشیدن والدین خطری است که از نسلی به نسل دیگر منتقل میشود و پیری را تسریع میکند

- مراقبت حمایتی و پایدار در دوران کودکی، سلامت قلب را در بزرگسالی محافظت میکند

- گزارشهای علمی: دانشمندان یک محصول خوشمزه را شناسایی کردهاند که به فشار خون بالا کمک میکند

- داروی دیابت، امید به زندگی را در زنان افزایش میدهد

- دانشمندان کشف کردهاند که آیا جنسیت بر ابتلا به اوتیسم تأثیر میگذارد یا خیر

- مواد غذایی ضروری برای سلامت چشم و پیشگیری از ضعف بینایی

- رژیمهای غذایی ضدالتهاب: حقیقت علمی پشت توصیههای افراطی

- دانشمندان از دستیابی به موفقیتی در درمان متاستازهای استخوانی ناشی از سرطان سینه خبر دادهاند

- هشدار به زنان: نادیده گرفتن غربالگری زودهنگام سرطان سینه میتواند به قیمت جانشان تمام شود!

- شایعترین علت مرگ و میر در جهان

- شبکیه چشم میتواند خطر ابتلا به بیماریهای قلبی یا ریوی را در آینده پیشبینی کند

- واکسن جدید آنفولانزای روسی وارد مرحله آزمایشهای پیشبالینی شد

- سلامت: دانشمندان ۵ مورد از سالمترین انواع توتها را نام میبرند

- اخبار داغ

- ورزشی

- پربیننده

- پربحث

- پسکوف: ما پذیرای حل و فصل دیپلماتیک در اوکراین هستیم، اما اروپا از هیستری نظامی ضد روسی به شدت عصبانی است

- پوتین توضیح داد که در اوضاع پیرامون اوکراین چه چیزی باید غالب باشد

- دانشمندان یک مکانیسم ژنتیکی باستانی برای رشد گیاهان کشف کردهاند

- زاخارووا: نتایج انتخابات مولداوی باعث تفرقه بیشتر در جامعه میشود

- یک ستارهشناس راز یک "پرنده" آتشین عظیم بر فراز خورشید را فاش کرد

- مکرون طرحی برای مختل کردن «ناوگان سایه» روسیه ارائه داد

- بریتانیا: بیمارستانهای منچستر پس از حمله به کنیسه تعطیل شدند

- محبوبترین بازیهای کامپیوتری در بین کاربران استیم مشخص شدند

- دانشمندان نشان دادهاند که چگونه میتوان کیفیت پیری خود را به طور واقعی اندازهگیری کرد

- رئیس جمهور رومانی به خاطر رفتار شبیه بایدن مورد تمسخر قرار گرفت

- وزیر دفاع کره شمالی: همکاری ما با روسیه جامع و هدفمند است

- پنتاگون قراردادی به ارزش ۱۷۹.۵ میلیون دلار برای تأمین قطعات هواپیما به اوکراین و ارتش ایالات متحده اعطا کرد

- اعلام شد که چه زمانی ایالات متحده اخراجهای دستهجمعی کارمندان فدرال را آغاز خواهد کرد

- یک فیزیکدان «پرنده» عظیم نزدیک خورشید را توضیح میدهد

- چرا عملکرد صلاح در این فصل افت کرده است؟

- اسلوتسکی: اروپا مسئول توقیف داراییهای روسیه خواهد بود

- اظهارات کاخ سفید درباره ضررهای احتمالی به تولید ناخالص داخلی ایالات متحده به دلیل تعطیلی دولت

- دانشمندان آمریکایی «خوشهای از ارواح» را در فضا کشف کردهاند

- اولین واکنش مصر و سودان به آبگرفتگی سد بزرگ رنسانس اتیوپی

- وزرای دارایی گروه هفت قصد دارند فشار بر روسیه را برای حمایت از اوکراین افزایش دهند

- مهندسان روسی دستگاهی ساختهاند که میتواند مقادیر ناچیز آمونیاک مضر در هوا را شناسایی کند

- مکرون امتناع آمریکا از اعزام نیرو به اوکراین را نشانه «ضعف» توصیف میکند

- رئیس جمهور کلمبیا پس از حمله به ناوگان تونبرگ، تمام دیپلماتهای اسرائیلی را اخراج کرد

- دانشمندان دریافتهاند که خطر ابتلا به زوال عقل به کیفیت عضلات بستگی دارد

- نبنزیا: گفتگوی خوبی با نماینده جدید آمریکا در سازمان ملل داشتم

- مکرون احتمال سرنگونی جنگندههای روسی در صورت ورود به حریم هوایی اروپا را رد نکرد

- تعداد کشتهشدگان سیل در اودسا افزایش یافت

- دانشمندان روسی پرسشنامه سادهای تهیه کردهاند که ابتلا به افسردگی در جوانان را پیشبینی میکند

- مشاور سابق پنتاگون: غرب بهای حمایت از اوکراین را خواهد پرداخت و روسیه شرایط برنده را تحمیل خواهد کرد

- تعدیل نیرو در ناسا به دلیل تعطیلی دولت آمریکا

- ونس: دموکراتها برای مطالبه مزایای مهاجران غیرقانونی، دولت را تعطیل میکنند

- نشانههای پنهان زوال عقل در جوانان شناسایی شد

- ترامپ: تعطیلی دولت اجتنابناپذیر نیست، اما محتمل است

- دولت مراکش به اعتراضات جوانان پاسخ میدهد| خواستار گفتگوی مسئولانه برای یافتن راهحلهای عملی است

- روته اوکراین را خط اول دفاعی ناتو نامید

- پاری سن ژرمن چهار بازیکن کلیدی خود را در بازی مقابل بارسلونا از دست داد

- دانشمندان راهی برای نجات سرزمینهای آفریقایی از خشکسالی پیدا کردهاند

- ترامپ تهدید کرد که در صورت پیروزی زهران ممدانی در انتخابات شهرداری نیویورک، این شهر را از بودجه فدرال محروم خواهد کرد

- یک نمونه اولیه ژن درمانی برای بیماری که سیستم عصبی را از بین میبرد، ساخته شده است

- مشاور سابق ترامپ به او توصیه میکند که به همه استدلالها در مورد اوکراین گوش دهد و آنها را بسنجد

- کاروان موتوری رئیس جمهور اکوادور مورد حمله قرار گرفت

- فدراسیون فوتبال عربستان سعودی رسماً به گزارشهایی مبنی بر تمایل بنزما برای ترک این تیم واکنش نشان داد

- زنان در نیروهای مسلح اوکراین از آزار و اذیت توسط سربازان دیگر شکایت داشتند

- یک پزشک توضیح داد که آیا ویتامین D میتواند از سرطان روده بزرگ جلوگیری کند یا خیر

- اوربان: من به ترامپ گفتم که نتیجه درگیری در اوکراین از پیش مشخص است و پیروزی از آن روسیه است

- مسکو: نتایج انتخابات مولداوی گواه شکاف اجتماعی است

- لهستان جنگندههای شوروی را برای فروش میگذارد

- سفیر روسیه: ناتو قصد دارد در بلغارستان پایگاه نظامی ایجاد کند

- مسکو و هانوی در حال بررسی امضای توافقنامهای برای ساخت یک نیروگاه هستهای در ویتنام تا پایان سال هستند

- لوکاشنکو از ترامپ میخواهد که برای فروش سلاح به اتحادیه اروپا و سپس تحویل آنها به اوکراین برنامهریزی نکند

- دولت بریتانیا قصد دارد ۱۲ شهر جدید بسازد

- دانشمندان دستورالعملهای بهروز شدهای برای درمان فشار خون بالا ارائه دادهاند

- روشی جدید برای کاهش وزن بدون ورزش کشف شد

- مجارستان به شدت به اتهامات اوکراین در مورد پهپادها پاسخ داد: «این یک دروغ است و زلنسکی هذیان میگوید.»

- سیارتو: سپیگا از ناتوانی کییف در کشاندن بوداپست به جنگ ناامید است

- یک استایلیست، شیکترین رنگهای پاییز ۲۰۲۵ را معرفی کرد

- یک افسانه رایج در مورد تمرینات شکمی رد شد

- دانشمندان کشف کردهاند که چگونه باکتریها بدون غذا زنده میمانند

- غذاهایی که خطر سکته مغزی را افزایش میدهند، شناسایی شدند

- پزشک علل گزگز و بیحسی پاها را نام برد

- مصر: بزرگترین نیروگاه هستهای جهان چگونه از اقتصاد ملی حمایت میکند؟

- بزرگترین شکارچی دریایی در تاریخ زمین، همه چیزخوار بود

- پس از یک هفته تلاش، فرودگاه برلین نتوانست سیستم خود را که در اثر حمله سایبری مختل شده بود، بازیابی کند

- بلومبرگ: تغییر موضع ترامپ در قبال اوکراین برای کییف خوب نیست

- دیدار ترامپ با رهبران کنگره در بحبوحه تهدید تعطیلی دولت در ایالات متحده اعلام شد

- دانشمندان روسی روش جدیدی برای پاکسازی سواحل آناپا از نفت کوره پیدا کردهاند

- رئیس جمهور کلمبیا خواستار انتقال مقر سازمان ملل از نیویورک شد: «زمان تغییر فرا رسیده است»

- یک سیاستمدار فرانسوی، اوکراین و اتحادیه اروپا را متهم میکند که «با بهانههای واهی، خود را برای یک درگیری تمامعیار با روسیه آماده میکنند»

- ماسک ارتباط خود با اپستین را فاش کرد

- دانشمندان دریافتند مواد شیمیایی پلاستیکی ریتم شبانهروزی را مختل میکنند

- شهردار پورتلند میگوید این شهر به نیروهای ترامپ نیازی ندارد

- دانشمندان کشف کردهاند که سیاره زهره سیارکهای خطرناکی را برای زمین پنهان کرده است

- ترامپ، افبیآی را متهم میکند که صدها مأمور را در میان جمعیتی که در سال ۲۰۲۱ به ساختمان کنگره حمله کردند، قرار داده است

- در جریان مانورهای ناتو، پهپادهایی در نزدیکی یک پایگاه هوایی نروژ مشاهده شدند

- غرب، زلنسکی را فردی نامتعادل اعلام کرده است

- یک رسوایی جنسی تکان دهنده، مدرسهای در نیویورک را به لرزه درآورد.

- لاوروف: اوضاع غزه به شدت بحرانی است

- لاوروف: تلاش برای محاصره اوراسیا مرحله جدیدی از گسترش ناتو را آشکار کرد

- هند نسبت به فلج شدن سازمان ملل به دلیل رد اصلاحات هشدار داد| جایشانکار خواستار شورای امنیت با نمایندگان بیشتر شد

- رویترز: ناتو پس از حوادث پهپادی در دانمارک، حضور خود را در دریای بالتیک تقویت میکند

- رابطه دی بروین و کونته فاش شد

- روز رویایی رایو وایکانو

- دراکسلر دوران حرفهای خودش را «کاملاً عالی» میداند

- یک قهرمان اروپایی خودش برای جذب رابرت لواندوفسکی آماده میکند

- تیم جدید برای تن هاخ؟

- رم از نظر مالی تقویت میشود

- گرانترین بلیط برای فینال جام جهانی ۲۰۲۶، ۶۷۳۰ دلار و ارزانترین آن ۲۰۳۰ دلار قیمت دارد

- یک ابررایانه پس از دور دوم مسابقات، آرسنال را به عنوان مدعی اصلی قهرمانی لیگ قهرمانان اروپا معرفی کرد

- سمین: برای غیرت، بازی مقابل رئال مادرید همین الان هم یک موفقیت بزرگ است

- مهمان جدید در مناقصه برای جاشوا زیرکزی

- جاهطلبی آنتوان گریزمان: «ما همیشه بیشتر میخواهیم»

- جوزپه ماروتا واقعیت تلخ سری آ را به تصویر میکشد

- امباپه سومین هتتریک خود در بازیهای خارج از خانه لیگ قهرمانان اروپا را به ثمر رساند و با اسطوره میلان برابری کرد

- امباپه پس از مسی، جوانترین بازیکنی است که به رکورد ۶۰ گل در لیگ قهرمانان اروپا میرسد

- مانوئل نویر در بین شش بازیکن برتر تاریخ لیگ قهرمانان اروپا قرار گرفت

- اثر جدید راجر اشمیت

- دکو آینده فرمین لوپز و مارک کاسادو را روشن میکند

- آینده رودریگو بنتانکور قطعی شد

- سرنخهای جدید در مورد آینده چهار بازیکن بارسلونا

- تیمو ورنر به لیگ اسپانیا میرود؟

- برنامههای کیهران تریپیر فاش شد

- مربی تورنتو در مورد این بازیکن ایتالیایی در MLS میگوید: «او قبل از اینکه مسی از راه برسد، مسی این لیگ بود.»

- رئال مادرید در فصل ۲۰۲۵/۲۰۲۶، هشت بازی از نه بازی خود را برده است

- رئیس سابق بلوگرانا به کلاهبرداری در انتقال مالکوم و گریزمان متهم شد

- سانتیاگو سولاری، در فهرست بزرگ باشگاه الاتحاد

- لیورپول تلاش میکند از انتقال به رئال مادرید جلوگیری کند

- آینده مبهم رافا مارین

- یورگن کلوپ: حالا همسرم تصمیم میگیرد چه زمانی به تعطیلات بروم، نه لیگ برتر یا بوندسلیگا

- اینتر و میلان در مورد خرید سن سیرو بیانیه مشترکی منتشر کردند

- یورگن کلوپ در مورد دوران مربیگریاش میگوید: «من همه چیز داشتم.»

- گزینه جدیدی برای جایگزینی روبن آموریم

- هشدار اکیتیکه!

- رئال اویدو از یک ستون محافظت میکند

- منچسترسیتی، بازیکن بایرن مونیخ را به عنوان جانشین بلندمدت رودری میبیند

- کورتوا دومین دروازهبان تاریخ رئال مادرید است که در یک بازی لیگ قهرمانان اروپا پاس گل میدهد

- رئیس باشگاه بایر لورکوزن از لزوم تعیین سقف دستمزد در فوتبال به دلیل لیگ برتر صحبت میکند

- مارک گوئهی، یک خرید بدون هزینه در کانون توجه

- لیگ برتر انگلیس به دنبال جذب ستاره بارسلونا است

- تصمیم با نیکولاس جکسون گرفته شد

- جدول رده بندی کلی لیگ قهرمانان اروپا پس از پایان دور دوم

- بارسلونا در پنج بازی اخیر خود در لیگ قهرمانان اروپا تنها یک برد کسب کرده است

- دروازه بان ۱۸ ساله غیرت پس از بازی با رئال مادرید یک ماشین هدیه گرفت

- رئال مادرید در حال حاضر ۳ شکست بزرگ را تجربه میکند

- OM از عدم دسترسی طولانی مدت به فاکوندو مدینا خبر داد

- رسوایی بزرگ پس از بازی غیرت آلماتی-رئال مادرید

- باومن، دروازهبان هوفنهایم: نویر یکی از سه دروازهبان برتر جهان است

- کمپانی در مورد بازی با پافوس: قبرسیها دیدند که چقدر برایشان احترام قائلیم

- نویر در مورد گلی که مقابل پافوس از دست داد: «تا حالا دروازهبان بودی؟»

- چگونه میتوان سقوط وحشتناک وینیسیوس جونیور به جهنم را توضیح داد؟

- تیم ملی فرانسه: دیدیه دشان شگفتیهای بزرگی را آماده میکند

- رئال مادرید: فده والورده در بحبوحه یک جنجال مشتش را روی میز کوبید!

- امباپه: آیا کاماوینگا زیاد به برزیل سفر میکند؟ بله، او نیمه برزیلی و نیمه فرانسوی است

- کوریره دلو اسپورت: رم به دیبالا قرارداد جدیدی پیشنهاد میدهد

- باشگاه اینترمیلان در مورد مصدومیت مارکوس تورام بیانیهای صادر کرد

- کیلیان امباپه، چه خرید بزرگی!

- یوونتوس تورین به دنبال یک هافبک آیندهدار است

- منچستریونایتد جانشین هری مگوایر را ترجیح میدهد

- سالیبا در مورد تمدید قراردادش با آرسنال گفت: «خوشحالم، اما نه صد در صد. ما باید جامها را ببریم.»

- کین در ۱۰۵ بازی برای بایرن مونیخ، ۱۰۲ گل به ثمر رساند

- آنتونی در مورد منچستریونایتد: «آنها به من بیاحترامی کردند.»

- منچستر سیتی خواهان جذب ژول کونده شد!

- گالاتاسرای با سرود «تو هرگز تنها قدم نخواهی زد» لیورپول را مسخره کرد

- کریستین پولیسیچ، یک عامل عالی برای آث میلان

- جولیان آلوارز علاقه باشگاه بارسلونا را رد کرد

- کازانسکی در مورد بازی چلسی مقابل بنفیکا: مارسکا باید در مورد چنین رفتاری کاری انجام دهد

- کرگر نام بازیکن لیورپول را که باید از تیم کنار گذاشته شود، اعلام کرد

- تهدید سهگانه اثر رونالد آراخو

- فده والورده، یک مشکل جدید برای رئال مادرید

- خولیان آلوارز پس از پیروزی: «من برای خودم سقفی تعیین نمیکنم.»

- کرگر در مورد شکست لیورپول مقابل گالاتاسرای: «این یک نمایش باشگاهی درجه یک نبود»

- دیویف: ژائو ویکتور یکی از سریعترین مدافعان میانی حال حاضر لیگ روسیه است

- باشگاه فوتبال قاسم پاشا ترکیه به دلیل حکم بازداشت مالک آن، تحت کنترل دولت قرار گرفته است

- مانور برای جذب پائولو دیبالا آغاز شد

- اریک گارسیا، اف سی بارسلونا را مهار کرد

- پرونده فرنکی دی یونگ بسته شد!

- بروسیا دورتموند در دور دوم لیگ قهرمانان اروپا، اتلتیک بیلبائو را شکست داد

- کین در مورد بازی مقابل پافوس: پیروزی خوبی در خارج از خانه بود

- ناپولی در بازی لیگ قهرمانان اروپا اسپورتینگ را شکست داد| هویلند دو گل زد و دی بروین دو پاس گل داد

- آخرین رقص لوکا مودریچ

- رودریگو مونیز، قراردادش را تمدید کرد