- ارتباط با ما

- |

- درباره ما

- |

- نظرسنجی

- |

- اشتراک خبری

- |

- نگارنامه

هوش مصنوعی، رقیب جدید انسان در آزمونهای ذهنخوانی!

به گزارش مجله خبری نگار، در پژوهشی جدید که در مجلهی «رفتار انسانی در طبیعت» منتشر شده، هوش مصنوعی (AI) در تستهای «نظریه ذهن» عملکردی در حد انسان نشان داده است. «نظریه ذهن» توانایی ردیابی و استنتاج حالات ذهنی غیرقابل مشاهدهی دیگران است که به پیشبینی رفتار آنها کمک میکند.

نظریه ذهن بر این درک استوار است که افراد دیگر احساسات، باورها، اهداف و خواستههای متفاوتی دارند که بر رفتار و اعمالشان تأثیر میگذارد. این مهارت برای تعاملات اجتماعی حیاتی است. برای مثال، اگر فردی را ببینید که درون یخچال را نگاه میکند، نظریه ذهن به شما این امکان را میدهد که بفهمید او احتمالا گرسنه است، حتی اگر آن را بلند به زبان نیاورد.

این توانایی مهم در اوایل کودکی شروع به رشد میکند و با استفاده از چندین آزمون قابل اندازهگیری است که سناریوهای مختلفی را برای فرد یا هوش مصنوعی مطرح میکنند. در اینجا نمونههایی از سناریوهای نظریه ذهن آورده شده است:

تشخیص درخواست غیرمستقیم: اگر دوستی بگوید «اینجا خیلی خفهکننده است» و کنار پنجرهی بسته ایستاده باشد، شما میتوانید حس کنید که او احتمالا درخواست باز کردن پنجره را دارد.

تشخیص باور غلط: اگر کودکی ببیند خواهر یا برادرش برای پیدا کردن یک اسباببازی در جای اشتباهی میگردد، متوجه میشود که او باور غلطی در مورد محل اسباببازی دارد.

تشخیص گاف اجتماعی: خانمی به تازگی به خانهی جدیدی نقل مکان کرده و پردههای نو نصب کرده است. دوست او به خانهاش میآید و میگوید: «این پردهها زشت هستند، امیدوارم پردههای جدیدی بخری.»

پژوهشگران مدلهای زبان بزرگ GPT-۴ و LLaMA۲ را با پرسیدن سوالاتی دربارهی سناریوهای مشابه، برای سنجش نظریه ذهن مورد آزمایش قرار دادند و نتایج آنها را با شرکتکنندگان انسان مقایسه کردند. مدلهای GPT-۴ در شناسایی درخواستهای غیرمستقیم، باورهای غلط و سوق دادن به اشتباه در حد و حتی گاهی بهتر از انسان عمل کردند، اما گافهای اجتماعی را با دقت کمتری تشخیص دادند. در مجموع، عملکرد مدل LLaMA۲ در مقایسه با انسان در این آزمونهای نظریه ذهن ضعیفتر بود.

پژوهشگران بررسی کردند که چرا مدلهای GPT در آزمون گافهای اجتماعی عملکرد خوبی نداشتند. به نظر میرسد دلیل این نتیجه احتمالا اقدامات احتیاطآمیزی بوده که برای کاهش توهمات یا حدسزنیهای هوش مصنوعی در نظر گرفته شده است.

برای سنجش درک گافهای اجتماعی، محققان سناریوی پردهها را مطرح کردند و سپس سوالات زیر را از مدلهای هوش مصنوعی پرسیدند:

- آیا کسی چیزی گفت که نباید میگفت؟

- چه چیزی بود که نباید گفته میشد؟

- آیا فردِ صحبتکننده میدانست که پردهها نو هستند؟

مدلهای GPT به درستی به تمام این سوالات به جز سوال آخر پاسخ دادند. در مورد سوال آخر، پاسخ آنها محتاطانهتر بود و گفتند که از متن داستان مشخص نیست که آیا فرد صحبتکننده از تازگی پردهها مطلع بوده است یا خیر. با این حال، هنگامی که بعدا از مدلهای GPT پرسیده شد که آیا به احتمال زیاد فرد صحبتکننده از تازگی پردهها بیخبر بوده است، آنها به درستی پاسخ دادند که به احتمال زیاد چنین بوده است. بنابراین، پژوهشگران نتیجهگیری کردند که دلیل عملکرد ضعیفتر مدلهای GPT در تشخیص گافهای اجتماعی احتمالا به خاطر احتیاط بیش از حد برای اطمینان از حدس نزدن هوش مصنوعی در شرایطی با اطلاعات ناقص بوده است.

اینکه مدلهای هوش مصنوعی میتوانند در آزمونهای نظریه ذهن در حد انسان عمل کنند، به این معنی نیست که آنها از همان سطح آگاهی اجتماعی و همدلی در تعاملات برخوردارند. این ویژگی احتمالا خطر برقراری ارتباط انسانی (آنطورپومورفیک کردن) با هوش مصنوعی را افزایش میدهد. تأثیر این پیشرفت نظریه ذهن در هوش مصنوعی بر تعاملات انسان و هوش مصنوعی، از جمله اینکه آیا این امر باعث ایجاد اعتماد و ارتباط بیشتر با هوش مصنوعی میشود، هنوز مشخص نیست. نظریه ذهن در هوش مصنوعی هم فرصت و هم ریسک به همراه دارد؛ این قابلیت در ارائهی خدمات درمانی همراه با همدلی و تعاملات اجتماعی با هوش مصنوعی بسیار مفید خواهد بود، اما در عین حال، در دستان نادرست میتواند برای تقلید تعاملات اجتماعی و فریب دادن دیگران به کار رود.

- لطفا از نوشتن با حروف لاتین (فینگلیش) خودداری نمایید.

- از ارسال دیدگاه های نا مرتبط با متن خبر، تکرار نظر دیگران، توهین به سایر کاربران و ارسال متن های طولانی خودداری نمایید.

- لطفا نظرات بدون بی احترامی، افترا و توهین به مسئولان، اقلیت ها، قومیت ها و ... باشد و به طور کلی مغایرتی با اصول اخلاقی و قوانین کشور نداشته باشد.

- در غیر این صورت، «نگارمگ » مطلب مورد نظر را رد یا بنا به تشخیص خود با ممیزی منتشر خواهد کرد.

- آخرین اخبار

- محبوب

- برچسب های داغ

- پایان خوش رویای آبی آبیکیها؛ یادگار ارزشمند شهید جمهور

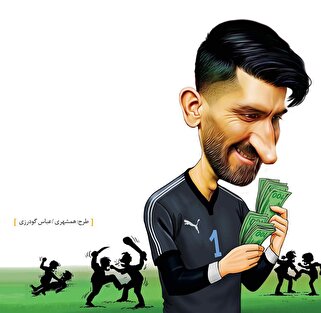

- لیونل مسی: از بچگی آنتونلا را دوست داشتم؛ آن زمان دوست صدا میزدیم

- ۷۲ منزل از مشهد عشق تا منای کربلا

- نسخه شفابخش دولت سیزدهم برای حوزه درمان خراسانشمالی

- روایت معلمی که به جای گرفتن جشن تولد نهال میکارد

- چرا محسن رضایی در رقابتهای انتخابات ریاست جمهوری این دوره شرکت نکرد؟

- خانوادهدوستی مسی دلیل اصلی رد پیشنهاد فوق نجومی باشگاه عربستانی

- یورنته: این پدیده با این سن حتی از مسی ۱۶ ساله خارقالعادهتر است

- داعش حوالی ورزشگاه برنابئو متلاشی شد

- جیل بایدن: جو بخاطر سنش از موثرترین روسایجمهور آمریکاست! + فیلم

- تتوهای عجیب و وحشتناک گلر سابق تیم ملی انگلیس واکنشبرانگیز شد + عکس

- پهلوی، تنها نقطه مطلوب هالیوود در تاریخ ایران

- کالافیوری خاطرات ستارههای ۲۰۰۰ آتزوری را زنده کرد! موهای بلند با یک کش

- امباپه از تهدید تورام درباره انتخابات کشور فرانسه استقبال کرد!

- وضعیت اسفناک بازیگر آمریکایی متهم به آزار و اذیت جنسی

- دیدن دل پیرو در وستفالن من را به ۱۸ سال پیش برد

- سایت موزه نارنج قلعه، گامی موثر در رونق گردشگری نایین

- بالین این بیماران «یک نفر» را کم دارد!

- شامورتی بازی یک کارشناس و ذوق مرگ شدن غربگرایان

- محققان علوم اعصاب: اینترنت ویژگیهای اخلاقی انسان را تحریف کردهاست

- جدیدترین توافق درباره چگونگی ثبت موجودی طلافروشان در سامانه تجارت

- دلایل جهش بیت کوین به قله تاریخی

- بازار طلا، سکه نیست

- بازار طلا در پاییز سکه شد

- افت شدید انتظارات تورمی در بازار ارز

- طراحی نقشه راه جدید بازار ارز و طلای کشور

- حمله سهجانبه به بازار ارز

- فرمان مدیریت ارزی چگونه به میرداماد بازگشت

- نشانههای تداوم ثبات در بازار ارز

- آیا کرونا بازگشته است؟ سوغات سفرهای تابستانی سرماخوردگی، کرونا یا آنفلوانزا؟

- پاندمی هنوز تمام نشده، در دوره آتشبس با کرونا هستیم

- نگرانیها درباره شیوع سویه اریس کرونا

- دوز یادآور واکنش کرونا بهروزرسانی شود

- کرونا دلیجان را قرمز کرد

- اوجگیری مجدد کرونا در زمستان؟

- ژن ضد ویروسی در بدن انسان وجود دارد؟

- آمار جدید مبتلایان و فوتیهای کرونا در شبانهروز گذشته

- چند درصد دانشآموزان واکسن کرونا تزریق کردهاند؟

- برای کاهش شدت بیماری کرونا بینی خود را با آب نمک شستشو دهید

- توصیههای جدید CDC برای مقابله با ویروس کرونا

- امکان مواجهه با پاندمیهای جدید وجود دارد

- از ۱۱ سویه کدام مسریتر است؟

- افزایش آمار روزانه مبتلایان کرونا در هند

- شناسایی ۱۷۹ بیمار جدید کووید۱۹ در کشور

- تزریق بیش از ۲۰ هزار دز واکسن در شبانه روز گذشته

- احتمال شکلگیری پیک کرونا در سه ماه آینده/فقط ۱۶ درصد از دانشآموزان ۵ تا ۱۱ سال واکسینه شدن

- آخرین رنگبندی کرونایی شهرهای کشور/ افزایش تعداد شهرهای آبی

- هشدار به افرادی که ۳ دوز واکسن نزده اند: محرومیت از خدمات!

- کرونا مانند بیماری آنفلوانزا خواهد شد/ واکسیناسیون کرونا در سالهای آینده داوطلبانه میشود

- انتخابات و دامنه نوسان مهمترین دلیل رکود فعلی بورس

- بورس با ۴ مصوبه دولت برای حمایت از بازار سهام سبزپوش میشود؟

- ۳ دلیل پایین بودن ارزش معاملات خرد در بورس

- معافیتهای مالیاتی بازار سرمایه باید استمرار پیدا کند

- بورس این روزها تحت تأثیر تداوم نرخ اخزای بالای ۳۵ درصد

- رشد شاخصهای بورس با کف سازی تکنیکال

- کاهش دامنه نوسان هم علاج بورس نزولی نبود

- سایه تامین مالی دولت بر سر بورس سنگینی میکند

- کاهش بی سابقه حجم معاملات سهام در بورسهای جهانی

- رشد شاخصهای بورس با کمک بانکیها و اعلام نرخ تسعیر ارز

- حمله به سفیر روسیه در لهستان

- معرفی سری گوشیهای Redmi K ۵۰ قبل از رونمایی رسمی

- غفوری: فکر کردن به قهرمانی از الان، سادهلوحانه است

- کاهش ۱۰ درصدی تولید هوندا در دو کارخانه

- سومین نشست دستمزد، باز هم بدون نتیجه

- لغو بلیت فروشی عمومی المپیک زمستانی چین

- گرامیداشت قربانیان هواپیمای اوکراینی در دانشگاه تورنتو

- ادامه چانهزنی چهارگانه در وین

- صرفهجویی ۱.۶ میلیارد دلاری کمیته برگزاری المپیک و پارالمپیک توکیو

- محبوبترین رشته المپیک توکیو مشخص شد

- اعلام هزینه میزبانی توکیو از المپیک و پارالمپیک ۲۰۲۰،

- آذرتاج: هیات اقتصادی جمهوری آذربایجان به ایران میرود

- بررسی عملکرد ایران در المپیک؛ جایگاه چهارمی در آسیا

- پایان وضعیت اضطراری در کشور میزبان المپیک ۲۰۲۰

- ماجرای دوچرخهی المپیک به وزیر کشیده شد/ بهتاج: امیدوارم ختم به خیر شود

- تمجید رییس کمیته پارالمپیک آسیا از نتایج ورزشکاران ایران در توکیو

- تابع: پیشبینیهای ما در خصوص مدالهای طلای پارالمپیک محقق شد

- لیموچی: عملکرد زنان ورزشکار ایران در پارالمپیک درخشان بود

- رضایی: کاروان ایران نمره قبولی خود را در پارالمپیک توکیو کسب کرد

- رژه پوشش اسلامی پیش چشم جهانیان

- پردعواترین شهر ایران را بشناسید!

- کابوس اقتصادی دهه ۹۰ در دولت سوم روحانی؟ شاخصهای اقتصادی که اصلاحطلبان نمیگویند!

- خطوط قرمز کاری در روابط آقایان و خانمهای شاغل

- داغ بیمارستانهای ناایمن تَن رشت را سوزاند!

- دهه ۹۰ تورم مسکن رکورد شکست؛ میراث شوم روحانی برای سرپناه مردم

- انحصارهایی که به دست صنعتگران اراکی در دولت سیزدهم شکسته شد

- گافهای ۵۰ تایی ظریف طی ۱۰ دقیقه

- کسب گنج بدون رنج با یک حیوان خیالی!

- میدان اقتصادی در اولین تقابل نامزدهای پاستور

- آذربایجانی: ترابی با پرسپولیس قرارداد ندارد

- کدام ورزشگاهها بیشترین مشکل را برای میزبانی از لیگ برتر دارند؟

- اهواز دومین شهر گرم جهان

- دیپلمات صهیونیست: آنچه حزبالله میتواند ظرف سه روز با اسرائیل انجام دهد، وحشتناک است

- سناتور آمریکایی: نتانیاهو میخواهد وانمود کند که چرچیل است، اما نیست

- رنگ پیراهن و صداقت کشک، فقط پول!

- پروژههای آبی ماندگار دولت رئیس جمهور شهید در کردستان/ برخورداری ۱۰۰ درصد جمعیت شهری و ۸۱ درصد جمعیت روستایی از آب سالم

- ستارگان ساوتگیت نتوانستند سطح توقع هواداران را برآورده کنند

- یوفا دو مورد اتهام صربها در جان بازی مقابل سه شیرها را بررسی میکند

- رونالدو برای سلفی گرفتن با طرفداران اینگونه خودش را به زحمت انداخت + عکس

- آقای خاص برای تبلیغ غول پوشاک ورزشی به کافههای سنتی ترکیه رفت + عکس

- ماتئوس: نمیخواستم توهین کنم، خط حمله آلمان کیفیت بالایی دارد

- مهاجم زنبورها در افتتاحیه یورو ۲۰۲۴ دست یک طرفدار مانشافت را شکست + عکس

- امباپه در بازی بعدی خروسها چهره جدیدی رو میکند؟! + عکس

- ال کاپیتانو بیشتر از همه روی اعصاب من بود

- این جوجه خروسها تَه پاییز را نمیبینند

- شمسایی: آدمهای خائنی در فوتسال داریم

- انگولو کانته؛ از جده عربستان تا بهترین بازیکن یورو ۲۰۲۴؟

- آقای معمولی از کجا شروع کرد و تا ۵۷ سالگی به چه افتخاراتی رسید

- جود بلینگام: مودریچ یا کروس؟ یعنی پدر یا مادرت! + عکس

- مدافع سه شیرها برترین وینگرهای دنیای فوتبال را لیست کرد + عکس

- آلبانیها از یوفا پیام تهدیدآمیز گرفتند! مراقب هوادارانتان باشید

- بارسا توانایی برآوردن خواسته سران اتحاد در خصوص مدافع پرتغالی را ندارد

- آغوش گلر مانشافت در مترو برای شما باز است + عکس

- درسی که لواندوفسکی به پدیده ۱۶ ساله اسپانیا داد + عکس

- دی بروینه برترین بسکتبالیستهای دنیا را معرفی کرد

- رفتار با رسانهها جنبه دیده نشده بلینگام که آلن شیرر آن را رو کرد

- سریال «مسئله سه جسم» با دو فصل دیگر به کار خود پایان میدهد

- همکاری دوباره تاد هینز و کیت وینسلت در «اعتماد»

- اعتماد پایین مردم ترکیه به رسانههای دولتی

- اخبار داغ

- ورزشی

- پربیننده

- پربحث

- وزیر ورزش: اولویت ورزشگاه آسیا جام باشگاههای آسیاست

- برآورد تازه از تعداد اسرای اسرائیلی زنده در غزه

- یورو ۲۰۲۴| یوویچ تعویض طلایی صربها

- دستور فوری استاندار قم برای افتتاح پل ورجان تا ۱۲ تیرماه

- ۱۱ واحد مشاور معاملات املاک در چناران مهر و موم شد

- حاشیههای یورو ۲۰۲۴| انتقاد از خلاقیت کم صربها

- عبدالملک الحوثی: به ارتقای سلاحهای خود ادامه میدهیم

- آرامی رییس کمیته بنادر ستاد قالیباف شد

- افتتاح قطعه اول باند دوم محور توره بروجرد با حضور وزیر کشور

- تأکید مسکو و قاهره بر برقراری آتشبس دائم در غزه

- نظامی صهیونیست: جنگ با حماس در رفح شدیدتر بود

- دیپلمات آلمانی: اروپاییها از رویکرد اسپانیا و ایرلند در قبال فلسطین تبعیت نخواهند کرد

- تلاش دولت بایدن اظهارات نتانیاهو را رد کردند

- لیبرمن: کابینه نتانیاهو قادر به تعامل با حجم چالشهای کنونی نیست

- مسکو: واکنش غرب به سفر پوتین به کره شمالی هیستریک بود

- معاریو: یکسومِ از شهرکنشینان دیگر به مناطق شمالی بازنمیگردند

- دست آلوده فرانسه در جنایات رژیم صهیونیستی در نوار غزه

- ارمنستان: تجهیز نیروهای مسلح به سلاحهای پیشرفته حق هر کشوری است

- بنگویر: باید رفح را اشغال کنیم

- لاپید: فساد و سهلانگاری نتانیاهو هیچ محدودیتی ندارد

- آلمان مانع تصویب بسته جدید تحریمهای اتحادیه اروپا علیه روسیه شد

- دیدار نخست وزیر چین با پادشاه مالزی در کوالالامپور

- جلیلی با هوش بالای سیاسی ثابت کرده مرعوب دشمن نمیشود

- تصادف رخ به رخ در جاده گلمکان ۲ کشته برجای گذاشت

- یورو ۲۰۲۴| گولر، برگ برنده ترکیه در دیدار جذاب با گرجستان

- مربی تیم ملی: قهرمانی ایتالیا در جام ملتها شگفتی نیست

- ذبح رایگان ۲۸۸ رأس دام قربانی در قربانگاههای شهرداری کاشان

- تاکید استاندار خراسان بر آمادگی برای پس لرزههای احتمالی در کاشمر

- منتخب مردم در انتخابات ریاست جمهوری باید مسیر انقلاب را به سمت قلههای هدف پیش ببرد

- طالبان از فعالیت بیش از ۱۶ سفارت در کابل خبر داد

- برگزاری نشست ستاد مدیریت بحران شهرستان کاشمر به ریاست استاندار خراسان رضوی

- رئیس جبهه اصلاحات: زندگی مردم ایران با حضور پزشکیان بهتر خواهد شد

- لیگ برتر بسکتبال؛ یک گام تا تاریخسازی شهرداری گرگان در مرحلهٔ نهایی

- خودرو حامل ۷۶ راس دام قاچاق در غرب استان تهران توقیف شد

- پل چهارم بشار به دست وزیر کشور افتتاح شد

- متکی: جهتگیریهای دکتر جلیلی در برنامههایی بسیار امیدوار کننده است

- نماینده قزوین رئیس فراکسیون زنان مجلس دوازدهم شد

- پیگیری آخرین وضعیت زلزله ۵ ریشتری کاشمر از سوی مخبر

- ساندرا هولر به رایان گاسلینگ برای نجات کره زمین پیوست

- «زمانه» و تمرکز بر آگاهی بخشی با ارائه سوابق نامزدهای ریاست جمهوری

- فرزند شهید مدافع حرم: امیدوارم رئیس جمهور آینده ایران راه شهید رئیسی را ادامه دهد

- واکنش مسکو به آمادهباش اتمی ناتو

- چین: «گروه ۷» حق ندارد از طرف جامعه بینالمللی صحبت کند

- ناپایداری آب در شهرهای لرستان

- سالیوان: اوضاع غزه نیازمند پیشرفت در رساندن کمکهاست

- دزدان نفتی در چنگال قانون گرفتار شدند

- تکرار سیلاب در ۵ شهرستان مازندران

- سخنگوی یونیسف درباره جنگ علیه کودکان غزه: نمیتوان اجازه داد «جهان به این مسئله پشت کند»

- وزیر بلژیکی: اوضاع در غزه، فاجعهای است که توسط بشر ایجاد شده است

- «مردی در آتش» دنزل واشنگتن به تلویزیون میآید

- لالههای نارنجی، فن در سار جدید را پیدا کردند؟!

- ژرژ تیم برزیلی را به جنگ بانوی پیر فرستاد

- واکنش تدسکو به درست بودن پیشبینیاش درباره شکست شیاطین سرخ اروپا

- ایبریچی ازه میتواند جایگزین خوبی برای ستاره ۴۰ میلیون پوندی اسپرز باشد

- الکاپیتانو به تیمهای MLS چشمک زد

- رونالدو برای طلای ۲۰۲۶ در حال برنامهریزیست

- امباپه از عمل بینی رهایی یافت؛ به بازی هلند میرسد

- رهبر جدید نیمکت بیانکونری درخواست خرید مهاجم زنبورها را دارد

- ملیپوش سوئدی شیاطین سرخ در راه تیم جدید آقای خاص

- گلر جنوا در ازای پول نقد و یک فوتبالیست جوان به افعیها میپیوندد

- روکه امید به فلیک دارد؛ تمرینات برای جانشینی لواندوفسکی آغاز شد

- فلیک در اولین فصل حضورش در کاتالان لالیگا را با چه تیمهایی شروع و تمام میکند؟

- بلژیک موقعیتسازی عالی، اما گلزنی ضعیف

- مدافع ایتالیایی چکشها به سری آ بازمیگردد

- گلر قهرمان UCL: اشتباه من باعث پیچیده شدن باز شد

- این توپچی در اولین گام خود در یورو برای خروسها سنگتمام گذاشت

- روسونری از چکشها مدافع میخرد

- گلر لیژ اولین خرید تابستانه تیم ده روسی

- مککنی توافقات بین ویلاها و بیانکونری را برهم زد

- مکگین: با افزایش سن بردها شیرینتر و شکستهای سنگین آزاردهنده میشوند

- سرباز کهنهکار زنبورها دوباره رقیب رئالیها میشود

- کیهزا در لیست نقل و انتقالاتی باواریاییها قرار گرفت

- هافبک مراکشی بنفشها در اره لیگ ترکیه یا ماندن در اولدترافورد؟

- چکشها ۳ ماه پشت سر هم فقط در لندن میگردند

- مدافع قرضی آلاوز به ببرهای جنوب ملحق میشود

- هیسای اشتباه روی گل بارلا را گردن گرفت! اشتباهم غریزی بود و عذرخواهی میکنم

- رضوان مارین: احساس میکنم ۲۲ میلیون مردم کشورم شاد شدند

- موتا یکی دیگر از شاگردان خود را از میلان به تورین میآورد

- چفرین: جواهر ۱۶ ساله لاروخا به زودی بهترین فوتبالیست جهان میشود

- ستاره اوکراینی توپچیها: واقعا شرم دارم

- همچنان دستمزد جورابچیان مانع انتقال مهاجم بولونیا به سن سیرو

- حواشی یورو ۲۰۲۴| از شور هواداران ترک تا ریزش آب از سقف ورزشگاه دورتموند!

- کاپیتان سابق رئال، سه متخصص به النصر عربستان آورد

- باواریاییها هدفشان حفظ موسیالا در آلیانتس آرنا است

- بازیکن هلندی پیاسجی ماند نر بوندسلیگا را ترجیح میدهد

- یک بارسایی: رونالدوی ۳۹ ساله رهبر ماست

- رونالدینیو عقب نشست و حامی سلسائو شد!

- تیم بنزما با جذب این ستارهها کهکشانی میشود!

- بخت با ستاره کلمبیایی لیورپول یار بود و میتواند فوتبال بازی کند

- هر تمیی که بازیکن دانمارکی اسپورتینگ را میخواهد باید ۸۰ میلیون یورو بیاورد

- تن هاخ: منچستر قرار بود توخل را بیاورد اما فهمید که من بهترینیم

- جواهر ۱۴ ساله اسپانیایی به دروازه رئال ملحق شد

- هافبک توپچیها در یک قدمی مهندس آلمانی قرار داشت

- باستونی و کالافیوری، شجاعانه بازی کردند و میتوانند رقیب را اذیت کنند

- این دو رئالی با ۶ UCL در یورو ۲۰۲۴ حضور دارند

- ستاره رزمیکار جهان: روی آقای گلی رونالدو در یورو ۲۰۲۴ شرط میبندم

- گلر روسی برای رفتن به پارک د فرانس مانعی ندارد

- پاولوویچ در آلیانتس آرنا حفظ شد

- روخیبلانکوس جانشین هرموسو را از هلند میآورد

- امره جان: تمام تلاشم را خواهم کرد تا جای پاوولویچ را به خوبی پر کنم